КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

При проектировании сети данного типа необходимо выполнить две итерации расчета коэффициентов

|

|

|

|

Ход проектирования искусственной нейронной сети встречного распространения производится в соответствии со следующими этапами:

1. Проводится анализ задания на проектирование. Выполняется коди-рование (при необходимости) входной информации. Определяется размер-ность входного вектора и выходного вектора.

2. Разрабатывается структурная схема нейронной сети.

3. Выбираются начальные значения составляющих вектора весовых коэффициентов слоя Кохонена.

4. Определяются значение сетевой функции каждого нейрона слоя Кохонена на один из сигналов первой из распознаванемых групп в соответствии с выражением:

5. Выбирается нейрон, значение сетевой функции которого на выбранный сигнал оказывается большей. Принимается решение, что данный нейрон закрепляется за распознаванием образов первой группы.

6. Осуществляется расчет вектора весовых коэффициентов для этого нейрона для выбранной группы входных векторов в соответствии с выражением:

,

,

где  - скорректированное значение j-той составляющей вектора весовых коэффициентов i-того нейрона для μ -того входного сигнала;

- скорректированное значение j-той составляющей вектора весовых коэффициентов i-того нейрона для μ -того входного сигнала;

- значение j-той составляющей вектора весовых коэффици-ентов i-того нейрона после коррекции по μ-1 входному сигналу;

- значение j-той составляющей вектора весовых коэффици-ентов i-того нейрона после коррекции по μ-1 входному сигналу;

- j-тая компонента μ -того входного сигнала;

- j-тая компонента μ -того входного сигнала;

a – коэффициент скорости обучения.

или в соответствии с (30)

,

,

где  - новое значение вектора весовых коэффициентов, определяемое на текущем шаге,

- новое значение вектора весовых коэффициентов, определяемое на текущем шаге,  - старое значение вектора весовых коэффициентов, опре-деленное на предыдущем шаге, Х – вектор входного сигнала, для которого проводится коррекция весовых коэффициентов i – того нейрона.

- старое значение вектора весовых коэффициентов, опре-деленное на предыдущем шаге, Х – вектор входного сигнала, для которого проводится коррекция весовых коэффициентов i – того нейрона.

Указанная операция осуществляется последовательно для каждого из сигналов выбранной группы заданное число раз.

|

|

|

7. После выполнения последней итерации вычисляются значения сете-вой функции как для сигналов группы, на которую настраивается нейрон, так и для сигналов второй группы.

8. Определяется значение пороговой величины θ, которое должно быть не больше, чем минимальное значение сетевой функции для сигналов распознаваемой группы, но не меньше максимального значения сетевой функции для других групп сигналов. Этим достигается единичный эффект на выходе преобразователя Хевисайда при наличии на входе сигналов распозна-ваемой группы и нулевой эффект для сигналов других групп.

9. Аналогично осуществляется обучение следующих нейронов слоя Ко-хонена.

10. Осуществляется проверка правильности реакции слоя Кохонена на группы входных сигналов.

11. После обучения всех нейронов слоя Кохонена осуществляется обу-чение слоя Гроссберга, на выходе которого должны формироваться сигналы, ассоциированные с группами входных сигналов.

Формирование весов слоя Гроссберга осуществляется в соответствии с выражением (33)

де kl – выход l - го нейрона Кохонена (только для одного нейрона Кохонена он отличен от нуля); уj – j -ая компонента вектора желаемых выходов.

6.3.3. Пример. Выполнить проектирование сети встречного распространения для групп сигналов и ассоциированных с ними:

Группа 1 Группа 2

х 11 =000111 х21=111000

х12 =000110 х22 =101000

х13 =000011 х23=011000

y1=1001 y2 =0110

1. В соответствии с исходными данными размерность входного вектора равна 6, а выходного – 4.

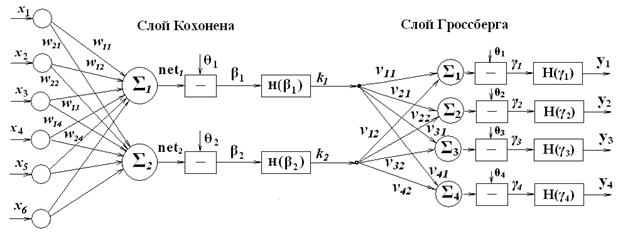

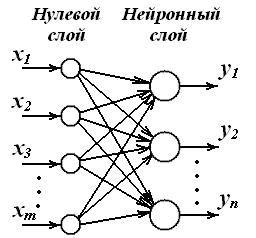

2. В соответствии с п.1 сеть должна иметь 6 входов и 4 выхода. Так как распознается 2 группы сигналов, то слой Кохонена должен состоять из двух нейронов. Так как размерность выходного сигнала равна 4, то слой Грос-сберга должен состоять из 4 нейронов. Структурная схема сети приведена на рис. 9.

Рис. 9

3. Начальные значения весовых коэффициентов слоя Кохонена выбираем равными

|

|

|

W1: w11=0,2; w12=0,5; w13=0,4; w14=0,2; w15=0,7; w16= 0,3

W2: w21=0,5; w22 =0,4; w23 =0,2; w24 = 0,3; w25 =0,8; w26=0,6

4. Определяются значение сетевой функции каждого нейрона слоя Кохонена на один из сигналов первой из распознаваемых групп в соответствии с выра-жением:

В качестве такого сигнала выбираем первый сигнал первой группы. Для него

net1=0,2*0+0,5*0+0,4*0+0,2*1+0,7*1+0,3*1=1,2

net2=0,5*0+0,4*0+0,2*0+0,3*1+0,8*1+0,6*1=1,7

5. Выбирается нейрон, значение сетевой функции которого на выбранный сигнал оказывается большей. В данном случае наибольшее значение сетевой функции получилось у второго нейрона слоя Кохонена. Поэтому он выбира-ется в качестве нейрона, настраиваемого на первую группу сигналов.

6. Осуществляется расчет вектора весовых коэффициентов для этого нейрона для выбранной группы входных векторов в соответствии с выражением (30):

,

,

где  - новое значение вектора весовых коэффициентов, определяемое на текущем шаге,

- новое значение вектора весовых коэффициентов, определяемое на текущем шаге,  - старое значение вектора весовых коэффициентов, опре-деленное на предыдущем шаге, Х – вектор входного сигнала, для которого проводится коррекция весовых коэффициентов i – того нейрона.

- старое значение вектора весовых коэффициентов, опре-деленное на предыдущем шаге, Х – вектор входного сигнала, для которого проводится коррекция весовых коэффициентов i – того нейрона.

Для расчета вектора весовых коэффициентов используем две итерации.

6.1. Первая итерация.

Выбирается значение коэффициента a, равное 0,7.

С учетом этого при корректировке по первому сигналу получаем

При корректировке по второму сигналу

Для третьего сигнала первой группы

6.2. Вторая итерация.

Выбирается значение коэффициента a, равное 0,4.

С учетом этого при корректировке по первому сигналу получаем

При корректировке по второму сигналу

Для третьего сигнала первой группы

7. Вычисляем значения сетевой функции:

для первой группы сигналов:

net11=0*0,003 + 0*0,002+0*0.001+1*0,444+1*0,999+1*0,7=2,143

net12=0*0,003 + 0*0,002+0*0.001+1*0,444+1*0,999+0*0,7=1,443

net13=0*0,003 + 0*0,002+0*0.001+0*0,444+1*0,999+1*0,7=1,69

для второй группы сигналов

net21=1*0,003 + 1*0,002+1*0.001+0*0,444+0*0,999+0*0,7=0,006

net22=1*0,003 + 0*0,002+1*0.001+0*0,444+0*0,999+0*0,7=0,005

net23=0*0,003 + 1*0,002+1*0.001+0*0,444+0*0,999+0*0,7=0,003

8. Определяем значение пороговой величины из условия:

Этому условию удовлетворяет значение θ =1,0.

9. Аналогично осуществляется обучение первого нейрона слоя Кохо-нена для распознавания второй группы сигналов.

10. Осуществляется проверка правильности реакции слоя Кохонена на группы входных сигналов.

|

|

|

11. После обучения всех нейронов слоя Кохонена осуществляется обу-чение слоя Гроссберга, на выходе которого должны формироваться сигналы, ассоциированные с группами входных сигналов.

Формирование весов слоя Гроссберга осуществляется в соответствии с выражением (33)

де kl – выход l - го нейрона Кохонена (только для одного нейрона Кохонена он отличен от нуля); уj – j -ая компонента вектора желаемых выходов.

Так как выходная последовательность представляет собой бинарный сигнал, то в значения весовых коэффициентов принимаются равными 1 для тех составляющих ассоциированных сигналов, которые равны единице. То есть для первого выхода нейрона Кохонена, связанного со второй группой входных сигналов и ассоциированным с ним сигналом, значения весовых коэффициентов связей выхода этого нейрона с нейронами слоя Гроссберга определятся как

v11=0; v21=1; v31=1; v41=0.

Для второго нейрона слоя Кохонена, связанного со первой группой входных сигналов, весовые коэффициенты примут значения:

v12=1; v22=0; v32=0; v42=1.

Если привязать эти коэффициенты к нейронам слоя Гроссберга, то соот-ветственно вектора весовых коэффициентов каждого нейрона Гроссберга когут бать представлены в виде:

V1T = (v11, v12) = (0, 1); V2T = (v21, v22) = (1, 0); V3T = (v31, v32) = (1, 0);

V4T = (v41, v42) = (0, 1).

Так как на выходе сумматоров нейронов слоя Гроссберга могут быть только 1 или 0, то в качестве пороговых значений θi необходимо выбрать величину, большую нуля, но меньше, чем удиница. Например, 0,5.

Выполняется проверка работы сети путем подачи на вход всех сигналов обоих групп и определения совпадений полученных сигналов с ассоциированными.

6.4. Задание 3. Линейная ассоциативная память

6.4.1. Общие сведения

Известны два способа доступа к информации, хранящейся в запомина-ющем устройстве: адресный и ассоциативный. Адресный способ характери-зуется тем, что искомая информация жестко задана адресом - местом ее рас-положения в памяти. Ассоциативный способ доступа к информации основан на установлении соответствия (ассоциации) между хранимой в памяти ин-формацией и поисковыми признаками. Содержимое ассоциативной памяти можно представить в виде множества пар

|

|

|

(34)

(34)

где  - входные векторы, задающие значения поиско-вых признаков образов;

- входные векторы, задающие значения поиско-вых признаков образов;  - выходные векторы, соответст-вующие извлекаемым образам.

- выходные векторы, соответст-вующие извлекаемым образам.

Выделяют два основных типа ассоциативной памяти: гетероассоциативную и автоассоциативную. В первом случае входному вектору X, который "достаточно близок" "к вектору X(μ), хранимому в памяти, ставится в соответствие выходной вектор Y(μ), где μ =1,2,…,p. Во втором случае X(μ) = Y(μ), для всех пар из (34). Поэтому при подаче на вход запоминающего устройства вектора X, "достаточно близкого" к вектору X(μ), на выходе формируется вектор X(μ).

Можно сказать, что ассоциативная память выполняет отображение об-разов входного пространства в выходное пространство. В случае автоассо-циативной памяти размерности входного и выходного пространств совпада-ют, в случае гетероассоциативной памяти размерности указанных прост-ранств различные.

Структурная схема линейной ассоциативной памяти (ЛАП) изображена на рисунке 10.

Рис. 10. Линейная ассоциативная память

ЛАП представляет собой однослойную ШНМ с прямыми связями. Веса связей в такой сети являются фиксированными. Они вычисляются на этапе подготовки сети к работе. Цель функционирования сети заключается в вос-становлении выходного образа на основе полной или неполной входной ин-формации. Входные и выходные значения сети могут быть либо веществен-ными, либо бинарными. Число нейронов ЛАП определяется размерностью выходного вектора.

Матрица весов связей сети соответствует корреляционной матрице, устанавливающей взаимосвязь входных и выходных образов сети

(35)

(35)

где  - внешнее векторное произведение, определяемое как произведение вектор-столбца на вектор-строку.

- внешнее векторное произведение, определяемое как произведение вектор-столбца на вектор-строку.

Если входные и выходные векторы являются униполярными бинарными векторами со значениями 0 и 1, то матрица весов связей определяется выражением

, (36)

, (36)

где yi(μ) и xj(μ)n – соответственно i– тая и j – тая компоненты μ – того выходного и входного векторов. В этой формуле автоматически учитывается среднее значение двоичного признака, равное 0,5. Для того, чтобы сформиро-вать бинарный выходной вектор, каждый выходной НЭ сети сравнивает компоненты вектора  с порогом

с порогом

. (37)

. (37)

Если

, (38)

, (38)

То соответствующий НЭ формирует yi = 1, в ином случае yi = 0.

6.4.2. Проектирование линейной ассоциативной памяти

Ход проектирования линейной ассоциативной памяти производится в соответствии со следующими этапами:

1. Проводится анализ задания на проектирование. Выполняется коди-рование (при необходимости) входной информации. Определяется размер-ность входного вектора и выходного вектора. Определяется число нейронов сети.

2. Разрабатывается структурная схема линейной ассоциативной памяти.

3. В соответствии с выражением (36) определяются весовые коэффици-енты  .

.

4. В соответствии с выражением (37) определяются пороговые значения  .

.

5. Осуществляется проверка правильности работы сети.

|

|

|

|

|

Дата добавления: 2014-12-16; Просмотров: 437; Нарушение авторских прав?; Мы поможем в написании вашей работы!