КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Алгебраические операции над нечеткими множествами 1 страница

|

|

|

|

Алгебраическое произведение A и B обозначается AB и определяется так:

xE AB (x) = A(x)B(x).

Алгебраическая сумма этих множеств обозначается  и определяется так:

и определяется так:

xE  = A(x) + B(x)A(x)B(x).

= A(x) + B(x)A(x)B(x).

Для операций {,  } выполняются свойства:

} выполняются свойства:

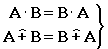

- коммутативность;

- коммутативность;

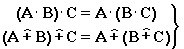

- ассоциативность;

- ассоциативность;

A = , A  = A, AE = A, A

= A, AE = A, A  E = E

E = E

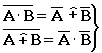

- теоремы де Моргана.

- теоремы де Моргана.

Не выполняются:

- идемпотентность;

- идемпотентность;

- дистрибутивность;

- дистрибутивность;

а также A  = , A

= , A

= E.

= E.

Замечание. Доказательства приводимых свойств операций над нечеткими множествами мы оставляем читателю.

Для примера докажем свойство:  . Обозначим A(x) через a, B(x) через b. Тогда в левой части для каждого элемента х имеем: 1- ab, а в правой: (1- a)+(1- b)-(1- a)(1- b) = 1- a +1- b - 1+ a + b-ab = 1- ab.

. Обозначим A(x) через a, B(x) через b. Тогда в левой части для каждого элемента х имеем: 1- ab, а в правой: (1- a)+(1- b)-(1- a)(1- b) = 1- a +1- b - 1+ a + b-ab = 1- ab.

Докажем, что свойство дистрибутивности не выполняется, т.е. A(B  C) (AB)

C) (AB)  (AC). Для левой части имеем: a (b + c-bc) = ab + ac-abc; для правой: ab + ac -(ab)(ac) = ab + ac + a 2 bc. Это означает, что дистрибутивность не выполняется при aa 2.

(AC). Для левой части имеем: a (b + c-bc) = ab + ac-abc; для правой: ab + ac -(ab)(ac) = ab + ac + a 2 bc. Это означает, что дистрибутивность не выполняется при aa 2.

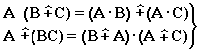

Замечание. При совместном использовании операций {, ,,} выполняются свойства:

А(BC) = (AB)(A C);

А (BC) = (AB)(AC);

А  (BC) = (A

(BC) = (A  B)(A

B)(A  C);

C);

А  (BC)=(A

(BC)=(A  B)(A

B)(A  C).

C).

Продолжим обзор основных операций над нечеткими множествами.

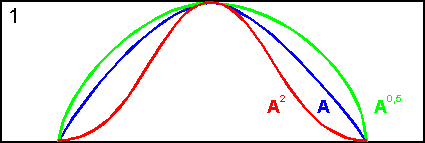

На основе операции алгебраического произведения (по крайней мере для целых эта основа очевидна) определяется операция возведения в степень нечеткого множества A, где - положительное число. Нечеткое множество A определяется функцией принадлежности A = A(x). Частным случаем возведения в степень являются:

CON(A) = A2 - операция концентрирования,

DIL(A) = A0,5 - операция растяжения,

которые используются при работе с лингвистическими неопределенностями.

|

|

|

Умножение на число. Если - положительное число, такое, что  A(x) 1, то нечеткое множество A имеет функцию принадлежности:

A(x) 1, то нечеткое множество A имеет функцию принадлежности:

A(x) = A(x).

Выпуклая комбинация нечетких множеств. Пусть A 1, A 2,.., A n - нечеткие множества универсального множества E, а 1, 2,..., n - неотрицательные числа, сумма которых равна 1.

Выпуклой комбинацией A 1, A 2,.., A n называется нечеткое множество A с функцией принадлежности:

xE A(x 1, x 1,..., x n) = 1A1(x) + 2A2(x) +... + nAi(x).

Декартово произведение нечетких множеств. Пусть A 1, A 2,..., A n - нечеткие подмножества универсальных множеств E 1, E 2,..., E n соответственно. Декартово произведение A = A 1 A 2 ... A n является нечетким подмножеством множества E = E 1 E 2 ... E n с функцией принадлежности:

A(x 1, x 1,..., x n) = min{ A1(x 1), A2(x 2),..., Ai(x n) }.

Оператор увеличения нечеткости используется для преобразования четких множеств в нечеткие и для увеличения нечеткости нечеткого множества.

Пусть A - нечеткое множество, E - универсальное множество и для всех xE определены нечеткие множества K(х). Совокупность всех K(х) называется ядром оператора увеличения нечеткости Ф. Результатом действия оператора Ф на нечеткое множество A является нечеткое множество вида:

Ф(A, K) =  A (x)K(х),

A (x)K(х),

где A(x)K(х) - произведение числа на нечеткое множество.

Пример:

E = {1,2,3,4};

A = 0,8/1+0,6/2+0/3+0/4;

K (1) = 1/1+0,4/2;

K (2) = 1/2+0,4/1+0,4/3;

K (3) = 1/3+0,5/4;

K (4) = 1/4.

Тогда

Ф(A,K) = A (1) K (1) A (2) K (2) A (3) K (3) A (4) K (4) =

= 0,8(1/1+0,4/2) 0,6(1/2+0,4/1+0,4/3) =

= 0,8/1+0,6/2+0,24/3.

Четкое множество -уровня (или уровня ). Множеством -уровня нечеткого множества A универсального множества E называется четкое подмножество A универсального множества E, определяемое в виде:

A ={ x / A (x)}, где 1.

Пример: A = 0,2/x1 + 0/x2 + 0,5/x3 + 1/x4,

|

|

|

тогда A0.3 = { x 3, x 4},

A0.7 = { x 4}.

Достаточно очевидное свойство: если 1 2, то A 1 A 2.

Теорема о декомпозиции. Всякое нечеткое множество A разложимо по его множествам уровня в виде:

A =  A , где A - произведение числа на множество A, и "пробегает" область значений M функции принадлежности нечеткого множества A.

A , где A - произведение числа на множество A, и "пробегает" область значений M функции принадлежности нечеткого множества A.

Пример: A = 0,1/ x 1 + 0/ x 2 + 0,7/ x 3 + 1/ x 4 представимо в виде:

A = 0,1(1,0,1,1) 0,7(0,0,1,1,) 1(0,0,0,1)=

= (0,1/x1 + 0/x2 + 0,1/x3 + 0,1/x4) (0/x1 + 0/x2 + 0,7/x3 + 0,7/x4)

(0/x1 + 0/x2 + 0/x3 + 1/x4) = 0,1/x1 +0/x2 +0,7/x3 +1/x4.

Если область значений функции принадлежности состоит из n градаций 1 2 3... n, то A (при фиксированных значениях градаций) представимо в виде:

A =  i A i,

i A i,

т.е. определяется совокупностью обычных множеств { A 1, A 2,..., A i}, где A 1 A 2,..., A i.

7. Лингвистические переменные. Примеры лингвистических переменных. Понятие терма. Определение количества термов

Лингвистическая переменная — в теории нечётких множеств, переменная, которая может принимать значения фраз из естественного или искусственного языка. Например, лингвистическая переменная «скорость» может иметь значения «высокая», «средняя», «очень низкая» и т. д. Фразы, значение которых принимает переменная, в свою очередь являются именами нечетких переменных и описываются нечетким множеством.

Пример: нечёткий возраст

Рассмотрим лингвистическую переменную, описывающую возраст человека, тогда:

x: «возраст»;

X: множество целых чисел из интервала [0, 120];

T(x): значения «молодой», «зрелый», «старый». множество T(x) - множество нечетких переменных, для каждого значения: «молодой», «зрелый», «старый», необходимо задать функцию принадлежности, которая задает информацию о том, людей какого возраста считать молодыми, зрелыми, старыми;

G: «очень», «не очень». Такие добавки позволяют образовывать новые значения: «очень молодой», «не очень старый» и пр.

M: математическое правило, определяющее вид функции принадлежности для каждого значения образованного при помощи правила G.

Терм — выражение формального языка (системы), является формальным именем объекта или именем формы. Понятие терма определяется индуктивно. Термом называется символьное выражение: t(X1, X2, …, Xn), где t — имя терма, называемая функтор или «функциональная буква», а X1, X2, …, Xn — термы, структурированные или простейшие.

|

|

|

8. Нечеткие отношения и их свойства

Одним из основных понятий теории нечетких множеств считается понятие нечеткого отношения. Эти отношения позволяют формализовать неточные утверждения типа «почти равно» или «значительно больше чем». Приведем определение нечеткого отношения и комбинации нечетких отношений.

Нечеткое отношение между двумя непустыми множествами (четкими) и будем называть нечеткое множество, определенное на декартовом произведении

9.

Нечеткий логический вывод– это процесс получения нечетких заключений на основе нечетких условий или предпосылок.

Применительно к нечеткой системе управления объектом, нечеткий логический вывод– это процесс получения нечетких заключений о требуемом управлении объектом на основе нечетких условий или предпосылок, представляющих собой информацию о текущем состоянии объекта.

Логический вывод осуществляется поэтапно.

Фаззификация(введение нечеткости) – это установка соответствия между численным значением входной переменной системы нечеткого вывода и значение функции принадлежности соответствующего ей терма лингвистической переменной. На этапе фаззификации значениям всех входным переменным системы нечеткого вывода, полученным внешним по отношению к системе нечеткого вывода способом, например, при помощи статистических данных, ставятся в соответствие конкретные значения функций принадлежности соответствующих лингвистических термов, которые используются в условиях (антецедентах) ядер нечетких продукционных правил, составляющих базу нечетких продукционных правил системы нечеткого вывода. Фаззификация считается выполненной, если найдены степени истинности (a) всех элементарных логических высказываний вида «ЕСТЬ», входящих в антецеденты нечетких продукционных правил, где - некоторый терм с известной функцией принадлежности µ(x), - четкое численное значение, принадлежащее универсуму лингвистической переменной.

|

|

|

10.

Понятие нечеткого алгоритма, впервые введенное Л.А. Заде, является важным инструментом для приближенного анализа сложных систем и процессов принятия решений. Под нечетким алгоритмом (fuzzy algorithm) понимается упорядоченное множество нечетких инструкций (правил), в формулировке которых содержатся нечеткие указания (термы).

Переход от полученного нечеткого множества к единственному четкому значению ()о, которое и признается затем в качестве решения поставленной задачи, называется дефаззификацией (defuzzyfication).

11. Алгоритм Мамдани (Mamdani) нашел применение в первых нечетких системах автоматического управления. Был предложен в 1975 году английским математиком Е.Мамдани для управления паровым двигателем.

Формирование базы правил системы нечеткого вывода осуществляется в виде упорядоченного согласованного списка нечетких продукционных правил в виде «IF A THEN B», где антецеденты ядер правил нечеткой продукции построены при помощи логических связок «И», а консеквенты ядер правил нечеткой продукции простые.

Фаззификация входных переменных осуществляется описанным выше способом, так же, как и в общем случае построения системы нечеткого вывода.

Агрегирование подусловий правил нечеткой продукции осуществляется при помощи классической нечеткой логической операции «И» двух элементарных высказываний A, B: T(A ∩ B) = min{ T(A);T(B) }.

Активизация подзаключений правил нечеткой продукции осуществляется методом min-активизации μ (y) = min{c; μ (x) }, где μ (x) и c – соответственно функции принадлежности термов лингвистических переменных и степени истинности нечетких высказываний, образующих соответствующие следствия (консеквенты) ядер нечетких продукционных правил.

Аккумуляция подзаключений правил нечеткой продукции проводится при помощи классического для нечеткой логики max-объединения функций принадлежности ∀ x ∈ X μ A B x = max{ μ A x; μ B x }.

Дефаззификация проводится методом центра тяжести или центра площади.

12 Для реализации систем на базе нечетких правил разработано множество алгоритмов нечеткого вывода. Алгоритмы нечеткого вывода различаются главным образом видом используемых правил, логических операций и разновидностью метода дефазификации. Разработаны модели нечеткого вывода Мамдани, Сугено, Ларсена, Цукамото.

Например, правила нечеткого вывода заданы следующим образом:

П1: если x есть A, то w есть D, П2: если y есть B, то w есть E, П3: если z есть C, то w есть F,

где x, y, z – имена входных переменных (четкого формата);

w – имя переменной вывода;

A, B, C, D, E, F – заданные функции принадлежности.

FAT-теорема Б. Коско: Любая классическая математика может быть аппроксимирована средствами математики нечеткой. Т.е. возможно построить нечёткую систему максимально приближающую функцию колебания курса некоторой валюты.

Основные достоинства системы объяснений в ЭС.

1) Объяснения помогают пользователю использовать систему для решения своих задач,

2) Так как ЭС используются в слабоформализованных областях, где нет четких алгоритмов, то объяснения позволяют пользователю убедится в правильности полученных результатов, повышают его степень доверия к ЭС,

3) Служат для обучения пользователя,

4) Служат для отладки базы знаний ЭС

Основные недостатки системы объяснений в ЭС.

1) Запросы на объяснение интерпретируются только в одном узком смысле (вопросы ПОЧЕМУ и КАК интерпретируются только в терминах целей и правил),

2) Не все действия системы могут быть объяснены (например, почему сначала проверялась одна гипотеза, а потом другая),

3) Объяснения, основываются фактически на треке выполнения программы, поэтому при смене интерпретатора необходимо менять и систему объяснений.

15.

Тщательная проработка и учет рисков стала неотъемлемой частью и важной составляющей успеха деятельности каждой компании. Однако все чаще компаниям приходится принимать решения в условиях неопределенности, которые могут привести к непредвиденным последствиям и, соответственно, нежелательным исходам и убыткам. Особенно серьезные последствия могут иметь неправильные решения относительно долгосрочных инвестиций, которые обычно подразумеваются при оценке инвестиционных проектов. Поэтому своевременное выявление, а также адекватная и наиболее точная оценка рисков является одной из насущных проблем современного инвестиционного анализа.

К сожалению, существующие на сегодняшний день методы учета и оценки рисков не лишены субъективизма и существенных предпосылок, приводящих к неправильным оценкам риска проектов. Теория нечеткой логики – это новый, динамично развивающийся подход к оценке риска. В последнее время нечеткое моделирование является одной из наиболее активных и перспективных направлений прикладных исследований в области управления и принятия решений.

В данной работе представлены:

Определение риска и неопределенности,

обоснование необходимости применения новых подходов к анализу риска,

краткое описание метода нечеткой логики,

примеры применения нечеткой логики

16.

Решаемые нейронными сетями задачи весьма разнообразны. Неудивительно, что этот метод нашел применение в таких сферах, как медицина, финансовый менеджмент и политическая наука. В целом можно свести основную часть решаемых с помощью ИНС проблем к нескольким категориям задач.

Классификация. Задачей нейронной сети является распределение объектов по нескольким заранее установленным непересекающимся классам

В политической науке нейросетевой метод используется для решения задач классификации, в частности в ивент-анализе. Заранее определяется класс конфликтных событийных последовательностей, ведущих к мирному урегулированию, и класс конфликтных событийных последовательностей, ведущих к военному противостоянию

17.

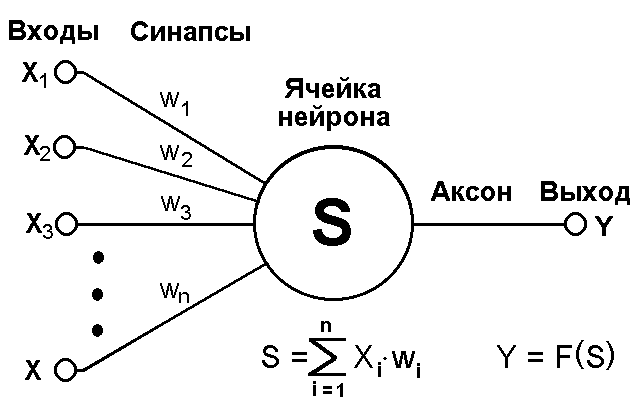

Иску́сственный нейро́н (математический нейрон Маккалока — Питтса[en], формальный нейрон[1]) — узел искусственной нейронной сети, являющийся упрощённой моделью естественного нейрона. Математически, искусственный нейрон обычно представляют как некоторую нелинейную функцию от единственного аргумента — линейной комбинации всех входных сигналов. Данную функцию называют функцией активации[2] или функцией срабатывания, передаточной функцией. Полученный результат посылается на единственный выход. Такие искусственные нейроны объединяют в сети — соединяют выходы одних нейронов с входами других. Искусственные нейроны и сети являются основными элементами идеального нейрокомпьютера

Иску́сственный нейро́н (математический нейрон Маккалока — Питтса[en], формальный нейрон[1]) — узел искусственной нейронной сети, являющийся упрощённой моделью естественного нейрона. Математически, искусственный нейрон обычно представляют как некоторую нелинейную функцию от единственного аргумента — линейной комбинации всех входных сигналов. Данную функцию называют функцией активации[2] или функцией срабатывания, передаточной функцией. Полученный результат посылается на единственный выход. Такие искусственные нейроны объединяют в сети — соединяют выходы одних нейронов с входами других. Искусственные нейроны и сети являются основными элементами идеального нейрокомпьютера

18. Функция активации (активационная функция, функция возбуждения) – функция, вычисляющая выходной сигнал искусственного нейрона. В качестве аргумента принимает сигнал Y, получаемый на выходе входного сумматора Sigma. Наиболее часто используются следующие функции активации.

1. Единичный скачок или жесткая пороговая функция

Простая кусочно-линейная функция. Если входное значение меньше порогового, то значение функции активации равно минимальному допустимому, иначе – максимально допустимому.

Функция активации. Жесткая пороговая функция

2. Линейный порог или гистерезис

Несложная кусочно-линейная функция. Имеет два линейных участка, где функция активации тождественно равна минимально допустимому и максимально допустимому значению и есть участок, на котором функция строго монотонно возрастает.

Функция активации. Линейный порог

3. Сигмоидальная функция или сигмоид

Монотонно возрастающая всюду дифференцируемая S-образная нелинейная функция с насыщением. Сигмоид позволяет усиливать слабые сигналы и не насыщаться от сильных сигналов. Гроссберг (1973 год) обнаружил, что подобная нелинейная функция активации решает поставленную им дилемму шумового насыщения.

19.

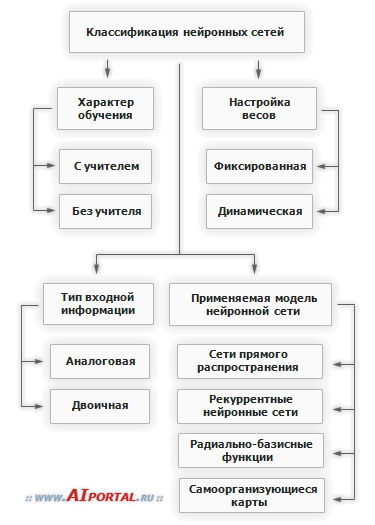

Иску́сственная нейро́нная се́ть (ИНС) — математическая модель, а также её программное или аппаратное воплощение, построенная по принципу организации и функционирования биологических нейронных сетей — сетей нервных клеток живого организма. Это понятие возникло при изучении процессов, протекающих в мозге, и при попытке смоделировать эти процессы. Первой такой попыткой были нейронные сети У. Маккалока и У. Питтса[en][1]. После разработки алгоритмов обучения получаемые модели стали использовать в практических целях: в задачах прогнозирования, для распознавания образов, в задачах управления и др.

20.

21.

ИНС (Искусственные Нейронные Сеть) может рассматриваться как направленный граф со взвешенными связями, в котором искусственные нейроны являются узлами. По архитектуре связей ИНС могут быть сгруппированы в два класса: сети прямого распространения, в которых графы не имеют петель, и рекуррентные сети, или сети с обратными связями. В наиболее распространенном семействе сетей первого класса, называемых многослойным перцептроном, нейроны расположены слоями и имеют однонаправленные связи между слоями. На рисунке представлены типовые сети каждого класса. Сети прямого распространения являются статическими в том смысле, что на заданный вход они вырабатывают одну совокупность выходных значений, не зависящих от предыдущего состояния сети. Рекуррентные сети являются динамическими, так как в силу обратных связей в них модифицируются входы нейронов, что приводит к изменению состояния сети. 22

ИНС (Искусственные Нейронные Сеть) может рассматриваться как направленный граф со взвешенными связями, в котором искусственные нейроны являются узлами. По архитектуре связей ИНС могут быть сгруппированы в два класса: сети прямого распространения, в которых графы не имеют петель, и рекуррентные сети, или сети с обратными связями. В наиболее распространенном семействе сетей первого класса, называемых многослойным перцептроном, нейроны расположены слоями и имеют однонаправленные связи между слоями. На рисунке представлены типовые сети каждого класса. Сети прямого распространения являются статическими в том смысле, что на заданный вход они вырабатывают одну совокупность выходных значений, не зависящих от предыдущего состояния сети. Рекуррентные сети являются динамическими, так как в силу обратных связей в них модифицируются входы нейронов, что приводит к изменению состояния сети. 22

23. перцептрон- математическая модель процесса восприятия (См. Восприятие). Сталкиваясь с новыми явлениями или предметами, человек их узнаёт, то есть относит к тому или иному понятию (классу). Так, мы легко узнаём знакомых, даже если они изменили причёску или одежду, можем читать рукописи, хотя каждый почерк имеет свои особенности, узнаём мелодию в различной аранжировке и т.д. Эта способность человека и получила название феномена восприятия. Человек умеет на основании опыта вырабатывать и новые понятия, обучаться новой системе классификации. Например, при обучении различению рукописных знаков ученику показывают рукописные знаки и сообщают, каким буквам они соответствуют, то есть к каким классам эти знаки относятся; в результате у него вырабатывается умение правильно классифицировать знаки.

Каждая отдельная клетка называется узлом или персептроном:

нейронная сеть, состоящая из слоя узлов между входом и выходом, - однослойным персептроном: а сеть, состоящая из нескольких слоев - многослойным персептроном:

Справедливо утверждение, что многослойный персептрон более эффективен, чем однослойный

24.

Обучение – это процесс, в котором свободные параметры нейронной сети настраиваются посредством моделирования среды, в которую эта сеть встроена. Тип обучения определяется способом подстройки этих параметров.

Это определение процесса обучения нейронной сети предполагает следующую последовательность событий:

В нейронную сеть поступают стимулы из внешней среды.

В результате первого пункта изменяются свободные параметры нейронной сети.

После изменения внутренней структуры нейронная сеть отвечает на возбуждения уже иным образом.

Вышеуказанный список четких правил решения проблемы обучения нейронной сети называется алгоритмом обучения. Несложно догадаться, что не существует универсального алгоритма обучения, подходящего для всех архитектур нейронных сетей. Существует лишь набор средств, представленный множеством алгоритмов обучения, каждый из которых имеет свои достоинства. Алгоритмы обучения отличаются друг от друга способом настройки синаптических весов нейронов. Еще одной отличительной характеристикой является способ связи обучаемой нейронной сети с внешним миром. В этом контексте говорят о парадигме обучения, связанной с моделью окружающей среды, в которой функционирует данная нейронная сеть.

Обучение нейронной сети с учителем предполагает, что для каждого входного вектора из обучающего множества существует требуемое значение выходного вектора, называемого целевым. Эти вектора образуют обучающую пару. Веса сети изменяют до тех пор, пока для каждого входного вектора не будет получен приемлемый уровень отклонения выходного вектора от целевого.

Обучение нейронной сети без учителя является намного более правдоподобной моделью обучения с точки зрения биологических корней искусственных нейронных сетей. Обучающее множество состоит лишь из входных векторов. Алгоритм обучения нейронной сети подстраивает веса сети так, чтобы получались согласованные выходные векторы, т.е. чтобы предъявление достаточно близких входных векторов давало одинаковые выходы.

25.

Пусть имеется нейронная сеть, выполняющая преобразование F:X®Y векторов X из признакового пространства входов X в вектора Y выходного пространства Y. Сеть находится в состоянии W из пространства состояний W. Пусть далее имеется обучающая выборка (Xa,Ya), a = 1..p. Рассмотрим полную ошибку E, делаемую сетью в состоянии W.

Отметим два свойства полной ошибки. Во-первых, ошибка E=E(W) является функцией состояния W, определенной на пространстве состояний. По определению, она принимает неотрицательные значения. Во-вторых, в некотором обученном состоянии W*, в котором сеть не делает ошибок на обучающей выборке, данная функция принимает нулевое значение. Следовательно, обученные состояния являются точками минимума введенной функции E(W).

|

|

|

|

|

Дата добавления: 2015-08-31; Просмотров: 1838; Нарушение авторских прав?; Мы поможем в написании вашей работы!