КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

В свою очередь среди многослойных сетей выделяют следующие типы

|

|

|

|

В полносвязных сетях каждый нейрон передает свой выходной сигнал остальным нейронам, в том числе и самому себе. Все входные сигналы подаются всем нейронам. Выходным сигналами сети могут быть все или некоторые выходные сигналы нейронов после нескольких тактов функционирования сети.

1. Монотонные – частный случай слоистых сетей с дополнительными условиями на связи и элементы. Каждый слой, кроме последнего, разбит на два блока: возбуждающий (В) и тормозящий (Т). Связи между блоками тоже разделяются на тормозящие и возбуждающие. Если от блока А к блоку С ведут только возбуждающие связи, то это означает, что любой выходной сигнал блока является монотонной неубывающей функцией любого выходного сигнала блока А. Если же эти связи тормозящие, то любой выходной сигнал блока С является невозрастающей функцией любого выходного сигнала блока А.

2. Сети без обратных связей. В таких сетях нейроны входного слоя получают входные сигналы, преобразуют их и передают нейронам 1-го скрытого слоя, далее срабатывает 1-й скрытый слой и т.д. до Q-го слоя, который выдает выходные сигналы для интерпретатора и пользователя. Если не оговорено противное, то каждый выходной сигнал i – го слоя подастся на вход всех нейронов (q+l)-го слоя; однако возможен вариант соединения q-го слоя с произвольным (q+p)- м слоем.

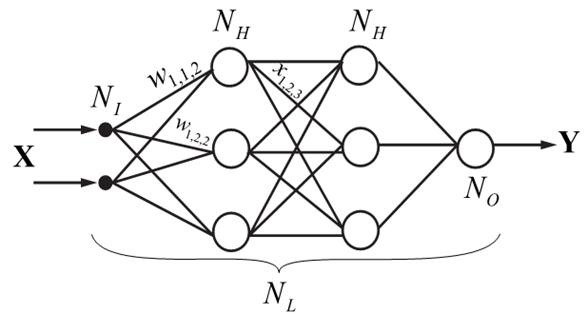

Самым распространенным видом нейронной сети является многослойный персептрон:

Рис. Многослойный персептрон.

Сеть состоит из произвольного количества слоев нейронов. Нейроны каждого слоя соединяются с нейронами предыдущего и последующего слоев по принципу "каждый с каждым". Первый слой (слева) называется сенсорным или входным, внутренние слои называются скрытыми или ассоциативными, последний (самый правый, на рисунке состоит из одного нейрона) — выходным или результативным. Количество нейронов в слоях может быть произвольным. Обычно во всех скрытых слоях одинаковое количество нейронов.

|

|

|

Обозначим количество слоев и нейронов в слое. Входной слой: NI нейронов; NH нейронов в каждом скрытом слое; N0 выходных нейронов, х — вектор входных сигналов сети, у - вектор выходных сигналов.

Входной слой не выполняет никаких вычислений, а лишь распределяет входные сигналы, поэтому иногда его считают, иногда — нет. Обозначим через NL полное количество слоев в сети, считая входной.

Работа многослойного персептрона (МСП) описывается формулами:

,(1)

,(1)

, (2)

, (2)

, (3)

, (3)

где индексом i обозначается номер входа, j — номер нейрона в слое, l — номер слоя.

xijl — i -й входной сигнал j -го нейрона в слое l;

wijl — весовой коэффициент i -го входа нейрона номер j в слое l;

NETjl — сигнал NET j -ro нейрона в слое l;

OUTjl — выходной сигнал нейрона;

θjl — пороговый уровень нейрона j в слое l.

Введем обозначения: w jl – вектор-столбец весов для всех входов нейрона j в слое l; W l – матрица весов всех нейронов в слое l. В столбцах матрицы расположены векторы w jl. Аналогично x jl – входной вектор-столбец слоя l.

Каждый слой рассчитывает нелинейное преобразование от линейной комбинации сигналов предыдущего слоя. Отсюда видно, что линейная функция активации может применяется только для тех моделей сетей, где не требуется последовательное соединение слоев нейронов друг за другом. Для многослойных сетей функция активации должна быть нелинейной, иначе можно построить эквивалентную однослойную сеть, и многослойность оказывается ненужной. Если применена линейная функция активации, то каждый слой будет давать на выходе линейную комбинацию входов. Следующий слой даст линейную комбинацию выходов предыдущего, а это эквивалентно одной линейной комбинации с другими коэффициентами, и может быть реализовано в виде одного слоя нейронов.

|

|

|

Многослойный персептрон может формировать на выходе произвольную многомерную функцию при соответствующем выборе количества слоев, диапазона изменения сигналов и параметров нейронов.

Многослойный персептрон является сетью без обратных связей, поэтому его называют сетью прямого распространения. Они не обладают внутренним состоянием и не позволяют без дополнительных приемов моделировать развитие динамических систем.

Предложенный Ф.Розенблаттом метод обучения персептрона состоит в итерационной подстройке матрицы весов, последовательно уменьшающей ошибку в выходных векторах. Алгоритм включает несколько шагов:

1. Начальные значения весов всех нейронов W(t = 0) полагаются случайными.

2. Сети предъявляется входной образ xk, в результате формируется выходной образ yk ≠ ŷk.

3. Вычисляется вектор ошибки δk = yk – ŷk, которую сеть делает на выходе. Дальнейшая идея состоит в том, что изменение вектора весовых коэффициентов в области малых ошибок должно быть пропорционально ошибке на выходе, и равно нулю если ошибка равна нулю.

4. Вектор весов модифицируется по следующей формуле:

W(t + Δt) = W(t) + n∙xk∙δkT,

где 0 < n < 1 – темп обучения.

5. Шаги 1-3 повторяются для всех обучающих векторов. Один цикл последовательного предъявления всей выборки называется эпохой. Обучение завершается по истечении нескольких эпох, если а) итерации сойдутся, т.е. вектор весов перестает измеяться, или б) полная просуммированная по всем векторам абсолютная ошибка станет меньше некоторого малого значения

Используемая на шаге 3 формула учитывает следующие обстоятельства:

а) модифицируются только компоненты матрицы весов, отвечающие ненулевым значениям входов;

б) знак приращения веса соответствует знаку ошибки, т.е. положительная ошибка (δ > 0, т.е. значение выхода меньше требуемого) проводит к усилению связи;

в) обучение каждого нейрона происходит независимо от обучения остальных нейронов, что соответсвует важному с биологической точки зрения, принципу локальности обучения.

Данный метод обучения был назван Ф.Розенблаттом “методом коррекции с обратной передачей сигнала ошибки”. Позднее более широко стало известно название «δ -правило». Представленный алгоритм относится к широкому классу алгоритмов обучения с учителем, поскольку известны как входные вектора, так и требуемые значения выходных векторов (имеется учитель, способный оценить правильность ответа ученика).

|

|

|

|

|

|

|

Дата добавления: 2014-01-06; Просмотров: 680; Нарушение авторских прав?; Мы поможем в написании вашей работы!