КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Понятие информации

|

Понятие информации является наиболее сложным для понимания и обычно во вводных курсах информатики не определяется, принимается как исходное базовое понятие, понимается интуитивно, наивно. Часто это понятие отождествляется неправильным образом с понятием "сообщение".

Понятие "информация" имеет различные трактовки в разных предметных областях. Например, информация может пониматься как:

· абстракция, абстрактная модель рассматриваемой системы (в математике);

· сигналы для управления, приспособления рассматриваемой системы (в кибернетике);

· мера хаоса в рассматриваемой системе (в термодинамике);

· вероятность выбора в рассматриваемой системе (в теории вероятностей);

· мера разнообразия в рассматриваемой системе (в биологии) и др.

Рассмотрим это фундаментальное понятие информатики на основе понятия "алфавит" ("алфавитный", формальный подход). Дадим формальное определение алфавита.

Алфавит – конечное множество различных знаков, символов, для которых определена операция конкатенации (приписывания, присоединения символа к символу или цепочке символов); с ее помощью по определенным правилам соединения символов и слов можно получать слова (цепочки знаков) и словосочетания (цепочки слов) в этом алфавите (над этим алфавитом).

Буквой или знаком называется любой элемент x алфавита X, где  . Понятие знака неразрывно связано с тем, что им обозначается ("со смыслом"), они вместе могут рассматриваться как пара элементов (x, y), где x – сам знак, а y – обозначаемое этим знаком.

. Понятие знака неразрывно связано с тем, что им обозначается ("со смыслом"), они вместе могут рассматриваться как пара элементов (x, y), где x – сам знак, а y – обозначаемое этим знаком.

Пример. Примеры алфавитов: множество из десяти цифр, множество из знаков русского языка, точка и тире в азбуке Морзе и др. В алфавите цифр знак 5 связан с понятием "быть в количестве пяти элементов".

|

|

|

Конечная последовательность букв алфавита называется словом в алфавите (или над алфавитом).

Длиной | p | некоторого слова p над алфавитом Х называется число составляющих его букв.

Слово (обозначаемое символом Ø) имеющее нулевую длину, называется пустым словом: |Ø| = 0.

Множество различных слов над алфавитом X обозначим через S (X) и назовем словарным запасом (словарем) алфавита (над алфавитом) X.

В отличие от конечного алфавита, словарный запас может быть и бесконечным.

Слова над некоторым заданным алфавитом и определяют так называемые сообщения.

Пример. Слова над алфавитом кириллицы – "Информатика", "инто", "ииии", "и". Слова над алфавитом десятичных цифр и знаков арифметических операций – "1256", "23+78", "35–6+89", "4". Слова над алфавитом азбуки Морзе – ".", ".. –", "– – –".

В алфавите должен быть определен порядок следования букв (порядок типа "предыдущий элемент – последующий элемент"), то есть любой алфавит имеет упорядоченный вид X = { x 1, x 2, …, x n}.

Таким образом, алфавит должен позволять решать задачу лексикографического (алфавитного) упорядочивания, или задачу расположения слов над этим алфавитом, в соответствии с порядком, определенным в алфавите (то есть по символам алфавита).

Информация – это некоторая упорядоченная последовательность сообщений, отражающих, передающих и увеличивающих наши знания.

Информация актуализируется с помощью различной формы сообщений – определенного вида сигналов, символов.

Информация по отношению к источнику или приемнику бывает трех типов: входная, выходная и внутренняя.

Информация по отношению к конечному результату бывает исходная, промежуточная и результирующая.

Информация по ее изменчивости бывает постоянная, переменная и смешанная.

|

|

|

Информация по стадии ее использования бывает первичная и вторичная.

Информация по ее полноте бывает избыточная, достаточная и недостаточная.

Информация по доступу к ней бывает открытая и закрытая.

Есть и другие типы классификации информации.

Пример. В философском аспекте информация делится на мировозренческую, эстетическую, религиозную, научную, бытовую, техническую, экономическую, технологическую.

Основные свойства информации:

· полнота;

· актуальность;

· адекватность;

· понятность;

· достоверность;

· массовость;

· устойчивость;

· ценность и др.

Информация – содержание сообщения, сообщение – форма информации.

Любые сообщения измеряются в байтах, килобайтах, мегабайтах, гигабайтах, терабайтах, петабайтах и эксабайтах, а кодируются, например, в компьютере, с помощью алфавита из нулей и единиц, записываются и реализуются в ЭВМ в битах.

Приведем основные соотношения между единицами измерения сообщений:

1 бит (binary digit – двоичное число) = 0 или 1,

1 байт 8 битов,

1 килобайт (1К) = 213 бит,

1 мегабайт (1М) = 223 бит,

1 гигабайт (1Г) = 233 бит,

1 терабайт (1Т) = 243 бит,

1 петабайт (1П) = 253 бит,

1 эксабайт (1Э) = 263 бит.

Для измерения информации используются различные подходы и методы, например, с использованием меры информации по Р. Хартли и К. Шеннону.

Количество информации – число, адекватно характеризующее разнообразие (структурированность, определенность, выбор состояний и т.д.) в оцениваемой системе. Количество информации часто оценивается в битах, причем такая оценка может выражаться и в долях битов (так речь идет не об измерении или кодировании сообщений).

Мера информации – критерий оценки количества информации. Обычно она задана некоторой неотрицательной функцией, определенной на множестве событий и являющейся аддитивной, то есть мера конечного объединения событий (множеств) равна сумме мер каждого события.

Рассмотрим различные меры информации.

Возьмем меру Р. Хартли. Пусть известны N состояний системы S (N опытов с различными, равновозможными, последовательными состояниями системы). Если каждое состояние системы закодировать двоичными кодами, то длину кода d необходимо выбрать так, чтобы число всех различных комбинаций было бы не меньше, чем N:

|

|

|

(1)

(1)

Логарифмируя это неравенство, можно записать:

(2)

(2)

Наименьшее решение этого неравенства или мера разнообразия множества состояний системы задается формулой Р. Хартли:

H = log2 N (бит). (3)

Пример. Чтобы определить состояние системы из четырех возможных состояний, то есть получить некоторую информацию о системе, необходимо задать 2 вопроса. Первый вопрос, например: "Номер состояния больше 2?". Узнав ответ ("да", "нет"), мы увеличиваем суммарную информацию о системе на 1 бит (I = log22). Далее необходим еще один уточняющий вопрос, например, при ответе "да": "Состояние – номер 3?". Итак, количество информации равно 2 битам (I = log24). Если система имеет n различных состояний, то максимальное количество информации равно I = log2 n.

Если во множестве X = { x 1, x 2,..., x n} искать произвольный элемент, то для его нахождения (по Хартли) необходимо иметь не менее loga n (единиц) информации.

Уменьшение I говорит об уменьшении разнообразия состояний N системы.

Увеличение I говорит об увеличении разнообразия состояний N системы.

Мера Хартли подходит лишь для идеальных, абстрактных систем, так как в реальных системах состояния системы не одинаково осуществимы (не равновероятны).

Для таких систем используют более подходящую меру К. Шеннона. Мера Шеннона оценивает информацию отвлеченно от ее смысла:

|

где n – число состояний системы; рi – вероятность (относительная частота) перехода системы в i -е состояние, а сумма всех pi должна равняться 1.

Если все состояния рассматриваемой системы равновозможны, равновероятны, то есть рi = 1/ n, то из формулы Шеннона можно получить (как частный случай) формулу Хартли:

I = log2 n.

Пример. Если положение точки в системе из 10 клеток известно, например если точка находится во второй клетке, то есть

рi = 0, i = 1, 3, 4, …, 10, р 2 = 1,

то тогда получаем количество информации, равное нулю:

I = log21 = 0.

Обозначим величину:

fi = – n log2 pi.

Тогда из формулы К. Шеннона следует, что количество информации I можно понимать как среднеарифметическое величин fi, то есть величину fi можно интерпретировать как информационное содержание символа алфавита с индексом i и величиной pi вероятности появления этого символа в любом сообщении (слове), передающем информацию.

|

|

|

Следует отметить, что формула Шеннона (4), также носит название энтропия Шеннона. Формула (4) позволяет не только оценить количество информации, необходимого для устранения имеющейся неопределенности, но и коренному пересмотру существующих взглядов на соответствующие объекты исследования и формированию принципиально новых идей и взглядов.

Рассмотрим поведение энтропии Шеннона для двоичного алфавита, используемого в машинных кодах. Алфавит рассматриваемого языка состоит из символов «0» и «1». Для этого случая формула (4) примет вид

I1=-p (0)log2 p (0) -p (1)log2 p (1) (5)

или, так как p (0)+ p (1) = 1

I 1 =-p log2 p- (1 -p)log2(1 -p) (6)

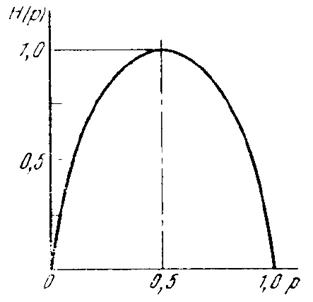

Где через p обозначено какое-либо из значений p (0) или p (1). Что как легко заметить из формул (5) и (6), все равно. Функция (6) представлена графически на Рисунок 3.

Где через p обозначено какое-либо из значений p (0) или p (1). Что как легко заметить из формул (5) и (6), все равно. Функция (6) представлена графически на Рисунок 3.

Рисунок 3 Примерный характер функции Шеннона I (p) в области 0 £ p £ 1

Наибольшее возможное значение I 1=1, которое достигается при p= 0.5 и принято за единицу измерения количества информации. Эту единицу по предложению Тьюки назвали бит. К сожалению это название представляется не очень удачным, поскольку является источником распространенного заблуждения, заключающегося в убеждении, что информационная нагрузка одного двоичного символа всегда равна одному биту.

Один бит – это количество неопределенности, которое имеет место при необходимости угадывания того, какое из двух равновероятных (и независимых от результатов предыдущих экспериментов) событий будет иметь место при очередном испытании. Иными словами, это количество информации, содержащееся в сообщении о том, какое именно из двух равновероятных событий имело место. Если же эти события не являются равновероятными, то информационная нагрузка одного двоичного символа становиться меньше одного бита и может уменьшаться до нуля.

В реальных текстах вероятности появления тех или иных букв алфавита в значительной степени зависят от того, какие именно буквы им предшествовали.

Пример. Значение вероятности того, что очередная буква в произвольном русском тексте окажется мягким знаком, близка к нулю, если предшествовал набор букв «рассматрив?», и близка к единице, если предшествовал набор букв «рассматриват?».

Интуитивно ясно, что знание предшествующих букв в общем случае облегчает угадывание очередной буквы. Ясно также, что чем больше число известных предшествующих букв, тем, при прочих равных условиях, в большей степени облегчается угадывание очередной буквы. Такая зависимость присутствует в любом связанном тексте (обычный текст, цифровые изображения, музыка, фильмы и так далее) и обусловлена синтаксисом рассматриваемого языка и (что важнее, хотя и менее очевидно) смысловой нагрузкой (семантикой) текста.

Чтобы осуществить количественную оценку указанного обстоятельства, наряду с формулой (4) Шеннон рассматривал следующую формулу:

(7)

(7)

где  - вероятность того, что наугад взятая из текста последовательность букв длины m окажется последовательностью Bms. Суммирование в (7) ведется по всем nm возможным последовательностям длины m. В качестве энтропии угадывания очередной буквы связанного текста Шеннон предлагает пользоваться значением

- вероятность того, что наугад взятая из текста последовательность букв длины m окажется последовательностью Bms. Суммирование в (7) ведется по всем nm возможным последовательностям длины m. В качестве энтропии угадывания очередной буквы связанного текста Шеннон предлагает пользоваться значением

(9)

(9)

Естественно, что Im – монотонно убывающая функция от m. Лишь в частном случае, когда вероятности появления в тексте тех или иных букв не зависят от того, какие именно буква им предшествовали, значение Im не зависит от m и равно Im = I1 (смотри формулу (4))

Так же Шеннон математически доказал, что любая информация обладает избыточностью и предельные возможности сжатия информации.

Конечно, оперировать такими понятиями могут достаточно подготовленные люди. Поэтому можно ввести понятие информации следующим образом: «Информация – это данные и адекватные им методы».

Рассмотрим это определение подробно. Мы живем, постоянно получая те или иные данные (сообщения). Очень часто под данными и понимают информацию, что не всегда правильно. Например, рассмотрим ситуацию, которую испытывает каждый человек утром. Человек проснулся, посмотрел на часы и в зависимости от времени принимает решения: бежать на работу или спокойно пить кофе, собираться, и не спеша выходить на работу. Где же в этом примере информация. В принципе сразу можно сказать – «время». Но тут следует оговориться, что в зависимости от того, сколько времени (количественного показателя – данных) принимается решение. Таким образом, под информацией можно понимать только те данные, которые человек может осмыслить в силу своих знаний и накопленного опыта.

Приведем пример, когда данные не являются для конкретного человека информацией. Рассмотрим следующую ситуацию. Студент филолог попал случайно на лекцию по термодинамике и слышит следующий текст: «Не ньютоновскими жидкостями называются те жидкости, которые не удовлетворяют уравнению Менделеева-Клайперона». Конечно, в случае если филолог хорошо учился в школе, он сможет вспомнить кто такой Менделеев, кто такой Клайперон – сомневаюсь, ну а то, что у них есть уравнение, да и к тому же, как оно выглядит и тем более как его интерпретировать вряд ли. Для такого человека поток данных, к сожалению, не становится информацией.

Исходя из данного выше определения, можно сказать что, информация может иметь следующие уровни:

· синтаксический;

· семантический;

· прагматический.

Синтаксический уровень – это как оформлена информация (речь, текст, изображение, музыка, сигнал и тому подобное).

Семантический уровень – это непосредственно смысловая нагрузка информации.

Прагматический уровень – это мера полезности информации для конкретного объекта информационного обмена.

До сего момента мы вводили понятие информации не привязывая его к информационной системе, в случае если мы рассматриваем информационную систему, то все выше приведенные рассуждения верны, но требуют дополнительного разъяснения.

Когда мы рассматривали вопрос о мере информации, то имелась ввиду некая абстрактная информация. В случае с информационной системой что будет являться единицей информации? По идее, что, так что этак должен быть бит. Но это довольно распространенное заблуждение, так как информация в информационной системе играет роль управляющего воздействия на систему. В этом случае, конечно единицей информации будет конечно документ. Следует оговориться сразу, что в информационной системе любую информацию рассматривают как документ, а не как мы привыкли в обычной ситуации. Чтобы не происходило путаницы, иногда вводят понятие электронного документа, но в этом понятии есть свои подводные камни, поэтому следует остановиться просто на документе.

Естественно документы информационной системы имеют те же свойства что и обычные документы. Единственно следует отметить, что от типа документа и его жизненного цикла выбирается его местоположение в системе. Например, повседневные распоряжения, бухгалтерские проводки и другие документы постоянной проработки должны находится в секторе оперативного накопления – реагирования информационной системы (если взять в качестве аналога компьютер – в оперативной памяти). А документы длительного использования, технологические карты, производственные карты, нормативы, списки оснастки и оборудования должны находится на постоянном хранении, и использоваться по мере возникновения потребности.

Рассмотрим следующий компонент информационной системы – информационные технологии.

|

|

|

|

|

Дата добавления: 2014-12-27; Просмотров: 715; Нарушение авторских прав?; Мы поможем в написании вашей работы!