КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Статистический подход к измерению информации

|

|

|

|

Аддитивная мера

предложена в 1928 году американским ученым Хартли, второе название – мера Хартли.

Хартли впервые ввел специальное обозначение для количества информации – I и предложил следующую логарифмическую зависимость между количеством информации и мощностью исходного алфавита:

I = Llog h,

где I – количество информации, содержащейся в сообщении;

L– длина сообщения;

h – мощность исходного алфавита.

При исходном алфавите {0,1}; L = 1; h = 2 и основании логарифма, равном 2, имеем

I = 1*log22 = 1.

формула даёт аналитическое определение бита (BIT - BInary digiT) по Хартли: это количество информации, которое содержится в двоичной цифре.

Единицей измерения информации в аддитивной мере является бит.

В 30-х годах ХХ века американский ученый Клод Шеннон предложил связать количество информации, которое несет в себе некоторое сообщение, с вероятностью получения этого сообщения.

Вероятность p – количественная априорная (т.е. известная до проведения опыта) характеристика одного из исходов (событий) некоторого опыта.

Измеряется в пределах от 0 до 1.

Если заранее известны все исходы опыта, сумма их вероятностей равна 1, а сами исходы составляют полную группу событий.

Если все исходы могут свершиться с одинаковой долей вероятности, они называются равновероятными.

Пусть можно получить n сообщений по результатам некоторого опыта (т.е. у опыта есть n исходов), причем известны вероятности получения каждого сообщения (исхода) - pi. Тогда в соответствии с идеей Шеннона, количество информации I в сообщении i определяется по формуле:

I = -log2 pi,

где pi – вероятность i-го сообщения (исхода).

Пример 1. Определить количество информации, содержащейся в сообщении о результате сдачи экзамена для студента-хорошиста.

|

|

|

Пусть I(j) – количество информации в сообщении о получении оценки j. В соответствии с формулой Шеннона имеем:

I(5) = -log2 0,5 = 1,

I(4) = -log2 0,3 = 1,74,

I(3) = -log2 0,1 = 3,32,

I(2) = -log2 0,1 = 3,32.

Таким образом, количество получаемой с сообщением информации тем больше, чем неожиданнее данное сообщение.

Формула Шеннона позволяет определять также размер двоичного эффективного кода, требуемого для представления того или иного сообщения, имеющего определенную вероятность появления.

Пример 2. Есть 4 сообщения: a, b, c, d с вероятностями, соответственно, р(a) = 0,5; р(b) = 0,25; р(c) = 0,125; р(d) = 0,125. Определить число двоичных разрядов, требуемых для кодирования каждого их четырех сообщений.

В соответствии с формулой Шеннона имеем:

I(a) = -log20,5 = 2=L,

I(b) = -log20,25 = 2=L,

I(c) = -log20,125 = 3=L,

I(d) = -log20,125 = 3=L.

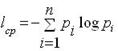

Помимо информационной оценки одного сообщения, Шеннон предложил количественную информационную оценку всех сообщений, которые можно получить по результатам проведения некоторого опыта. Так, среднее количество информации Iср, получаемой со всеми n сообщениями, определяется по формуле:

где pi – вероятность i-го сообщения.

Пример 3. Определить среднее количество информации, получаемое студентом-хорошистом, по всем результатам сдачи экзамена.

В соответствии с приведенной формулой имеем:

Iср = - (0,5*log20,5 + 0,3*log20,3 + 0,1*log20,1 + 0,1*log20,1) = 1,67.

Пример 4. Определить среднее количество информации, получаемое нерадивым студентом, по всем результатам сдачи экзамена.

В соответствии с приведенной формулой имеем:

Iср = - (0,1*log20,1 + 0,2*log20,2 + 0,4*log20,4 + 0,3*log20,3) = 1,73.

Большее количество информации, получаемое во втором случае, объясняется большей непредсказуемостью результатов: в самом деле, у хорошиста два исхода равновероятны.

Пусть у опыта два равновероятных исхода, составляющих полную группу событий, т.е. p1 = p2 = 0,5. Тогда имеем в соответствии с формулой для расчета I ср:

|

|

|

I ср = -(0,5*log20,5 + 0,5*log20,5) = 1.

Эта формула есть аналитическое определение бита по Шеннону: это среднее количество информации, которое содержится в двух равновероятных исходах некоторого опыта, составляющих полную группу событий.

Пример 5: Пусть, например, есть автомат, формирующий двузначные десятичные целые положительные числа (исходное множество информационных элементов {0, 1, 2, 3, 4, 5, 6, 7, 8, 9}).

Автомат генерирует размещения:

Числа 34, 43 - из 10 элементов (используются 10 цифр) по 2

с повторениями - 33, 66 из одинаковых цифр.

Можно оценить, сколько различных сообщений (двузначных чисел) может сформировать автомат,

иначе говоря, можно оценить информационную емкость данного устройства: Рп(102) = 102 = 100.

|

|

|

|

|

Дата добавления: 2014-01-06; Просмотров: 915; Нарушение авторских прав?; Мы поможем в написании вашей работы!