КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

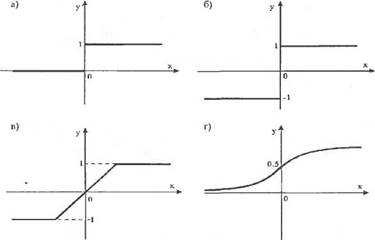

Персептрон. Модель МакКаллока-Питтса стала отправной точкой для построения простейшей однонаправленной нейронной сети

|

|

|

|

| д) |

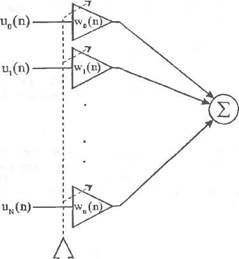

Модель МакКаллока-Питтса стала отправной точкой для построения простейшей однонаправленной нейронной сети, названной персептроном. Такую сеть предложил и исследовал Розенблатт [18] в конце пятидесятых - начале шестидесятых годов XX века. На рис. 2.4 представлена структура персептрона, иногда называемого

Рис. 2.2. Модель нейрона.

Рис. 2.3. Примеры функции f.

22 Глава 2. Многослойные нейронные сети и алгоритмы их обучения

2.3. Персептрон

| |||

|

|

| x(n)r-Mi—I У(п) |

| d(n) |

Е(П)

Е(П)

Алгоритм обучения персептрона

w(n+1) = w(n) + Ti[d(n) - y(n)] u(n)

Рис. 2.4. Персептрон.

простейшим персептроном. В качестве функции fe модели МакКал-лока-Питтса (2.2) применялась биполярная функция активации (2.4). Сигнал х на выходе линейной части персептрона задается выражением

N

N

| х= |

(2.8)

i=0

где w0 = v,u0 = -1.

Задача персептрона заключается в классификации вектора и =

[и,...... uN]T в смысле отнесения его к одному из двух классов, обознача

емых символами L1 и L2. Персептрон относит вектор и к классу Lv если

выходной сигнал у принимает значение 1, и к классу L2, если выходной

сигнал у принимает значение - 1. После этого персептрон разделяет

/V-мерное пространство входных векторов и на два полупространства,

разделяемые (ЛМ)-мерной гиперплоскостью, задаваемой уравнением

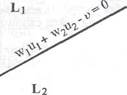

Гиперплоскость (2.9) называется решающей границей (decision boundary). Если N = 2, то решающая граница - это прямая линия, задаваемая уравнением

+ w2u2 - v = 0. (2.10)

Точка (и^иг), лежащая над этой прямой (рис. 2.5), относится к классу Ц, тогда как точка (и^,и2), лежащая под этой прямой, относится к классу L2. Точки, лежащие на границе решения, можно произвольно отнести и к классу Ц и к классу L2.

Для дальнейших рассуждений допустим, что веса ил, / = 0, 1.... N

в уравнении гиперплоскости (2.9) неизвестны, тогда как на вход персеп

трона последовательно подаются так называемые обучающие сигналы

и(п), п=\,2..... где и(п) = Щп).......... иЛп)]Т.

Неизвестные значения весов будут определяться в процессе обучения персептрона. Такой подход получил название «обучение с учителем» или «обучение под надзором». Роль «учителя» заключается в корректном отнесении сигналов и(п) к классам L1 или /_2, несмотря на неизвестность весов уравнения решающей границы (2.9). По завершении процесса обучения персептрон должен корректно классифицировать поступающие на его вход сигналы, в том числе и те, которые отсутствовали

в обучающей последовательности u(n), n = 1, 2...... Кроме того, примем,

что множества векторов u(n), n = 1,2,..., для которых выходной персептрона принимает соответственно значения 1 и -1, линейно отделены, т.е. лежат в двух различных полупространствах, разделенных гиперплоскостью (2.9). Другими словами, допускается разделение обучающей последовательности {и(л)} на две последовательности {и^п)} и {и2(п)} так, что {и,(п)} е Ц и {u2(n)} e L2.

В л-й момент времени сигнал на выходе линейной части персептрона определяется выражением

/=с

(2.9)

Рис. 2.5. Решающая граница для N = 2.

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

2.4. Системы типа Адалайн

| |||

|

| (2.11) |

=wT(n)u(n),

/=о

где

и(п) = [-1, 0,(17), и2(п)........... и»]7, (2.12)

w(n) = [v(n), Wi(n), w2(n)...... w^n)]T. (2.13)

Обучение персептрона заключается в рекуррентной коррекции вектора весов w(n) согласно формулам

Г w(n), если wT(n)u(n)>0 и и(п)е Ц,

win + Л = ■{ т с? 141

v ; I w(n), если wT(n)u(n)<0 и u(n)e L2, ( >

Г w(n)-riu(n), если wT(n)u(n)>0 и u(n)e L2, v ' I w(n)+77u(n), если ivr(n)(n)<0 и и(п)е Ц, * ;

где параметр 77 при 0 < т] < 1 - шаг коррекции, тогда как начальные значения компонент вектора весов устанавливаются равными нулю, т.е.

w(0) = 0. (2.16)

Зависимости (2.14) и (2.15) можно представить в более сжатом виде. Для этого определим так называемый эталонный (заданный) сигнал d(n) в форме

Г +1, если и(п)е L,,

-{ если u(n)eL2. (217)

Кроме того, отметим, что выходной сигнал персептрона может быть описан выражением

у(п) = sgn(wr(n)u(n)). (2.18)

С учетом введенных обозначений рекурсии (2.14) и (2.15) принимают вид

w(n + 1) = w(n) + [d(n) - у(п)] и(п). (2.19)

Разность d(n) - у(п) можно интерпретировать как погрешность между эталонным (заданным) сигналом d(n) и фактическим выходным сигналом у(п).

Сходимость алгоритма (2.19) исследовал Розенблатт в оригинальной работе [18], а также другие авторы в более поздних публикациях (например, [5, 7, 8]). С учетом принятого выше условия линейной сепарабельности входных сигналов алгоритм (2.19) сходится, т.е.

w(nQ) = iv(n0 + 1) = w(nQ + 2)=... (2.20)

По завершении обучения решающая граница персептрона определяется выражением

| =0, |

(2.21)

;=о

а персептрон корректно классифицирует как сигналы, которые принадлежат к обучающей выборке {и(п)}, так и не входящие в это множество, но выполняющие условие линейной сепарабельности. Напомним, что условию линейной сепарабельности не отвечает логическая функция XOR, заданная таблицей 2.1.

Из рис. 2.6 следует, что не существует прямой, которая отделила бы точки со значениями функции XOR, равными - 1, от точек со значениями, равными 1. В этом случае роль примерной границы играет эллипс, и поэтому алгоритм (2.18) не был бы сходящимся. Проблему XOR можно разрешить с помощью двухслойного персептрона. Эта. проблема детально исследована в работах [13] и [24].

2.4. Системы типа Адалайн

Системы типа Адалайн (Adaptive Linear Neuron - адаптивный линейный нейрон) были предложены в 1960 г. Видроу и Хоффом [25]. Вид-роу и Лер [26] описали целое семейство систем типа Адалайн. В настоя-

|

| U |

| Рис. 2.6. Иллюстрация проблемы XOR. |

Таблица 2.1. Логическая функция XOR

| "1 | и2 | d = XOR(u1lt/2) |

| +1 | +1 | -1 |

| +1 | -1 | +1 |

| -1 | +1 | +1 |

| -1 | -1 | _-| |

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

2.4. Системы типа Адалайн

щей главе перед детальным обсуждением систем типа Адалайн (пп. 2.4.2 и 2.4.3) рассмотрим модель так называемого линейного взвешенного сум-матора.

щей главе перед детальным обсуждением систем типа Адалайн (пп. 2.4.2 и 2.4.3) рассмотрим модель так называемого линейного взвешенного сум-матора.

|

|

|

|

|

Дата добавления: 2015-06-04; Просмотров: 1038; Нарушение авторских прав?; Мы поможем в написании вашей работы!