КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Вопрос 22. Построение дерева индуктивного вывода. Применение деревьев принятия решений в СОВ

|

|

|

|

Деревья принятия решений обычно используются для решения задач классификации данных (аппроксимации заданной булевской функции). Задача - создать достаточно экономичную конструкцию, которая описывала бы эту функцию и позволяла классифицировать новые данные.

Построение по базе данных всех возможных деревьев – NP полная задача. Есть два принципа – принцип Оккама – «самое простое решение является правильным». То есть самое короткое дерево является хорошим.

Для того, чтобы получить оптимальные деревья принятия решений, нужно на каждом шаге выбирать атрибуты, которые “лучше всего” характеризуют целевую функцию. Это требование формализуется посредством понятия энтропии[1].

А - Множество

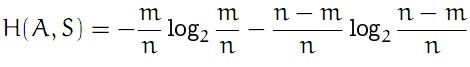

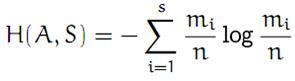

S - свойство, классифицированное при помощи атрибута

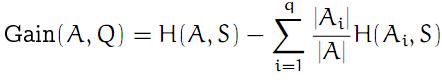

Q - атрибут, у него q возможных значений

Ai -множество элементов А, для которых атрибут Q имеет значение i

Если S не бинарное а имеет s значений, каждое из которых реализуется в mi случаях

Прирост информации

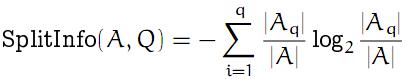

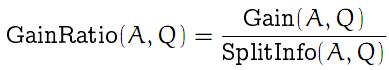

Чтобы не плодить херни, вводим критерий уменьшения желательности с ростом количества значений. SplitInfo - поправка, GainRatio - новый, взвешенный критерий.

Выбирают более короткие деревья и деревья, помещающие атрибуты с наибольшим приростом информации ближе к корню дерева.

Типовые алгоритмы: ID3, C4.5

Плюсы:

· схема одновременного ветвления, которая позволяет изучать эффект влияния отдельных переменных и производить последующий анализ их вклада

· отсутствие предварительных представлений о законах распределения данных

Применимость:

· образцы представлены в виде пар атрибут-значение

· целевая функция имеет дискретные выходные значения

· целесообразно представление знаний в виде дизъюнкций

· существуют модификации, делающие метод устойчивым к ошибкам.

· обучающие данные могут содержать пропуски в значениях атрибутов

Существует проблема переобучения → что делается:

· ограничение глубины дерева

· отсечение лишних ветвей

|

|

|

|

Дата добавления: 2014-01-15; Просмотров: 647; Нарушение авторских прав?; Мы поможем в написании вашей работы!