КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Обучение без учителя

|

|

|

|

Б) Слишком большие коррекции весов могут привести к постоянной неустойчивости процесса обучения.

А) Приращения весов и, следовательно, скорость обучения для нахождения экстремума должны быть бесконечно малыми, однако тогда бесконечно возрастает время обучения.

Применение метода градиентного спуска не гарантирует нахождения глобального минимума целевой функции.

Б) Малые величины производной сигмоиды приведут к остановке обучения, что парализует сеть.

А) Большие по модулю значения весов могут сместить рабочую точку на сигмоидах нейронов в область насыщения.

Возможные проблемы при выборе структуры и обучении нейросети:

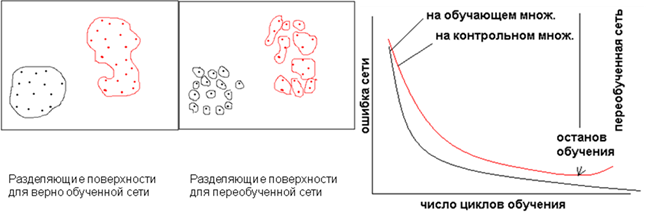

•Возможность “переобучения” нейросети: возможно при длительном обучении сети и сложности сети, превышающей необходимую сложность для решения данной задачи. Для того, чтобы избежать “переобучения” сети, можно выделить отдельно обучающее и тестовое множество и обучать сеть до тех пор, пока ошибка на тестовом множестве (ошибка обобщения) не начнет расти. Другой способ – “зашумлять” небольшими случайными значениями обучающую выборку.

•При многократном повторении обучения высока вероятность подбора сети, минимизирующей ошибку на контрольном множестве, так как она также косвенно участвует в обучении. Поэтому необходимо дополнительное тестовое множество, которое можно использовать только один раз для проверки качества обученной.

•При недостаточной сложности сети верные разделяющие поверхности могут не построиться, например, на 1 нейроне с 2 синапсами не реализовать логическую функцию XOR.

Для подбора структуры сети можно использовать критерии:

-Если ошибка на контрольном множестве начала расти, можно уменьшить количество нейронов в скрытых слоях.

-И наоборот, если ошибка на обучающем множестве не достигла нужного значения, сложность сети следует повысить.

Алгоритмы обучения Хебба

|

|

|

|

|

Дата добавления: 2014-01-20; Просмотров: 501; Нарушение авторских прав?; Мы поможем в написании вашей работы!