КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Алгоритм обучения однослойной нейронной сети

|

|

|

|

Обучение нейронной сети происходит на некоторой обучающей выборке, для каждого образца которой определяются и сравниваются с желаемыми значениями все текущие выходы. Если разница недопустима, то веса изменяются. Концом обучения считается ситуация, когда общая ошибка на всех образцах допустима.

Рассмотрим обучение линейной однослойной сети, представленной на рис. 4.10.

Структура обучающей выборки -

Х = (Х1, Х2,..., Хn), O = (O1, O2,..., Om).

Пусть для обучения нам представлена выборка: ХK, YK, K =1,... K, O  {1,0}.

{1,0}.

Приведем описание алгоритма обучения по шагам.

1. Введём к = 1; к -- номер образца.

2. Случайным образом инициализируем матрицу весов Wij;

Е = 0, где Е - ошибка.

3. Начнем обучение (на модели), для чего просчитаем все выходы

для любого Оi.

4. Рассчитаем разницу между текущими и желаемыми значениями выходов, т.е. вычислим (Yi - Oi), для каждого i.

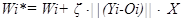

5. Изменим веса по правилу

для каждого Wi, Yi.

для каждого Wi, Yi.

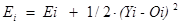

6. Вычислим накопленную ошибку  , выберем следующий образец из обучающей выборки к = к + 1.

, выберем следующий образец из обучающей выборки к = к + 1.

7. Проанализируем текущий результат. Если к  K, то следует учесть ошибку. Если значение ошибки Е меньше заданного уровня , то достигнут конец обучения. Если накопленная ошибка больше , то установим к = 1, Е = 0 и вернемся к шагу 3, т. е. продолжим обучение.

K, то следует учесть ошибку. Если значение ошибки Е меньше заданного уровня , то достигнут конец обучения. Если накопленная ошибка больше , то установим к = 1, Е = 0 и вернемся к шагу 3, т. е. продолжим обучение.

Доказана теорема о сходимости алгоритма обучения однородной нейросети. Если задача линейносепарабельна, то алгоритм обучения однослойной нейросети сходится за конечное число шагов.

|

|

|

|

|

Дата добавления: 2014-01-11; Просмотров: 1285; Нарушение авторских прав?; Мы поможем в написании вашей работы!