КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Меры информации

|

|

|

|

Количество информации и единицы ее измерения.

Теория информации рассматривает следующие меры количества информации:

I. Синтаксическая мера информации оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту. На этом уровне объем данных в сообщении измеряется количеством символов в этом сообщении.

Рассмотрим два подхода к измерению синтаксической информации.

1. Содержательный подход. Информация измеряется в битах, байтах и т.д., т.е. для определения количества применяется двоичная система счисления. Минимальная единица – бит.

Количество информации i, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, определяется из решения показательного уравнения

2 i = N (1)

В общем виде

m n = N (2)

Эту формулу в 1928 году вывел Ричард Хартли. В ней

N – количество равновероятных событий,

n – число разрядов (символов в сообщении),

m – основание системы счисления.

Для двоичной системы счисления m = 2, n = i, т.о.

2 i = N, или i = log 2 N (3)

Эта формула является частным случаем формулы Клода Шеннона, когда количество информации определяется не через количество возможных равновероятных событий, а через вероятность. Величина вероятности определяется в долях или процентах и

0% < P < 100%

или

0 < P < 1.

Если события не равновероятны, то согласно теории информации нужно решить показательное уравнение (получено из формулы Шеннона)

2 i = 1/P или i = log 2 (1/P) (4)

P – вероятность события. Чем меньше вероятность, тем больше информации.

2. Алфавитный подход. При этом подходе используется мощность алфавита N (в том числе знаки препинания и пробел). Расчет осуществляется по формулам (3). Каждый символ несет i бит информации. Например, в русскоязычном алфавите 54 символа, т.е. N = 54, следовательно i = log254 = 5,75. Количество информации, содержащееся в символьном сообщении К*i, где К – количество символов сообщения, i - информационный вес символа алфавита, мощность которого N.

II. Семантическая мера информации используется для измерения смыслового содержания информации. Наибольшее распространение здесь получила тезаурусная мера, предложенная Ю.И. Шнейдером (идеи тезаурусного метода были сформулированы еще основоположником кибернетики Н. Винером) и связывающая семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для понимания и использования информации ее получатель должен обладать определенным запасом знаний.

Тезаурус — это совокупность сведений, которыми располагает пользователь или система. Максимальное количество семантической информации потребитель получает при согласовании ее смыслового содержания со своим тезаурусом, когда поступающая информация понятна пользователю и несет ему ранее не известные сведения.

Семантический подходопределения количества информации является наиболее трудно формализуемым и до сих пор окончательно не определившимся. Тем не менее…:

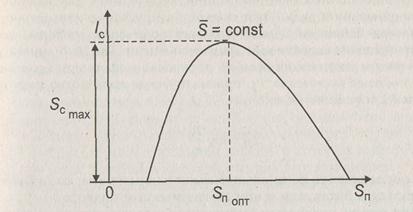

Если индивидуальный тезаурус потребителя Sп отражает его знания о данном предмете, то количество смысловой информации Iс, содержащееся в некотором сообщении, можно оценить степенью изменения этого тезауруса, произошедшего под воздействием данного сообщения. Очевидно, что количество информации Iс нелинейно зависит от состояния индивидуального тезауруса пользователя, и хотя смысловое содержание сообщения Sп постоянно, пользователи, имеющие различные тезаурусы, будут получать неодинаковое количество информации. В самом деле, если индивидуальный тезаурус получателя информации близок к нулю (Sп ~ 0), то в этом случае и количество воспринятой информации равно нулю: Iс = 0.

Иными словами, получатель не понимает принятого сообщения и, как следствие, для него количество воспринятой информации равно нулю. Такая ситуация эквивалентна прослушиванию сообщения на неизвестном иностранном языке.

Несомненно, сообщение не лишено смысла, однако оно непонятно, а значит, не имеет информативности.

Количество семантической информации Ic в сообщении также будет равно нулю, если пользователь информации абсолютно все знает о предмете, т.е. его тезаурус Sп и сообщение не дают ему ничего нового.

Интуитивно мы чувствуем, что между этими полярными значениями тезауруса пользователя существует некоторое оптимальное значение Sпопт при котором количество информации Ic, извлекаемое из сообщения, становится для получателя максимальным. Эта функция зависимости количества информации Ic от состояния индивидуального тезауруса пользователя Sп приведена на рисунке.

Тезаурусный метод подтверждает тезис о том, что информация обладает свойством относительности и имеет, таким образом, относительную, субъективную ценность. Для того чтобы объективно оценивать научную информацию, появилось понятие общечеловеческого тезауруса, степень изменения которого и определяла бы значительность получаемых человечеством новых знаний.

III. Прагматическая мера информации определяет ее полезность, ценность для процесса управления. Обычно ценность информации измеряется в тех же единицах, что и целевая функция управления системой.

Прагматический подход определяет количество информации как меры, способствующей достижению поставленной цели. Одной из первых работ, реализующей этот подход, явилась статья А.А. Харкевича. В ней он предлагал принять за меру ценности информации количество информации, необходимое для достижения поставленной цели. Этот подход базируется на статистической теории Шеннона и рассматривает количество информации как приращение вероятности достижения цели. Так, если принять вероятность достижения цели до получения информации равной Ро, а после ее получения Р1, прагматическое количество информации Iп определяется как

Iп = log Р1/ Ро

Если основание логарифма сделать равным двум, то Iп будет измеряться в битах, как и при синтаксическом подходе.

При оценке количества информации в семантическом и прагматическом аспектах необходимо учитывать и временную зависимость информации. Дело в том, что информация, особенно в системах управления экономическими объектами, имеет свойство стареть, т.е. ее ценность со временем падает, и важно использовать ее в момент наибольшей ценности.

|

|

|

|

|

Дата добавления: 2014-12-17; Просмотров: 5116; Нарушение авторских прав?; Мы поможем в написании вашей работы!