КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

История искусственного интеллекта

|

|

|

|

После ознакомления с изложенным выше материалом о предъистории искусственного интеллекта перейдем к изучению процесса развития самого искусственного интеллекта.

Появление предпосылок искусственного интеллекта (период с 1943 года по 1955 год)

Первая работа, которая теперь по общему признанию считается относящейся к искусственному интеллекту, была выполнена Уорреном Мак-Каллоком и Уолтером Питтсом. Они черпали вдохновение из трех источников: знание основ физиологии и назначения нейронов в мозгу; формальный анализ логики высказываний, взятый из работ Рассела и Уайтхеда; а также теория вычислений Тьюринга. Мак-Каллок и Питтс предложили модель, состоящую из искусственных нейронов, в которой каждый нейрон характеризовался как находящийся во “включенном” или “выключенном” состоянии, а переход во “включенное” состояние происходил в ответ на стимуляцию достаточного количества соседних нейронов. Состояние нейрона рассматривалось «как фактически эквивалентное высказыванию, в котором предлагается адекватное количество стимулов». Работы этих ученых показали, например, что любая вычислимая функция может быть вычислена с помощью некоторой сети из соединенных нейронов и что все логические связки(“И”, “ИЛИ”, “НЕ” и т.д.) могут быть реализованы с помощью простых сетевых структур. Кроме того, Мак-Каллок и Питтс выдвинули предположение, что сети, структурированные соответствующим образом, способны к обучению.

Дональд Хебб продемонстрировал простое правило обновления для модификации количества соединений между нейронами. Предложенное им правило, называемое теперь правилом хеббовского обучения, продолжает служить основой для моделей, широко используемых и в наши дни. Два аспиранта факультета математики Принстонского университета, Марвин Минский и Дин Эдмондс, в 1951 году создали первый сетевой компьютер на основе нейронной сети. В этом компьютере, получившем название Snarc, использовалось 3000 электронных ламп и дополнительный механизм автопилота с бомбардировщика В-24 для моделирования сети из 40 нейронов. Аттестационная комиссия, перед которой Минский защищал диссертацию доктора философии, выразила сомнение в том, может ли работа такого рода рассматриваться как математическая, на что фон Нейман, по словам современников, возразил: “Сегодня — нет, но когда-то будет”.

В дальнейшем Минский доказал очень важные теоремы, показывающие, с какими ограничениями должны столкнуться исследования в области нейронных сетей. Кроме того, можно привести большое количество примеров других ранних работ, которые можно охарактеризовать как относящиеся к искусственному интеллекту, но именно Алан Тьюринг впервые выразил полное представление об искусственном интеллекте в своей статье Сотриting Масhinery апd Intellgence, которая была опубликована в 1950 году. В этой статье он описал тест Тьюринга, принципы машинного обучения, генетические алгоритмы и обучение с подкреплением.

Рождение искусственного интеллекта (1956 год)

В Принстонском университете проводил свои исследования еще один авторитетный специалист в области искусственного интеллекта, Джон Маккарти. После получения ученой степени Маккарти перешел в дартмутский колледж, который и стал официальным местом рождения этой области знаний. Маккарти уговорил Марвина Минского, Клода Шеннона и Натаниэля Рочестера, чтобы они помогли ему собрать всех американских исследователей, проявляющих интерес к теории автоматов, нейронным сетям и исследованиям интеллекта. Они организовывали двухмесячный семинар в Дартмуте летом 1956 года. Всего на этом семинаре присутствовали 10 участников, включая Тренчарда Мура из Принстонского университета, Артура Самюэла из компании IВМ, а также Рея Соломонова и Оливера Селфриджа из Массачусетсского технологического института. Два исследователя из технологического института Карнеги, Аллен Ньюэлл и Герберт Саймон, буквально монополизировали все это представление.

Тогда как другие могли лишь поделиться своими идеями и в некоторых случаях показать программы для таких конкретных приложений, как шашки, Ньюэлл и Саймон уже могли продемонстрировать программу, проводящую рассуждения, Logic Theorist (LТ), или логик-теоретик (для написания программы LТ Ньюэлл и Саймон разработали также язык обработки списков. У них не было компилятора, поэтому эти ученые транслировали программы на своем языке в машинный код вручную. Чтобы избежать ошибок, они работали параллельно, называя друг другу двоичные числа после записи каждой команды, чтобы убедиться в том, что они совпадают), в отношении которой Саймон заявил: “Мы изобрели компьютерную программу, способную мыслить в нечисловых терминах и поэтому решили почтенную проблему о соотношении духа и тела”. Вскоре после этого семинара программа показала свою способность доказать большинство теорем из главы 2 труда Рассела и Уайтхеда Ргiпсiрiа Маtетаiiса. Сообщали, что Рассел пришел в восторг, когда Саймон показал ему, что эта программа предложила доказательство одной теоремы, более короткое, чем в Ргiпсiрiа. Редакторы ]оиiпа1 оf 5утbolic Logic оказались менее подверженными эмоциям; они отказались принимать статью, в качестве соавторов которой были указаны Ньюэлл, Саймон и программа Logic Theorist.

Дартмутский семинар не привел к появлению каких-либо новых крупных открытий, но позволил познакомиться всем наиболее важным деятелям в этой научной области. Они, а также их студенты и коллеги из Массачусетсского технологического института, Университета Карнеги—Меллона, Станфордского университета и компании IВМ занимали ведущее положение в этой области в течение следующих 20 лет. Возможно, дольше всего сохранившимся результатом данного семинара было соглашение принять новое название для этой области, предложенное Маккарти, — искусственный интеллект. Возможно, лучше было бы назвать эту научную область “вычислительная рациональность”, но за ней закрепилось название “искусственный интеллект”.

Анализ предложений по тематике докладов для дартмутского семинара позволяет понять, с чем связана необходимость преобразовать искусственный интеллект в отдельную область знаний. Почему нельзя было бы публиковать все работы, выполненные в рамках искусственного интеллекта, под флагом теории управления, или исследования операций, или теории решений, которые в конечном итоге имеют цели, аналогичные искусственному интеллекту? Или почему искусственный интеллект не рассматривается как область математики? Ответом на эти вопросы, во- первых, является то, что искусственный интеллект с самого начала впитал идею моделирования таких человеческих качеств, как творчество, самосовершенствование и использование естественного языка. Эти задачи не рассматриваются ни в одной из указанных областей. Во-вторых, еще одним ответом является методология.

Искусственный интеллект — это единственная из перечисленных выше областей, которая, безусловно, является одним из направлений компьютерных наук (хотя в исследовании операций также придается большое значение компьютерному моделированию), кроме того, искусственный интеллект — это единственная область, в которой предпринимаются попытки создания машин, действующих автономно в сложной, изменяющейся среде.

Ранний энтузиазм, большие ожидания (период с 1952 года по 1969 год)

Первые годы развития искусственного интеллекта были полны успехов, хотя и достаточно скромных. Если учесть, какими примитивными были в то время компьютеры и инструментальные средства программирования, и тот факт, что лишь за несколько лет до этого компьютеры рассматривались как устройства, способные выполнять только арифметические, а не какие-либо иные действия, можно лишь удивляться тому, как удалось заставить компьютер выполнять операции, хоть немного напоминающие разумные. Интеллектуальное сообщество в своем большинстве продолжало считать, что “ни одна машина не сможет выполнить действие х”. (длинный список таких х, собранный Тьюрингом, приведен в разделе1.1.) Вполне естественно, что исследователи в области искусственного интеллекта отвечали на это, демонстрируя способность решать одну задачу Х за другой. Джон Маккарти охарактеризовал этот период как эпоху восклицаний: «Гляди мама, что я умею!».

За первыми успешными разработками Ньюэлла и Саймона последовало создание программы общего решателя задач (General Problem Solver — GPS). В отличие от программы Logic Theorist, эта программа с самого начала была предназначена для моделирования процедуры решения задач человеком. Как оказалось, в пределах того ограниченного класса головоломок, которые была способна решать эта программа, порядок, в котором она рассматривала подцели и возможные действия, был аналогичен тому подходу, который применяется людьми для решения таких же проблем. Поэтому программа GPS была, по-видимому, самой первой программой, в которой был воплощен подход к “организации мышления по такому же принципу, как и у человека”. Результаты успешного применения GPS и последующих программ в качестве модели познания позволили сформулировать знаменитую гипотезу физической символической системы, в которой утверждается, что существует “физическая символическая система, которая имеет необходимые и достаточные средства для интеллектуальных действий общего вида”.

Под этим подразумевается, что любая система, проявляющая интеллект (человек или машина), должна действовать по принципу манипулирования структурами данных, состоящими из символов. Ниже будет показано, что эта гипотеза во многих отношениях оказалась уязвимой для критики. Работая в компании 1ВМ, Натаниэль Рочестер и его коллеги создали некоторые из самых первых программ искусственного интеллекта. Герберт Гелернтер сконструировал программу Geometry Theorem Prover (программа автоматического доказательства геометрических теорем), которая была способна доказывать такие теоремы, которые показались бы весьма сложными многим студентам-математикам.

Начиная с 1952, года Артур Самюэл написал ряд программ для игры в шашки, которые в конечном итоге научились играть на уровне хорошо подготовленного любителя. В ходе этих исследований Самюэл опроверг утверждение, что компьютеры способны выполнять только то, чему их учили: одна из его программ быстро научилась играть лучше, чем ее создатель. Эта программа была продемонстрирована по телевидению в феврале 1956 года и произвела очень сильное впечатление на зрителей. Как и Тьюринг, Самюэл с трудом находил машинное время. Работая по ночам, он использовал компьютеры, которые все еще находились на испытательной площадке производственного предприятия компании IВМ. Джон Маккарти перешел из Дартмутского университета в Массачусетсский технологический институт и здесь в течение одного исторического 1958 года внес три крайне важных вклада в развитие искусственного интеллекта.

В документе МIТ Джон Маккарти привел определение нового языка высокого уровня LISP, которому суждено было стать доминирующим языком программирования для искусственного интеллекта. LISP остается одним из главных языков высокого уровня, применяемых в настоящее время, будучи вместе с тем вторым по очередности появления языком такого типа, который был создан всего на один год позже, чем FORTRAN. Разработав язык LISP, Маккарти получил необходимый для него инструмент, но доступ к ограниченным и дорогостоящим компьютерным ресурсам продолжал оставаться серьезной проблемой. В связи с этим он совместно с другими сотрудниками Массачусетсского технологического института изобрел режим разделения времени. В том же 1958 году Маккарти опубликовал статью,в которой он описал гипотетическую программу Аdvice Taker, которая может рассматриваться как первая полная система искусственного интеллекта. Как и программы Logic Theorist и Geometry Theorem Prover, данная программа Маккарти была предназначена для использования знаний при поиске решений задач. Но в отличие от других программ она была предназначена для включения общих знаний о мире.

Например, Маккарти показал, что некоторые простые аксиомы позволяют этой программе разработать план оптимального маршрута автомобильной поездки в аэропорт, чтобы можно было успеть на самолет. Данная программа была также спроектирована таким образом, что могла принимать новые аксиомы в ходе обычной работы, а это позволяло ей приобретать компетентность в новых областях без перепрограммирования. Таким образом, в программе Аdvice Taker были воплощены центральные принципы представления знаний и проведения рассуждений, которые заключаются в том, что всегда полезно иметь формальное, явное представление о мире, а также о том, как действия агента влияют на этот мир и как приобрести способность манипулировать подобными представлениями с помощью дедуктивных процессов. Замечательной особенностью указанной статьи, которая вышла в 1958 году, является то, что значительная ее часть не потеряла своего значения и в наши дни.

Знаменитый 1958 год отмечен также тем, что именно в этот год Марвин Минский перешел в Массачусетсский технологический институт. Но успешно складывавшееся на первых порах его сотрудничество с Маккарти продолжалось недолго. Маккарти настаивал на том, что нужно изучать способы представления и проведения рассуждений в формальной логике, тогда как Минский в большей степени интересовался тем, как довести программы до рабочего состояния, и в конечном итоге у него сформировалось отрицательное отношение к логике.

В 1963 году Маккарти открыл лабораторию искусственного интеллекта в Станфордском университете. Разработанный им план использования логики для создания окончательной версии программы Аdvice Taker выполнялся еще быстрее, чем было задумано, благодаря открытию Дж.А. Робинсоном метода резолюции. Работы, выполненные в Станфордском университете, подчеркнули важность применения методов общего назначения для проведения логических рассуждений. В число логических приложений вошли системы формирования ответов на вопросы и планирования Корделла Грина, а также робототехнический проект Shakey, разрабатываемый в новом Станфордском научно-исследовательском институте (SRI). Последний проект впервые продемонстрировал полную интеграцию логических рассуждений и физической активности. Минский руководил работой ряда студентов, выбравших для себя задачи ограниченных масштабов, для решения которых, как в то время казалось, требовалась интеллектуальность. Эти ограниченные проблемные области получили название микромиров.

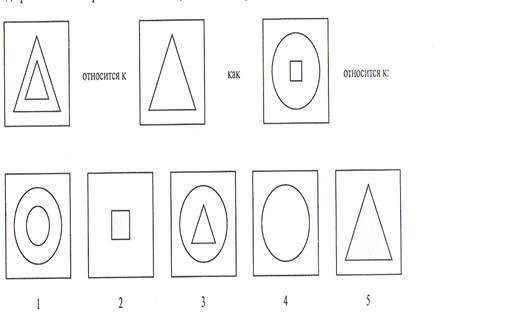

Программа Saint Джеймса Слэгла оказалась способной решать задачи интеграции в исчислении замкнутой формы, типичные для первых курсов колледжей. Программа Тома Эванса решала задачи выявления геометрических аналогий, применяемые при проверке показателя интеллекта, аналогичные приведенной на рис.9.

Рис. 9. Пример задачи. решаемой программой Analogy

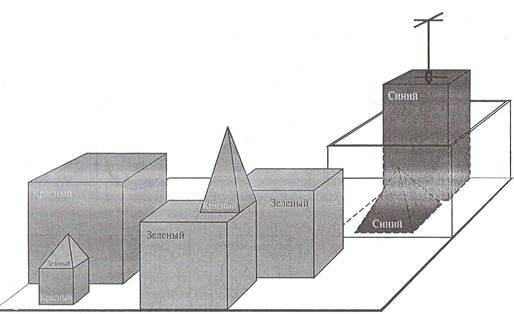

Программа Student Дэниэла Боброва решала изложенные в виде рассказа алгебраические задачи, подобные задаче, приведенной ниже. ”Если количество заказов, полученных Томом, вдвое превышает квадратный корень из 20% опубликованных им рекламных объявлений, а количество этих рекламных объявлений равно 45, то каково количество заказов, полученных Томом?“ Наиболее известным примером микромира был мир блоков, состоящий из множества цельных блоков, размещенных на поверхности стола (или, что более часто, на имитации стола), как показано на рис. 10.

Рис. 10. Сцена из мира блоков. Программа Shrdlu только что завершила выполнение команды “Найти блок, более высокий по сравнению с тем, который находится в манипуляторе, и поместить его в ящик”

Типичной задачей в этом мире является изменение расположения блоков определенным образом с использованием манипулятора робота, который может захватывать по одному блоку одновременно. Мир блоков стал основой для проекта системы технического зрения Дэвида Хаффмена, работы по изучению зрения и распространения (удовлетворения) ограничений Дэвида Уолтса, теории обучения Патрика Уинстона, программы понимания естественного языка Тэрри Винограда и планировщика в мире блоков Скотта Фалмана.

Бурно продвигались также исследования, основанные на ранних работах по созданию нейронных сетей Мак-Каллока и Питтса. В работе Винограда и Коуэна было показано, как нужно представить отдельную концепцию с помощью коллекции, состоящей из большого количества элементов, соответственно увеличивая надежность и степень распараллеливания их работы. Методы обучения Хебба были усовершенствованы в работах Берни Видроу, который называл свои сети адалинами, а также в работах Френка Розенблатта, создателя персептронов. Розенблатт доказал теорему сходимости персептрона, которая подтверждает, что предложенный им алгоритм обучения позволяет корректировать количество соединений персептрона в соответствии с любыми входными данными, при условии, что такое соответствие существует.

Столкновение с реальностью (период с 1966 года по 1973 год)

С самого начала исследователи искусственного интеллекта не отличались сдержанностью, высказывая прогнозы в отношении своих будущих успехов. Например, часто цитировалась приведенное ниже предсказание Герберта Саймона, опубликованное им в 1957 году. «Я не ставлю перед собой задачу удивить или шокировать вас, но проще всего я могу подвести итог, сказав, что теперь мы живем в таком мире, где машины могут думать, учиться и создавать. Более того, их способность выполнять эти действия будет продолжать расти до тех пор, пока (в обозримом будущем) круг проблем, с которыми смогут справиться машины, будет сопоставим с тем кругом проблем, где до сих пор был нужен человеческий мозг».

Такие выражения, как “обозримое будущее”, могут интерпретироваться по-разному, но Саймон сделал также более конкрет-ный прогноз, что через десять лет компьютер станет чемпионом мира по шахматам и что машиной будут доказаны все важные математические теоремы. Эти предсказания сбылись (или почти сбылись) не через десять лет, а через сорок. Чрезмерный оптимизм Саймона был обусловлен тем, что первые системы искусственного интеллекта демонстрировали многообещающую производительность, хотя и на простых примерах. Но почти во всех случаях эти ранние системы терпели сокрушительное поражение, сталкиваясь с более широким кругом проблем или с более трудными проблемами.

Сложности первого рода были связаны с тем, что основная часть ранних программ не содержала знаний или имела лишь небольшой объем знаний о своей предметной области; их временные успехи достигались за счет простых синтаксических манипуляций. Типичная для этого периода история произошла при проведении первых работ по машинному переводу текста на естественном языке, которые щедро финансировались Национальным научно-исследовательским советом США, в попытке ускорить перевод советских научных статей во время того периода бурной деятельности, который начался вслед за запуском в СССР первого искусственного спутника Земли в 1957 году. Вначале считалось, что для сохранения точного смысла предложений достаточно провести простые синтаксические преобразования, основанные на грамматиках русского и английского языка и замену слов с использованием электронного словаря. Но дело в том что для устранения неоднозначности и определения смысла предложения в процессе перевода необходимо обладать общими знаниями о предметной области.

Возникающие при этом сложности иллюстрируются знаменитым обратным переводом фразы “the spirit is willng but the flesh is weak” (дух полон желаний, но плоть слаба), в результате которого получилось следующее: “the vodka is good but the meat is rotten” (водка хороша, но мясо испорчено). В 1966 году в отчете одного консультативного комитета было отмечено. что “машинный перевод научного текста общего характера не осуществлён и не будет осуществлен в ближайшей перспективе”. Все финансирование академических проектов машинного перевода правительством США было свернуто. В настоящее время машинный перевод является несовершенным, но широко применяемым инструментальным средством обработки технических, коммерческих, правительственных документов, а также документов, опубликованных в Internet.

Сложности второго рода были связаны с неразрешимостью многих проблем, решение которых пытались найти с помощью искусственного интеллекта. В большинстве ранних программ искусственного интеллекта решение задач осуществлялось по принципу проверки различных комбинаций возможных шагов, которая проводилась до тех пор, пока не будет найдено решение. На первых порах такая стратегия приводила к успеху, поскольку микромиры содержали очень небольшое количество объектов, поэтому предусматривали лишь незначительный перечень возможных действий и позволяли находить очень короткие последовательности решения.

До того как была разработана теория вычислительной сложности, было широко распространено такое мнение, что для “масштабирования” задач до уровня более крупных проблем достаточно просто применить более быстродействующие аппаратные средства с большим объемом памяти. Например, оптимизм, с которым были встречены сообщения о разработке метода доказательства теорем с помощью резолюции, быстро угас, когда исследователи не смогли доказать таким образом теоремы, которые включали чуть больше нескольких десятков фактов. Как оказалось, то, что программа может найти решение в принципе, не означает, что эта программа действительно содержит все механизмы, позволяющие найти данное решение на практике.

Иллюзия неограниченной вычислительной мощи распространялась не только на программы решения задач. Ранние эксперименты в области эволюции машин (которая теперь известна под названием разработка генетических алгоритмов), были основаны на уверенности в том. что внесение соответствующего ряда небольших изменений в машинный код программы позволяет создать программу решения любой конкретной простой задачи, обладающую высокой производительностью. Безусловно, что сам этот подход является вполне обоснованным. Поэтому общая идея состояла в том, что необходимо проверять случайные мутации (изменения в коде) с помощью процесса отбора для сохранения мутаций, которые кажутся полезными. На эти эксперименты было потрачено тысячи часов процессорного времени, но никаких признаков прогресса не было обнаружено. В современных генетических алгоритмах используются лучшие способы представления, которые показывают более успешные результаты.

Одним из основных критических замечаний в адрес искусственного интеллекта, содержащихся в отчете Лайтхилла, который лег в основу решения британского правительства прекратить поддержку исследований в области искусственного интеллекта во всех университетах, кроме двух, была неспособность справиться с “комбинаторным взрывом” — стремительным увеличением сложности задачи.

Сложности третьего рода возникли в связи с некоторыми фундаментальными ограничениями базовых структур, которые использовались для выработки интеллектуального поведения. Например, в работах Минского и Пейперта было доказано, что персептроны (простая форма нейронной сети) могут продемонстрировать способность изучить все, что возможно представить с их помощью, но, к сожалению, они позволяют представить лишь очень немногое. В частности, персептрон с двумя входами нельзя обучить распознаванию такой ситуации, при которой на два его входа подаются разные сигналы. Хотя полученные этими учеными результаты не распространяются на более сложные, многослойные сети, вскоре было обнаружено, что финансы, выделенные на поддержку исследований в области нейронных сетей, почти не приносят никакой отдачи. Любопытно отметить, что новые алгоритмы обучения путем обратного распространения для многослойных сетей, которые стали причиной возрождения необычайного интереса к исследованиям в области нейронных сетей в конце 1980-х годов, фактически были впервые открыты в 1969году.

Системы, основанные на знаниях: могут ли они стать ключом к успеху (период с 1969 года по 1979 год)

Основной подход к решению задач, сформированный в течение первого десятилетия исследований в области искусственного интеллекта, представлял собой механизм поиска общего назначения, с помощью которого предпринимались попытки связать в единую цепочку элементарные этапы проведения рассуждений для формирования полных решений. Подобные подходы получили название слабых методов, поскольку они не позволяли увеличить масштабы своего применения до уровня более крупных или более сложных экземпляров задач, несмотря на то, что были общими. Альтернативным по сравнению со слабыми методами стал подход, предусматривающий использование более содержательных знаний, относящихся к проблемной области, который позволяет создавать более длинные цепочки шагов логического вывода и дает возможность проще справиться с теми проблемными ситуациями, которые обычно возникают в специализированных областях знаний. Как известно, чтобы решить достаточно сложную задачу, необходимо уже почти полностью знать ответ.

Одним из первых примеров реализации такого подхода была программа Dendral. Она была разработана в Станфордском университете группой ученых, в которую вошли Эд Фейгенбаум (бывший студент Герберта Саймона), Брюс Бьюкенен (философ, который сменил специальность и стал заниматься компьютерными науками) и Джошуа Ледерберг (лауреат Нобелевской премии в области генетики). Эта группа занималась решением проблемы определения структуры молекул на основе информации, полученной от масс-спектрометра. Вход этой программы состоял из химической формулы соединения (например, C6H13NO2) и спектра масс, позволяющего определять массы различных фрагментов молекулы, который формировался при бомбардировке молекулы потоком электронов. Например, спектр масс может содержать пик в точке m = 15, соответствующий массе метилового фрагмента (CH3). Первая, примитивная версия этой программы предусматривала выработку всех возможных структур, совместимых с данной формулой, после чего предсказывала, какой спектр масс должен наблюдаться для каждой из этих структур, сравнивая его с фактическим спектром. Вполне можно ожидать, что такая задача применительно к молекулам более крупных размеров становится неразрешимой. Поэтому разработчики программы Dendral проконсультировались с химиками-аналитиками и пришли к выводу, что следует попытаться организовать работу по принципу поиска широко известных картин расположения пиков в спектре, которые указывают на наличие общих подструктур в молекуле.

Значение программы Dendral состояло в том, что это была первая успешно созданная экспертная система, основанная на широком использовании знаний, ее способность справляться с поставленными задачами была обусловлена применением большого количества правил специального назначения. В более поздних системах также широко применялся основной принцип подхода, реализованного Маккарти в программе Аdvice Taker, — четкое отделение знаний (в форме правил) от компонента, обеспечивающего проведение рассуждений. Руководствуясь этим опытом, Фейгенбаум и другие специалисты из Станфордского университета приступили к разработке проекта эвристического программирования НРР, целью которого было исследование того, в какой степени созданная ими новая методология экспертных систем может быть применена в других областях интеллектуальной деятельности человека. На очередном этапе основные усилия были сосредоточены в области медицинской диагностики. Фейгенбаум, Бьюкенен и доктор Эдвард Шортлифф разработали программу Mycin для диагностики инфекционных заболеваний кровеносной системы. После ввода в нее примерно 450правил программа Mycin приобрела способность работать на уровне некоторых экспертов, а также показала значительно лучшие результаты по сравнению с врачами, имеющими не такой большой стаж. Она также обладала двумя важными отличительными особенностями по сравнению с программой Dendral.

Во-первых, в отличие от правил Dendral не существовала общая теоретическая модель, на основании которой мог бы осуществляться логический вывод правил Mycin. Для выявления этих правил приходилось широко применять знания, полученные от экспертов, которые, в свою очередь, приобретали эти знания с помощью учебников, других экспертов и непосредственного опыта, накопленного путем изучения практических случаев.

Во-вторых, в этих правилах приходилось учитывать ту степень неопределенности, которой характеризуются знания в области медицины. В программе Mycin применялось исчисление неопределенностей на основе так называемых коэффициентов уверенности, которое (в то время) казалось вполне соответствующим тому, как врачи оценивают влияние объективных данных на диагноз.

Важность использования знаний в проблемной области стала также очевидной и для специалистов, которые занимались проблемами понимания естественного языка. Хотя система понимания естественного языка Shrdlu, разработанная Тэрри Виноградом, стала в свое время предметом всеобщего восхищения, ее зависимость от результатов синтаксического анализа вызвала появление примерно таких же проблем, которые обнаружились в ранних работах по машинному переводу. Эта система была способна преодолеть неоднозначность и правильно понимала ссылки, выраженные с помощью местоимений, но это в основном было связано с тем, что она специально предназначалась только для одной области — для мира блоков. Некоторые исследователи, включая Юджина Чарняка, коллегу и аспиранта Винограда в Массачусетском технологическом институте, указывали, что для обеспечения надежного понимания языка потребуются общие знания о мире и общий метод использования этих знаний. Работавший в Йельском университете Роджер Шенк, лингвист, ставший исследователем в области искусственного интеллекта, еще более ярко выразил эту мысль, заявив, что “такого понятия, как синтаксис, не существует”.

Это заявление вызвало возмущение многих лингвистов, но послужило началом полезной дискуссии. Шенк со своими студентами создал ряд интересных программ. Задача всех этих программ состояла в обеспечении понимания естественного языка. Но в них основной акцент был сделан в меньшей степени на языке как таковом и в большей степени на проблемах представления и формирования рассуждений с помощью знаний, требуемых для понимания языка. В число рассматриваемых проблем входило представление стереотипных ситуаций, описание организации человеческой памяти, а также понимание планов и целей. В связи с широким ростом количества приложений, предназначенных для решения проблем реального мира, столь же широко возрастали потребности в создании работоспособных схем представления знаний. Было разработано большое количество различных языков для представления знаний и проведения рассуждений. Некоторые из них были основаны на логике, например, в Европе получил распространение язык Рго1оg, а в Соединенных Штатах широко применялось семейство языков Рlаnneг.

В других языках, основанных на выдвинутой Минским идее фреймов, был принят более структурированный подход, предусматривающий сбор фактов о конкретных типах объектов и событий, а также упорядочение этих типов в виде крупной таксономической иерархии, аналогичной биологической таксономии.

|

|

|

|

|

Дата добавления: 2015-06-27; Просмотров: 1945; Нарушение авторских прав?; Мы поможем в написании вашей работы!