КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Условная энтропия

|

|

|

|

Условная энтропия.

Лекция 2

Тема 2. Основные виды энтропии дискретных источников. Условная и взаимная энтропии.

Для дальнейшего изложения нам понадобятся некоторые известные сведения из теории вероятности.

1) Свойства вероятностей для ансамбля случайных событий А и В:

P(A,B)=P(A)*P(B/A); -> P(B/A)=P(A,B)/P(B);

P(A,B)=P(B)*P(B/A); -> P(A/B)=P(A,B)/P(A);

P(A/B)=P(A)*P(B/A)/P(B); P(B/A)=P(B)*P(A/B)/P(A);

Если А и В независимы, то

P(A/B)=P(A); P(B/A)=P(B):

P(A,B)=P(A)*P(B);

Еще раз определение энтропии по Шеннону для источника дискретных сообщений:

Ее свойства:

Н > 0;

Нmах = log N;

При независимых источниках H(A,B)=H(A)+H(B);

Если состояния элементов системы не зависят друг от друга или если состояние одной системы не зависит от состояния другой системы, то неопределенность того, что некоторый элемент системы (или некоторая система) будет находиться в одном из возможных состояний, полностью определялась бы вероятностными характеристиками отдельных элементов системы. В этом случае удельное количество информации на состояние элемента системы или на один символ сообщений называется средней энтропией, а при ее вычислении используется выражение

При подсчете среднего количества информации на символ сообщения взаимозависимость учитывают через условные вероятности наступления одних событий относительно других, а полученную при этом энтропию называют условной энтропией.

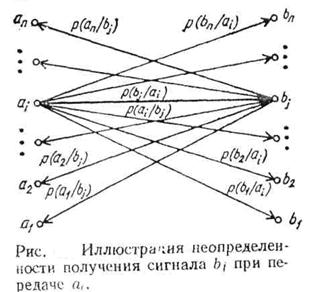

Рассмотрим передачу сообщений источника случайных символов А через канал передачи информации. При это полагается, что при достоверной передаче при при передаче символа a1 получаем b1, a2 - b2 и т.д. При этом для канала с помехами передача искажается, и при получении сивола b1 можно лишь сговорить о вероятности перередачи символа a1. Вполне может быть, что были переданы символы a2, a3 и т.д.

|

|

|

Искажения описываются матрицей условных вероятностей канала P(A/B)={p(ai/bi}.

Рассмотрим процесс передачи сигналов по каналу связи с помехами и используем его для уяснения механизма вычисления условной энтропии.

Если источник сообщений выдает символы

al, а2,..., ai..., аn

с вероятностями соответственно

р (а1), р (а2)......, р (аi),..., р (аn),

а на выходе канала передачи мы получаем символы

b1,b2,..., bi..., bn

с вероятностями соотетственно

р (b1), р (b2),..., р (bi,..., р (bn),

то понятие условной энтропии Н (B/ai) выражает неопределенность того, что, отправив ai, мы получим bi., понятие H(A/bi) неуверенность, которая остается после получения bi в том, что было отправлено именно ai. Графически это представлено на вышеприведеном рисунке. Если в канале связи присутствуют помехи, то с различной степенью вероятности может быть принят любой из сигналов bj и, наоборот, принятый сигнал bj может появиться и результате отправления любого из сигналов ai. Если в канале связи помехи отсутствуют, то всегда посланному символу а1 соответствует принятый символ b1, а2— b2,..., аn— bn.

При этом энтропия источника сообщений H(А) равна энтропии приемника сообщений Н (В). Если в канале связи присутствуют помехи, то они уничтожают или искажают часть передаваемой информации.

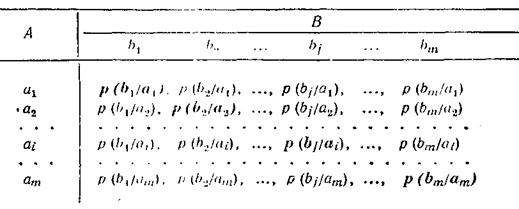

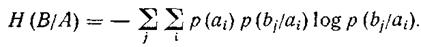

Информационные потери полностью описываются через частную и общую условную энтропию. Вычисление частных и общей условной энтропии удобно производить при помощи канальных матриц. Термин «канальная матрица», означающий: матрица, статистически описывающая данный канал связи, применяется для краткости. Если канал связи описывается со стороны источника сообщений (т. е. известен посланный сигнал), то вероятность того, что при передаче сигнала ai по каналу связи с помехами мы получим сигнал bj обозначается как условная вероятность р (bj/ai). а канальная матрица имеет вид

|

|

|

Вероятности, которые расположены по диагонали (выделенные полужирным шрифтом), определяют вероятности правильного приема, остальные — ложного. Значения цифр, заполняющих колонки канальной матрицы, обычно уменьшаются по мере удаления от главной диагонали и при полном отсутствии помех все, кроме цифр, расположенных на главной диагонали, равны нулю.

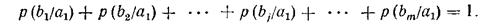

Прохождение символа ai со стороны источника сообщений в данном канале связи описывается распределением условных вероятностей вида р(bj/ai), сумма вероятностей которого всегда должна быть равна единице. Например, для сигнала а1

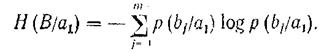

Потери информации, приходящиеся на долю сигнала ai описываются при помощи частной условной энтропии. Например, для сигнала a1

Суммирование производится по j, так как i -е состояние (в данном случае первое) остается постоянным.

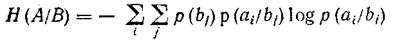

Потери при передаче всех сигналов по данному каналу связи описываются при помощи общей условной энтропии. Дли ее вычисления следует просуммировать все частные условные энтропии, т. е. произвести двойное суммирование по i и по j.

В случае неравновероятного появления символов источника сообщений следует учесть вероятность появления каждого символа, умножив на нее соответствующую частную условную энтропию. При этом общая условная энтропия

Если иследовать ситуацию со стороны приемника сообщений (то есть когда известен принятый сигнал), то то с получением символа bj предполагается, что был послан какойто из символов a1, a2, …, ai,…,am. В этом случае канальная матрица имеет вид:

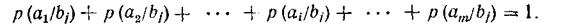

В этом случае единице должны равняться суммы условных вероятностей не по строкам, а по столбцам канальной матрицы

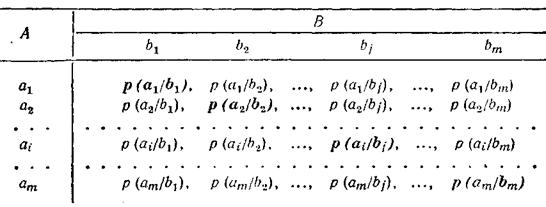

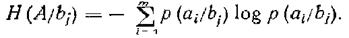

Частная условная энтропия

А общая условная энтропия

Общая условная энтропия системы В относительно системы А характеризует количество информации, содержащейся в любом символе источника сообщений, через который мы представляем состояния элементов исследуемых систем.

Общую условную энтропию определяют путем усреднения по всем символам, т. е. по всем состояниям аi с учетом вероятности появления каждого из них. Она равна сумме произведений вероятностей появления символов источника на неопределенность, которая остается после того, как адресат принял символы:

|

|

|

Если в канале связи помехи отсутствуют, то все элементы канальной матрицы, кроме расположенных на главной диагонали, равны нулю. Это говорит о том, что при передаче сигнала а1 мы наверняка получим b1 при передаче а2 -b2,..., аm— bm. Вероятность получения правильного сигнала станет безусловной, а условная энтропия будет равна нулю.

Своего максимума условная энтропия достигает в случае, когда при передаче символа аi может быть с равной вероятностью получен любой из сигналов b1, b2,..., bm.

|

|

|

|

|

Дата добавления: 2013-12-11; Просмотров: 4013; Нарушение авторских прав?; Мы поможем в написании вашей работы!