КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Мультиколлинеарность, гетероскедастичность и автокорреляция остатков

|

|

|

|

Мультиколлинеарность

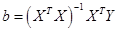

Одним из условий классической линейной регрессионной модели является предположение о линейной независимости объясняющих переменных, что означает линейную независимость столбцов матрицы  или (эквивалентно), что матрица

или (эквивалентно), что матрица  не вырождена. При нарушении этого условия, т.е. когда один из столбцов матрицы

не вырождена. При нарушении этого условия, т.е. когда один из столбцов матрицы  есть линейная комбинация остальных столбцов, говорят, что имеет место полная коллинеарность. В этой ситуации нельзя построить МНК-оценку вектора параметров

есть линейная комбинация остальных столбцов, говорят, что имеет место полная коллинеарность. В этой ситуации нельзя построить МНК-оценку вектора параметров  , поскольку

, поскольку  .

.

На практике полная коллинеарность встречается исключительно редко. Гораздо чаще приходится сталкиваться с ситуацией, когда матрица  имеет полный ранг, но между регрессорами имеется высокая степень корреляции, что приводит к тому, что матрица

имеет полный ранг, но между регрессорами имеется высокая степень корреляции, что приводит к тому, что матрица  близка к вырожденной. Тогда говорят о наличии мультиколлинеарности. В этом случае МНК-оценка существует, но обладает «плохими» свойствами.

близка к вырожденной. Тогда говорят о наличии мультиколлинеарности. В этом случае МНК-оценка существует, но обладает «плохими» свойствами.

Мультиколлинеарность может возникнуть в силу разных причин. Например, несколько независимых переменных могут иметь общий временной тренд, относительно которого они совершают малые колебания.

Признаки мультиколлинеарности:

1) Небольшое изменение исходных данных (например, добавление новых наблюдений) приводит к существенному изменению оценок  коэффициентов регрессии.

коэффициентов регрессии.

2) Оценки  имеют большие стандартные ошибки

имеют большие стандартные ошибки  (и, следовательно, большие доверительные интервалы), малую значимость (т.е. малые t -статистики

(и, следовательно, большие доверительные интервалы), малую значимость (т.е. малые t -статистики  ) в то время как модель в целом является значимой (т.е. высокое значение коэффициента детерминации

) в то время как модель в целом является значимой (т.е. высокое значение коэффициента детерминации  и соответствующей F -статистики

и соответствующей F -статистики  )

)

3) Оценки коэффициентов  имеют неоправданные с точки зрения теории знаки или неоправданно большие значения.

имеют неоправданные с точки зрения теории знаки или неоправданно большие значения.

4) Парная корреляция между малозначимыми объясняющими переменными достаточно высока.

5) Высокие частные коэффициенты корреляции.

Напомним, что выборочный коэффициент (парной) корреляции между переменными  и

и  находится по формуле:

находится по формуле:

(1)

(1)

Выборочный частный коэффициент корреляции находится следующим образом.

Пусть даны переменные  ,

,  .

.

Обозначим  .

.

Пусть  .

.

Пусть  ,

,  .

.

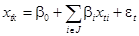

Построим регрессии  и

и  на

на  :

:

(2)

(2)

(3)

(3)

Найдем остатки для этих регрессий:

, (4)

, (4)

Частный коэффициент корреляции между  и

и  без учета влияния переменных

без учета влияния переменных  – это коэффициент парной корреляции между остатками

– это коэффициент парной корреляции между остатками  и

и  :

:

. (5)

. (5)

Таким образом, коэффициент частной корреляции позволяет исключить влияние других факторов на взаимосвязь между рассматриваемыми переменными.

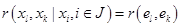

Например,  равен коэффициенту парной корреляции между остатками

равен коэффициенту парной корреляции между остатками  и

и  следующих регрессий:

следующих регрессий:

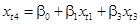

(6)

(6)

(7)

(7)

Последствия мультиколлинеарности

1) Большие стандартные ошибки затрудняют нахождение истинных значений определяемых величин и расширяют их интервальные оценки, ухудшая их точность.

2) Ухудшается качество прогноза.

3) Малые t -статистики коэффициентов могут привести к неоправданному выводу о их малой значимости, т.е. о слабом влиянии соответствующей объясняющей переменной на зависимую переменную.

4) Оценки коэффициентов и их стандартные ошибки становятся очень чувствительными к малейшим изменениям данных, т.е. они становятся неустойчивыми.

Методы устранения мультиколлинеарности

1) Исключение переменных из модели. Исключается из модели одна или несколько коррелированных объясняющих переменных. Например, можно последовательно исключать из модели объясняющие переменные с наименьшими незначащими t -статистиками коэффициентов регрессии (причем после каждого исключения из модели объясняющей переменной следует производить пересчет t -статистик для оставшихся объясняющих переменных).

2) Можно использовать описанный в предыдущей теме алгоритм оптимального отбора объясняющих переменных, основанный на использовании скорректированного коэффициента детерминации  .

.

3) Получение дополнительных данных или новой выборки

4) Изменение спецификации модели

5) Преобразование переменных.

Например, вместо переменной  можно включить в модель переменную

можно включить в модель переменную  .

.

Гетероскедастичность и автокорреляция остатков

Гетероскедастичность означает, что дисперсии  случайных отклонений

случайных отклонений  зависят от

зависят от  , т.е. нарушается гипотеза классической модели о постоянстве этих дисперсий.

, т.е. нарушается гипотеза классической модели о постоянстве этих дисперсий.

Автокорреляция остатков означает, что ковариации  не равны нулю при разных значениях

не равны нулю при разных значениях  и

и  .

.

Суть и причины гетероскедастичности

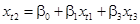

Гетероскедастичность означает, что  зависит от номера наблюдения

зависит от номера наблюдения  . Обычно эта зависимость возникает вследствие зависимости

. Обычно эта зависимость возникает вследствие зависимости  от

от  . Например, если

. Например, если  – уровень дохода семьи, а

– уровень дохода семьи, а  – ее потребление, естественно ожидать что для семей с высоким доходом разброс в их потреблении больше, чем для семей с низким доходом.

– ее потребление, естественно ожидать что для семей с высоким доходом разброс в их потреблении больше, чем для семей с низким доходом.

Проблема гетероскедастичности характерна для перекрестных данных и довольно редко встречается при рассмотрении временных рядов.

Последствия гетероскедастичности

1) Оценки коэффициентов регрессии, оставаясь линейными и несмещенными, перестают быть эффективными, что (в частности) ухудшает прогноз.

2) Дисперсии и ковариации оценок являются смещенными. Это приводит к искажению значений статистик Стъюдента и Фишера, что негативным образом сказывается на результаты проверки гипотез и построении интервальных оценок.

Обнаружение гетероскедастичности

Графический анализ остатков.

По оси абсцисс откладываются либо номера наблюдений  , либо значения объясняющей переменной

, либо значения объясняющей переменной  , либо линейная комбинация объясняющих переменных, либо прогнозные значения

, либо линейная комбинация объясняющих переменных, либо прогнозные значения  объясняемой переменной. По оси ординат – либо отклонения

объясняемой переменной. По оси ординат – либо отклонения  , либо их квадраты

, либо их квадраты  . При наличии гетероскедастичности можно визуально заметить зависимость значений

. При наличии гетероскедастичности можно визуально заметить зависимость значений  от

от  .

.

Тест Уайта (White)

Сначала к исходной модели применяется обычный метод наименьших квадратов и находятся остатки регрессии  ,

,  . Затем осуществляется регрессия квадратов этих остатков

. Затем осуществляется регрессия квадратов этих остатков  на все регрессоры

на все регрессоры  исходной модели, их квадраты

исходной модели, их квадраты  , попарные произведения

, попарные произведения  и константу (если ее не было в составе исходных регрессоров). Для этой регрессии находится коэффициент детерминации

и константу (если ее не было в составе исходных регрессоров). Для этой регрессии находится коэффициент детерминации  . Тогда при выполнении нулевой гипотезы о постоянстве дисперсий случайных отклонений величина:

. Тогда при выполнении нулевой гипотезы о постоянстве дисперсий случайных отклонений величина:

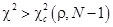

(8)

(8)

асимптотически (т.е. при большом количестве наблюдений  ) имеет распределение

) имеет распределение  , где

, где  – число регрессоров второй регрессии.

– число регрессоров второй регрессии.

Напомним, что распределение «хи квадрат» с  степенями свободы – это распределение следующей случайной величины:

степенями свободы – это распределение следующей случайной величины:

(9)

(9)

где  – независимые стандартные нормальные случайные величины.

– независимые стандартные нормальные случайные величины.

Следовательно, при выполнении нулевой гипотезы имеет место равенство:

, (10)

, (10)

где  –

–  -квантиль распределения «хи квадрат» с

-квантиль распределения «хи квадрат» с  степенями свободы.

степенями свободы.

В случае, если  нулевая гипотеза отвергается (и, следовательно, можно сделать вывод о наличии гетероскедастичности); если

нулевая гипотеза отвергается (и, следовательно, можно сделать вывод о наличии гетероскедастичности); если  , нет оснований отвергать нулевую гипотезу (и, она принимается).

, нет оснований отвергать нулевую гипотезу (и, она принимается).

Тест ранговой корреляции Спирмана

Этот тест применяется, когда есть предположение о прямой зависимости дисперсии ошибки от величины некоторой независимой переменной. Значения такой независимой переменной  и абсолютные величины отклонений

и абсолютные величины отклонений  ранжируются (упорядочиваются по величинам). Затем определяется коэффициент ранговой корреляции:

ранжируются (упорядочиваются по величинам). Затем определяется коэффициент ранговой корреляции:

, (11)

, (11)

где  – разность между рангами

– разность между рангами  и

и  . (Например, если при

. (Например, если при  значение

значение  является 25-м по величине среди всех наблюдений

является 25-м по величине среди всех наблюдений  , а

, а  является 32-м, то

является 32-м, то  .)

.)

Доказано, что если коэффициент корреляции  равен нулю, то статистика:

равен нулю, то статистика:

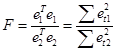

(12)

(12)

имеет распределение Стъюдента с числом степеней свободы  . Следовательно, если

. Следовательно, если

(13)

(13)

(где  двусторонняя квантиль распределения Стъюдента с

двусторонняя квантиль распределения Стъюдента с  степенями свободы при уровне значимости

степенями свободы при уровне значимости  ), то нулевая гипотеза о равенстве нулю коэффициента корреляции

), то нулевая гипотеза о равенстве нулю коэффициента корреляции  отклоняется, и, следовательно, можно сделать вывод о присутствии гетероскедастичности.

отклоняется, и, следовательно, можно сделать вывод о присутствии гетероскедастичности.

Тест Голфельда-Куандта (Goldfeld-Quandt)

Этот тест также применяется, когда есть предположение о прямой зависимости дисперсии ошибки от величины некоторой независимой переменной.

Нужно:

1) упорядочить данные по убыванию той независимой переменной, относительно которой есть подозрение на гетероскедастичность;

2) исключить  средних (в этом упорядочении) наблюдений (

средних (в этом упорядочении) наблюдений ( должно быть примерно равно четверти общего количества наблюдений);

должно быть примерно равно четверти общего количества наблюдений);

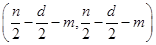

3) провести две независимые регрессии первых  наблюдений и последних

наблюдений и последних  наблюдений и построить соответствующие остатки

наблюдений и построить соответствующие остатки  и

и  ;

;

4) составить статистику  .

.

Если верна нулевая гипотеза (8) о постоянстве дисперсий случайных отклонений, то построенная статистика  имеет распределение Фишера с

имеет распределение Фишера с  степенями свободы.

степенями свободы.

В случае, если  нулевая гипотеза отвергается и, следовательно, можно сделать вывод о присутствии гетероскедастичности; если

нулевая гипотеза отвергается и, следовательно, можно сделать вывод о присутствии гетероскедастичности; если  , нет оснований отвергать нулевую гипотезу.

, нет оснований отвергать нулевую гипотезу.

Суть и причины автокорреляции

Автокорреляция остатков (отклонений) в подавляющем большинстве случаев встречается в регрессионном анализе при использовании данных временных рядов. В экономических задачах значительно чаще встречается положительная автокорреляция (т.е. когда  ), нежели отрицательная.

), нежели отрицательная.

Причины автокорреляции:

1) Ошибки спецификации. Неучет в модели какой-либо важной объясняющей переменной обычно приводит к системным отклонениям точек наблюден6ий от линии регрессии.

2) Инерция. Многие экономические показатели обладают определенной цикличностью. Экономические показатели реагируют на изменение экономических условий с запаздыванием (временным лагом).

3) Сглаживание данных. Часто данные по некоторому продолжительному временному периоду получают усреднением данных по составляющим его подынтервалам. Это может привести к определенному сглаживанию колебаний, которые имелись внутри рассматриваемого периода.

Последствия автокорреляции

3) Оценки коэффициентов регрессии, оставаясь линейными и несмещенными, перестают быть эффективными, что (в частности) ухудшает прогноз.

4) Дисперсии и ковариации оценок являются смещенными. Это приводит к искажению значений статистик Стъюдента и Фишера, что негативным образом сказывается на результаты проверки гипотез и построении интервальных оценок.

Обнаружение автокорреляции

Выводы о независимости (либо зависимости) случайных отклонений  делаются на основе их оценок

делаются на основе их оценок  (т.е. на основе остатков регрессии).

(т.е. на основе остатков регрессии).

Графический метод.

По оси абсцисс откладываются значения временного индекса  , по оси ординат – остатки

, по оси ординат – остатки  . В случае, когда точки

. В случае, когда точки  разбросаны вокруг оси абсцисс случайным образом можно сделать вывод об отсутствии автокорреляции, в противном случае – о ее наличии.

разбросаны вокруг оси абсцисс случайным образом можно сделать вывод об отсутствии автокорреляции, в противном случае – о ее наличии.

Тест Дарбина-Уотсона (Durbin-Watson)

Статистика Дарбина-Уотсона находится по формуле:

(14)

(14)

Можно показать, что при наличии в модели свободного члена:

(15)

(15)

где  – выборочный коэффициент корреляции между остатками

– выборочный коэффициент корреляции между остатками  и

и  .

.

В соответствии с соотношением (15):

, (16)

, (16)

причем близость значения DW к нулю означает близость коэффициента  к единице (т.е. положительную корреляцию остатков), близость DW к 2 означает, что

к единице (т.е. положительную корреляцию остатков), близость DW к 2 означает, что  (т.е. отсутствие автокорреляции), близость DW к 4 означает близость

(т.е. отсутствие автокорреляции), близость DW к 4 означает близость  к -1 (т.е. отрицательную автокорреляцию).

к -1 (т.е. отрицательную автокорреляцию).

Для более точного определения, какое значение статистики свидетельствует об отсутствии автокорреляции, а какое – об ее наличии (и ее виде), найдены критические точки распределения Дарбина-Уотсона:  (нижняя граница) и

(нижняя граница) и  (верхняя граница), зависящие от числа наблюдений

(верхняя граница), зависящие от числа наблюдений  , количества объясняющих переменных

, количества объясняющих переменных  и от уровня значимости

и от уровня значимости  . Значения

. Значения  и

и  (зависящие от

(зависящие от  ,

,  и

и  ) можно найти в таблицах.

) можно найти в таблицах.

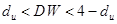

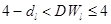

Выводы о наличии и характере автокорреляции делаются по следующему правилу:

1)  – существует положительная автокорреляция

– существует положительная автокорреляция

2)  – неопределенность (нельзя сделать вывод о наличии либо отсутствии автокорреляции)

– неопределенность (нельзя сделать вывод о наличии либо отсутствии автокорреляции)

3)  – автокорреляция отсутствует

– автокорреляция отсутствует

4)  – неопределенность (нельзя сделать вывод о наличии либо отсутствии автокорреляции)

– неопределенность (нельзя сделать вывод о наличии либо отсутствии автокорреляции)

5)  – существует отрицательная автокорреляция

– существует отрицательная автокорреляция

|

|

|

|

|

Дата добавления: 2014-12-17; Просмотров: 5982; Нарушение авторских прав?; Мы поможем в написании вашей работы!