КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Передача информации

|

|

|

|

Обмен информацией производится по каналам передачи информации. Каналы передачи информации могут использовать различные физические принципы. Так, при непосредственном общении людей информация передается с помощью звуковых волн, а при разговоре по телефону - с помощью электрических сигналов, которые распространяются по линиям связи. Компьютеры могут обмениваться информацией с использованием каналов связи различной физической природы: кабельных, оптоволоконных, радиоканалов и др.

Общая схема передачи информации включает в себя отправителя информации, канал передачи информации и получателя информации (рис. 4.1). Если производится двусторонний обмен информацией, то отправитель и получатель информации могут меняться ролями.

|

| Рис. 4.1. Канал обмена информацией |

Основной характеристикой каналов передачи информации является их пропускная способность (скорость передачи информации). Пропускная способность канала равна количеству информации, которое может передаваться по нему в единицу времени.Обычно пропускная способность измеряется в битах в секунду (бит/с) и кратных единицах Кбит/с и Мбит/с. Однако иногда в качестве единицы измерения используется байт в секунду (байт/с) и кратные ему единицы Кбайт/с и Мбайт/с.Соотношения между единицами пропускной способности канала передачи информации такие же, как между единицами измерения количества информации:

1 байт/с = 23 бит/с = 8 бит/с;

1 Кбит/с = 210 бит/с = 1024 бит/с;

1 Мбит/с = 210 Кбит/с = 1024 Кбит/с;

1 Гбит/с = 210 Мбит/с = 1024 Мбит/с.

3Под дискретизацией понимается преобразование непрерывных сообщений (сигналов) в дискретные. При этом используется дискретизация по времени и по уровню. Дискретизация по времени выполняется путем взятия отсчетов функции u(t) в определенные дискретные моменты времени. В результате непрерывная функция u(t) заменяется совокупностью мгновенных значений  Обычно моменты отсчетов выбираются на оси времени равномерно, т. е.

Обычно моменты отсчетов выбираются на оси времени равномерно, т. е.

Выбор интервала Δt производится на основании теоремы Котельникова. согласно которой функция с ограниченным спектром полностью определяется своими значениями, отсчитываемыми через

Дискретизация значений функции (уровня) носит название квантования. Операция квантования сводится к тому, что вместо данного мгновенного значения сообщения u(t) передаются ближайшие значения по установленной шкале дискретных уровней. Дискретные значения по шкале уровней чаще всего выбираются равномерно:  . При квантовании вносится погрешность (искажение), так как истинные значения функции заменяются округленными значениями

. При квантовании вносится погрешность (искажение), так как истинные значения функции заменяются округленными значениями  . Величина этой погрешности

. Величина этой погрешности  не превосходит половины шага квантования Δu и может быть сведена до допустимого значения. Погрешность Е является случайной функцией и проявляется на выходе как дополнительный шум ("шум квантования"), наложенный на передаваемое сообщение.

не превосходит половины шага квантования Δu и может быть сведена до допустимого значения. Погрешность Е является случайной функцией и проявляется на выходе как дополнительный шум ("шум квантования"), наложенный на передаваемое сообщение.

Дискретизация одновременно по времени и уровню позволяет непрерывное сообщение преобразовать в дискретное (аналоговый сигнал в цифровую форму), которое затем может быть закодировано и передано методами дискретной (цифровой) техники.

4 Объективность и субъективность информации. Понятие объективности информации является относительным. Это понятно, если учесть, что методы являются субъективными. Более объективной принято считать ту информацию, в которую методы вносят меньший субъективный элемент. Так, например, принято считать, что в результате наблюдения фотоснимка природного объекта или явления образуется более объективная информация, чем в результате наблюдения рисунка того же объекта, выполненного человеком. В ходе информационного процесса степень объективности информации всегда понижается. Это свойство учитывают, например, в правовых дисциплинах, где по-разному обрабатываются показания лиц, непосредственно наблюдавших события или получивших информацию косвенным путем (посредством умозаключений или со слов третьих лиц). В не меньшей степени объективность информации учитывают в исторических дисциплинах. Одни и те же события, зафиксированные в исторических документах разных стран и народов, выглядят совершенно по-разному. У историков имеются свои методы для тестирова ния объективности исторических данных и создания новых, более достоверных данных путем сопоставления, фильтрации и селекции исходных данных. Обратим внимание на то, что здесь речь идет не о повышении объективности данных, а о повышении их достоверности (это совсем другое свойство).

5 НЕПРЕРЫВНАЯ И ДИСКРЕТНАЯ ИНФОРМАЦИЯ

Чтобы сообщение было передано от источника к получателю, необходима некоторая материальная субстанция - носитель информации. Сообщение, передаваемое с помощью носителя, назовем сигналом. В общем случае сигнал - это изменяющийся во времени физический процесс. Такой процесс может содержать различные характеристики (например, при передаче электрических сигналов могут изменяться напряжение и сила тока). Та из характеристик, которая используется для представления сообщений, называется параметром сигнала.

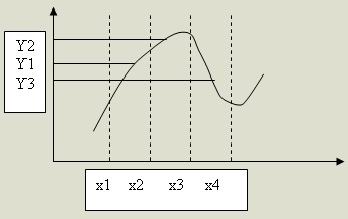

В случае, когда параметр сигнала принимает последовательное во времени конечное число значений (при этом все они могут быть пронумерованы), сигнал называется дискретным, а сообщение, передаваемое с помощью таких сигналов - дискретным сообщением. Информация, передаваемая источником, в этом случае также называется дискретной. Если же источник вырабатывает непрерыв-ное сообщение (соответственно параметр сигнала - непрерывная функция от времени), соответствующая информация называется непрерывной. Пример дискретного сообщения - процесс чтения книги, информация в которой представлена текстом, г.е. дискретной последовательностью отдельных значков (букв). Примером непрерывного сообщения служит человеческая речь, передаваемая модулированной звуковой волной; параметром сигнала в этом случае является давление, создаваемое той волной в точке нахождения приемника - человеческого уха. Непрерывное сообщение может быть представлено непрерывной функцией, заданной на некотором отрезке [а, б]. Непрерывное сообщение можно преобразовать в дискретное (такая процедура называется дискретизацией). Для того из бесконечного множества значений этой функции (параметра сигнала) выбирается их определенное число, которое приближенно может характеризовать остальные значения. Один из способов такого выбора состоит в следующем: область определения функции разбивается точками x1, x2,...xn на отрезки равной дины и на каждом из этих отрезков значение функции принимается постоянным и равным, например, среднему значению на этом отрезке; полу-ченная на этом этапе функция называется в математике ступенчатой. Следующий шаг - проецирование значений "ступенек" на ось значений функции (ось ординат). Полученная таким образом последовательность значений функции у1, у2,... yn является дискретным представлением непрерывной функции, точность которого можно неограниченно улучшать путем уменьшения длин отрезков разбиения области значений аргумента.

Процедура дискретизации непрерывного сообщения Ось значений функции можно разбить на отрезки с заданным шагом и отображать каждый из выделенных отрезков из области определения функции в соответствующий отрезок из множества значений. В итоге получим конечное множество чисел, определяемых, например, по середине или одной из границ таких отрезков. Таким образом, любое сообщение может быть представлено как дискретное, иначе говоря, последовательностью знаков некоторого алфавита. Возможность дискретизации непрерывного сигнала с любой желаемой точностью (для возрастания точности достаточно уменьшить шаг) принципиально важна с точки зрения информатики. Компьютер - цифровая машина, т.е. внутреннее представление информации в нем дискретно. Дискретизация входной информации (если она непрерывна) позволяет сделать ее пригодной для компьютерной обработки.

Существуют и другие вычислительные машины - аналоговые ЭВМ. Они используются обычно для решения задач специального характера и широкой публике практически не известны. Эти ЭВМ в принципе не нуждаются в дискретизации входной информации, так как ее внутреннее представление у них непрерывно. В этом случае все наоборот - если внешняя информация дискретна, то ее "перед употреблением" необходимо преобразовать в непрерывную.

6 Информация и энтропия

В рамках предлагаемого к включению в курс “Основы информатики” раздела “Информационные процессы в природе и обществе”, предлагаю поговорить об информации и энтропии. Теория информации как самостоятельная научная дисциплина была основана американским ученым К.Шенноном в конце 40-х годов 20-го века.Предложенная им теория основывалась на фундаментальном понятии количественной меры неопределенности – энтропии – и связанного с нею понятия – количества информации. На основе понятий энтропии и количества информации в теории информации введены важные характеристики сигналов и информационных систем:

- Скорость создания информации.

- Скорость передачи информации.

- Избыточность.

- Пропускная способность каналов связи.

Одним из самых замечательных результатов теории информации является доказательство, что при любых помехах и шумах можно обеспечить передачу информации без потерь. Первая теорема Шеннона гласит, что при скорости содания информации меньшей пропускной способности канала можно передавать информацию со сколь угодно малой вероятностью ошибок, несмотря на шумы.

Что же такое энтропия? Шеннон сформулировал энтропию как меру хаоса в противовес количеству информации как меры упорядоченности структур.

Рассмотрим некоторую сложную систему и проследим ее эволюцию. Пусть эта система представляет собой находящийся в сосуде газ, состоящий из огромного числа беспорядочно движущихся молекул. Мы не знаем точного положения и скорости в каждый момент времени каждой частицы газа, но нам известны макропараметры: давление, объем, температура и состав газа. Фактически мы должны рассчитать число способов, которыми можно осуществить внутренние перестройки в системе, чтобы наблюдатель не заметил изменений макросостояния системы. При этом предполагается неотличимость атомов друг от друга.

Если в системе, состоящей из одного атома, произошло его энергетическое возбуждение, нам это может стать известно по значению температуры. При этом возможно только одно распределение возбуждения в системе равному единице. Энтропия связана с распределением следующим образом: S=k ln W. В нашем случае W=1, а значит система обладает нулевой энтропией.

В системе из ста атомов, распределение возбуждения может быть осуществлено ста способами, т.е. W=100, ln100=4,61. Энтропия системы выросла и стала хаотичной, поскольку мы не знаем, где находится в каждый момент возбужденный атом.

Принято считать, что любая система стремится к состоянию равновесия, т. е. растет энтропия системы. Однако второе начало термодинамики (закон сохранения энтропии и информации) требует компенсировать рост энтропии. Информация и является средством компенсации.

7Вероятность — общенаучная и философская категория, обозначающая количественную степень возможности появления массовых случайных событий при фиксированных условиях наблюдения, характеризующую устойчивость их относительных частот. В логике — семантическая степень подтверждения гипотезы, основанная на свидетельствах, фактах и др. подтверждающих их данных. Такую Вероятность нередко называют «рациональной степенью веры» и противопоставляют фактической, субъективной, вере. Гносеология рассматривает Вероятность как меру превращения возможности в действительность в ситуациях неопределенности. Формальные свойства Вероятности впервые были определены в исчислении Вероятности, а впоследствии в наиболее точной форме выражены в аксиоматической теории, предложенной А.Н. Колмогоровым. Математическая теория Вероятности стала, той обшей основой, или нейтральным ядром, вокруг которой появились различные интерпретации Вероятности.

«Информация» в разговорном языке означает передаваемые сведения, знания; нечто осмысленное и как-то полезное получателю. Такое словоупотребление довольно верно́: informare с латыни — «научать». В настоящее время не существует единого определения термина информация. С точки зрения различных областей знания, данное понятие описывается своим специфическим набором признаков. Источники, средства хранения и передачи данных и информации одни и те же — это вызывает впечатление, что это слова синонимы, но различить их легко, если понимать, что информация — это структурированная (имеющая форму) часть «объёма» данных. Часто информацией называют любые данные или сведения, которые кого-либо интересуют, например сообщение о каких-либо событиях, о чьей-либо деятельности и т. п. «Информировать» в этом смысле означает «сообщить нечто, неизвестное раньше»....

|

|

|

|

|

Дата добавления: 2015-05-10; Просмотров: 1043; Нарушение авторских прав?; Мы поможем в написании вашей работы!