КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Сигмоидальдік нейрон

|

|

|

|

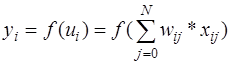

Сигмоидальдік нейрон МакКаллока - Питс моделінің құрылымы сияқты, бірақ белсендендіру функциясы үзіліссіз болады және сигмоидальді униполярлы немесе биполярлы функция түрінде көрсетіле алады (13.5-сурет).

13.5-сурет. Сигмоидальді нейрон моделі

Униполярлі функция көрсетілген формула арқылы беріледі:

, (13.10)

, (13.10)

онда биполярля функция (13.11) түрінде беріледі:

tanh(b × х)=(e bx-e- bx)/(e bx+e- bx)

. (13.11)

. (13.11)

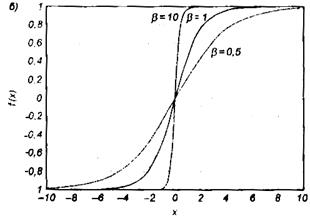

Бұл формулаларда b параметрін қолданушы таңдап алады. Оның мәні белсендендіру функциясының формуласына әсер етеді. 13.6-суретте b түрлі мәндеріндегі x айнымалысының сигмоидальді функциясының графигі көрсетілген, атап айтатыны 13.6, 6-суретте униполярлы, ал 13.6, б-суретте биполярля функциялар көрсетілген.

13.6-сурет. Сигмоидальді функциясының графигі: b түрлі мәндеріндегі а) униполярлы; б) биполярлының графиктері

b кіші шамаларында функция жеткілікті жатық (үзулеу). b®¥ болған уақытта функция персептронның белсендендіру функциясына жуық сатылы функцияға айналады. Көбінесе b=1 мәнін қолданады.

Сигмоидальдік функцияның маңызды қасиеті оның дифференциалданатындығы. Униполярлы функция үшін

, (13.12)

, (13.12)

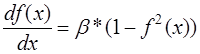

ондда биполярлы функция үшін

. (13.13)

. (13.13)

Бірінші жағдайдада, екінші жағдайдада х айнымалысына қатысты туындының өзгеру графигінің формасы қоңырау тәріздес болады, ал оның максимумы x=0 мәніне сәйкес келеді.

13.7-сурет. х айнымалысына қатысты туындының өзгеру графигі

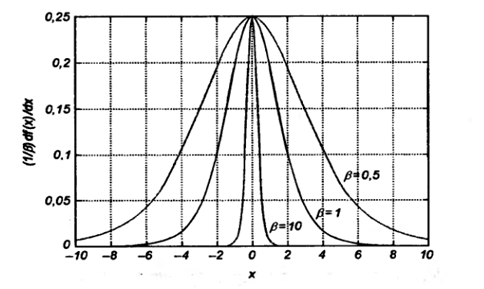

Сигмоидальдік нейрон, көбінесе мақсатты функциясын минимизациялау қағидасы бойынша мұғаліммен бірге оқытылады, ал мақсатты функция болса і-ші нейронның бірлік оқыту кортежі үшін төменде көрсетілгендей анықталады:

, (13.14)

, (13.14)

мұнда,

. (13.15)

. (13.15)

функциясы сигмоидальді, х- [x0, x1,…, xN] кіріс векторы, поляризация бар болса, оның мәні x0=1, ал жоқ болғанда x0=0 тең болады, ал di – оған сәйкес і-ші нейронның шығысында күтілетін мән. Үзіліссіз белсендендіру функциясын қолдану оқыту кезінде градиенттік әдістерді пайдалануға мүмкіндік береді.

функциясы сигмоидальді, х- [x0, x1,…, xN] кіріс векторы, поляризация бар болса, оның мәні x0=1, ал жоқ болғанда x0=0 тең болады, ал di – оған сәйкес і-ші нейронның шығысында күтілетін мән. Үзіліссіз белсендендіру функциясын қолдану оқыту кезінде градиенттік әдістерді пайдалануға мүмкіндік береді.

Ең жылдам түсу әдісін жүзеге асыру оңай, ал бұл әдіске сәйкес w=[wio,wi1,…,win]T үлес векторын нақтылау мақсатты функцияның теріс градиентінің бағытында жүреді. Егер функция көрсетілген өрнек арқылы анықталған болса,

E= (yi-di)2/2

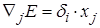

градиенттің j-ші құраушысының түрі

(13.16)

(13.16)

Егер (13.17) көрсетілген белгілеуді енгізсек:

(13.17)

(13.17)

Онда градиенттің j-ші құраушысын (13.18) төмендегі түрде анықтайтын өрнек алуға болады:

(13.18)

(13.18)

Үлес коэффициенттерінің мәндеріде дтскреттік тәсілменде нақтылауға болады:

, (13.19)

, (13.19)

мұнда,  – мәнін (0,1) интервалынан эмпирикалық таңдайтын немесе (13.20) айырма теңдеуді шешу арқылы табатын оқыту коэффициенті

– мәнін (0,1) интервалынан эмпирикалық таңдайтын немесе (13.20) айырма теңдеуді шешу арқылы табатын оқыту коэффициенті

, (13.20)

, (13.20)

Мұнда m алдыңғы теңдеудегі  -дің мәні сияқты рөл атқарады. Соңғы аталған екі теңдеу нейронды оқыту алгоримін анықтайды. Оқытудың тиімділігіне оқыту коэффициентін таңдап алу үлкен әсер етеді. Қазіргі уақытта бар қосымшаларда оның мәні константамен беріледі немесе айнымалы шама болады, ал оның мәні болса оқыту барысында бейімделу тәсілімен өзгереді, я болмаса бағытталған минимизациялау қағидасы бойынша әр қадамда таңдап алынады.

-дің мәні сияқты рөл атқарады. Соңғы аталған екі теңдеу нейронды оқыту алгоримін анықтайды. Оқытудың тиімділігіне оқыту коэффициентін таңдап алу үлкен әсер етеді. Қазіргі уақытта бар қосымшаларда оның мәні константамен беріледі немесе айнымалы шама болады, ал оның мәні болса оқыту барысында бейімделу тәсілімен өзгереді, я болмаса бағытталған минимизациялау қағидасы бойынша әр қадамда таңдап алынады.

Оқыту коэффициенті әр қадамда бір айнымалылы мақсатты функцияны осы мақсатты функцияның мәні ең жылдам азаятын бағытта минимизациялау арқылы таңдалынатын бағытталған минимизациялау әдісі тиімдірек, бірақ бір мезетте әрі көп еңбекті қажет ететін әдіс болып саналады.

Нейронды оқыту үшін градиенттік тәсілді пайдалану тек локальді минимумға ғана қол жеткізуге кепілдік беретінін анықтап айта кеткен жөн. Полимодальді мақсатты функция болған жағдайда табылған локальді минимум ауқымды (глобальді) минимумнан әжептәуір алшақ болуы мүмкін. Ең жылдам түсу әдісінің қарапайым алгоритмін қолданғанда локальді минимум аумағынан шығу мүмкін емес. Мезет немесе шашып тастаумен оқыту нәтижелі болуы мүмкін. Бұл әдісте үлестерді нақтылау барысы тек қана функция градиенті туралы ақпаратпен ғана емес, сонымен бірге үлестердің нақты өзгеру трендіменде анықталады.

Оқытудың бұл сияқты тәсілі үлестердің өсімшесінің мәнін анықтайтын келесі математикалық өрнекпен берілуі мүмкін:

(13.21)

(13.21)

Мұның бірінші мүшесі қарапайым ең жылдам түсу әдісіне сәйкес келеді, ал мезет деп аталатын екінші мүшесі үлестің соңғы өзгерісін көрсетеді және градиенттің нақты мәніне тәуелді болмайды. a мезет коэффициентінің мәні 0<a<1 интервалынан таңдалынып алынады. Мезеттің үлестерді нақтылауға тигізетін әсері a мәні өскен сайын арта түсетініне назар аударған жөн. Негізінен бұл сияқты әсер локальді минимумның тікелей жуықтығында орын алады, ал бұл уақытта градиенттің мәні нөлге ұмтылады. Бұл сияқты жағдайда мәндердің өсуіне және локальді минимум аумағының шегінен шығуға әкелетін үлестердің өзгерістері болуы мүмкін.

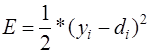

13.8-сурет – Мақсатты функция

Графикте көрсетілген нүктелер оқытудың әрбір қадамында алынған мақсатты функцияның мәніне сәйкес келеді. Р1 локальді минимумы мезеттің әрекетінің арқасындатастап кетілді. Бұл Р2 нүктесінде yi нақты мәнді di күтілетін мәнге жуықтау тұрғысынан алғанда көбірек келетін мақсатты функцияның кішірек мәні жаңа минимумды анықтауға мүмкіндік берді. Оқыту барысында мезет көрсеткіші үстемдік етпеу керек, себебі бұл алгоритмнің тұрақсыздығына (жинақсыздығына) әкеледі. Оқыту барысында қателіктің мүкін болатын шектен, мысалы 5%, асуын болдырмас үшін еi қателігінің мәні қадағаланып отырады. Егер еi(t+1)<1.05*еi(t) болса, онда кезекті қадам орынды және үлестерді нақтылау жүргізіледі. Ал егер еi(t+1)=1.05*еi(t) болса, онда Dwij=0 деп алынып, өзгерістер ескерілмейді және (13.17) өрнектегі градиенттік құраушы мезет құрамына үстемділік етеді.

|

|

|

|

|

Дата добавления: 2015-06-04; Просмотров: 773; Нарушение авторских прав?; Мы поможем в написании вашей работы!