КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Понятие энтропии

|

|

|

|

Лекция 2.

(самостоятельно)

Как уже было отмечено, информация и энергия имеют весьма близкую аналогию, что заметил еще основоположник теории информации Клод Шеннон. И рассмотрим еще одну аналогию между информацией и энергией. Согласно второму закону термодинамики (закон Больцмана) для замкнутого пространства имеем

2.1.

2.1.

где N – общее количество молекул в данном объеме пространства; ni - количество молекул имеющих скорости (а следовательно энергию)

vi + Dv; ni/N - частоты или вероятности того, что молекулы имеют скорость vi + Dv с вероятностью  и тогда:

и тогда:

или

или  2.2.

2.2.

Что и сделал К. Шенон еще в 1948г. выведя формулу для энтропии информации.

Энтропия ансамбля. Ансамблем называется полная группа событий,

или, иначе, поле несовместных событий с известным распре-

делением вероятностей, составляющих в сумме единицу.

Здесь имеется ввиду конечное множество событий и, следовательно, дискретная система состояний, значений, положений и т. д.

Энтропия ансамбля есть количественная мера его не-

определенности, а, следовательно, и информативности.

В статистической теории информации (теория связи),

предложенной Шенноном в 1948г., энтропия количественно

выражается как средняя функция множества вероятностей

каждого из возможных исходов опыта.

Действительно, пусть для какого-то опыта имеется N возможных исходов, из них имеется k – разных и i–ый исход повторяется ni раз и вносит информацию Ii, Тогда средняя информация, доставляемая одним опытом, определится:

Iср =  2.3.

2.3.

Или перейдя к логарифмам (выразив в битах), т.к. Ii = - log2pi имеем:

Iср =  2.4.

2.4.

Или заменив ni/N = pi, получим

H = Iср = - 2.5.

2.5.

Энтропия может быть определена также как среднее количество информации, приходящееся на одно сообщение или математическое ожидание количества информации I для измеряемой величины.

H(x) = M[I(x)] = - 2.12.

2.12.

Энтропия в функции вероятности исходов H(p), где p = {p1, р2, …, рk} – вектор вероятности исходов, должна удовлетворять следующим требованиям:

1) Функция H(p) должна быть непрерывна на интервале 0 £ pi ³ 1; т.е. при малых изменениях p величина H меняется мало;

2) Функция H(p) должна быть симметричной относительно аргумента p, т.е. не изменяется при любой перемене мест аргументов рi;

3) H(p1, p2, …, pk-1, q1, q2) = H(p1, p2, …, pk) + pkH(q1/pk, q2/pk);

Т.е. если событие xi состоит из двух событий xi’ и xi’’ с вероятностями q1 и q2, q1 + q2 = pi, то общая энтропия будет равна сумме энтропий – неразветвленной и разветвленной части с весом p при условных вероятностях q1/pk и q2/pk.

Кроме того, энтропия H характеризуется следующими свойствами:

1. Энтропия всегда неотрицательна, т.к. значения вероятностей выражаются дробными величинами, а их логарифмы – отрицательными величинами, так что энтропия в итоге неотрицательна. (log2pi = -(-a) – неотрицательная величина);

2. Энтропия равна нулю в том и только в том крайнем случае, когда одно событие равно единице, а все остальные – нулю. Это тот случай, когда об опыте, событии все заранее известно и результат не приносит никакой новой информации.

3. Энтропия имеет наибольшее значение в том случае, когда все вероятности равны между собой, в этом случае:

p1 = p2 = p3 = … = pk = 1/k 2.13.

и энтропия в этом случае

H = - log2 1/k = log2k 2.14.

Логарифмическая и статическая мера информации совпадает с аддитивной логарифмической мерой Хартли.

I` = log2h 2.15.

Действительно рассмотрим одно предметное событие, которое имеет 2 исхода. Энтропия такого события (для двух неравновероятных событий одного элемента h = 2) равна

H = - (p1log2p1 + p2log2p2) 2.16.

Она меньше информационной ёмкости одной двоичной единицы, действительно:

Она меньше информационной ёмкости одной двоичной единицы, действительно:

А. Пусть имеем равновероятные состояния, тогда -

p1 = p2 = 0,5 или p1 + p2 = 1;

H=-(0.5log20.5+0.5log20.5)= - [0.5(-1) + 0.5(-1)] = 1 бит.

Б. Неравновероятные состояния –

p1 = 0,9 p2 = 0,1 p1 + p2 = 1;

H = -(0.9log20.9+0.1log20.1)= - [0.9(-0,1520)+0.1(-3,3219)]= =0,46 бит

В. Детерминированное состояние –

p1 = 1 p2 = 0 p1 + p2 = 1;

H = - (1log21+ 0log20) = 0 бит

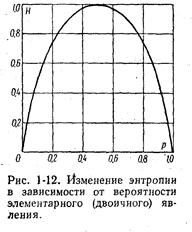

Изменение энтропии H в зависимости от вероятности p однопредметного события представлена на рис. 1-12. Максимум H = 1 достигается при p = 0.5, когда два состояния равновероятны. При вероятностях p = 0 или p = 1, что соответствует полной невозможности или полной достоверности события, энтропия равна нулю.

2.2. Энтропия объединения ( самостоятельно Темников Ф.Е., В.А. Афонин, В.И. Дмитриев. Технические основы информационной техники ).

Объединением называется совокупность двух и более взаимозависимых ансамблей дискретных случайных переменных.

Рассмотрим объединение, состоящее из двух ансамблей Х

и У, например из двух дискретных измеряемых величин,

связанных между собой вероятностными зависимостями.

Схема ансамбля Х

x1 x2 ... xi ... x n;

р(x1,) р(х2)... р(хi)... p(хn).

Схема ансамбля Y:

y1 y2 …. yi .... yт,

p (y1) p (y2)... p (yi)... p (ym)

Схема объединения Х и Y;

| x1 | x2 | xn | |

| y1 y2 ..... yт | p(x1,y1) p(x1,y2) ................ p (x1, yт) | p(x2 y1) p (x2, y2) ................ p (x2, ym) | p (xn, y1); p (xn, y2); ........... p (xn, ym) |

Вероятность совпадения (произведения) совместных зависимых событий Х и Y равна произведению безусловной вероятности р(х) или р(у) на условные вероятности р(у | х) или р(х|у).

Таким образом, имеем:

р(х, у) = р(х) р(у|х) = р(у) р(х|у).

Отсюда находятся условные вероятности

р(у|х) = p(x,y)/р (х) (2-17)

р(х|у) = p(у,x)/р(у) (2-18)

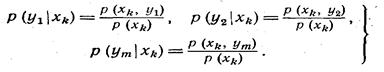

в зависимости от того, какое событие является причиной, а какое — следствием. В нашем случае дискретных переменных Х и Y, частные

условные вероятности могут быть записаны для х = xk как:

2-19

С объединением связаны понятия безусловной, условной, совместной и взаимной энтропии (табл. 1-4). Их иногда

называют также зависимой, коррелированной и взаимной

энтропией, или т р а н с ф о р м а ц и е й. Введенные понятия можно проиллюстрировать примером

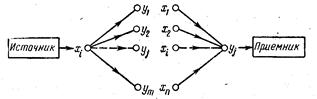

передачи информации по каналу связи по схеме рис. 1-3. Последовательность символов х1, х2,..., хi,..., хn соз-

даваемая источником, может претерпевать искажения по

пути к приемнику.

Энтропия объединения. Символ хi может быть принят не только как однозначно

Энтропия объединения. Символ хi может быть принят не только как однозначно

ему соответствующий символ уj но и как любой из возмож-

ных символов у1, у2,..., уj,..., уm с соответствующими веро-

ятностями. Рис.1-3. Предача информации по

каналу связи.

Различные виды энтропии в данной схеме имеют, следующий смысл:

Н(Х) — безусловная энтропия источника, или среднее количество информации на символ,

выдаваемое источником;

Таблица 1-4

Таблица 1-4

Н(У) — безусловная энтропия прием-

ника, или среднее количество информации на символ,

получаемое приемником;

Н (Х, Y) — взаимная энтропия системы пере-

дачи-приема в целом, или средняя информация на пару

(переданного и принятого) символов;

Н(У|Х) — условная энтропия У относи-

тельно Х, или мера количества информации в приемнике,

когда известно, что передается Х;

Н(Х|Y) — условная энтропия Х относитель-

но У, или мера количества информации об источнике, когда

известно, что принимается Y.

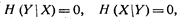

Если в системе нет потерь и искажений, то условные

Если в системе нет потерь и искажений, то условные

энтропии равны нулю

а количество взаимной информации равно энтропии либо

источника, либо приемника

I(X,Y) = H(X,Y) = H(X) = H(Y)

На основании статистических данных могут быть установлены вероятности событий у1, у2,..., уm при условии,

что имели место события хi, а именно p(у1|хi), р (у2|хi),

..., р (уm|хi). Тогда частная энтропия будет равна:

(2-20)

(2-20)

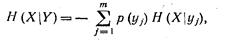

Далее нужно подсчитать среднее значение H(Y|Хi)

для всех переданных символов хi. Это будет условная энтропия канала

(1-19)

или в развернутом виде

(1-20).

(1-20).

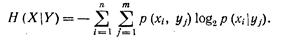

Аналогично получается условная энтропия H(Х|Y),

учитывающая условные вероятности

(1-21)

(1-21)

или

(1-22)

(1-22)

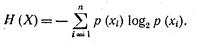

Безусловная энтропия ансамбля Х

(1-23)

(1-23)

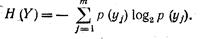

Безусловная энтропия ансамбля У

(1-24)

(1-24)

|

|

|

|

Дата добавления: 2014-01-06; Просмотров: 1922; Нарушение авторских прав?; Мы поможем в написании вашей работы!