КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Алгоритм обучения ANFIS

|

|

|

|

Если параметры предпосылок фиксированы, то выход всей сети является линейной комбинацией параметров заключений. В символах этот выход может быть записан в виде

(7)

(7)

(8)

(8)

(9)

(9)

и он представляет линейную комбинацию параметров заключений  (i=1,2; j=0,1,2). Гибридный алгоритм настраивает параметры заключений

(i=1,2; j=0,1,2). Гибридный алгоритм настраивает параметры заключений  при прямом распространении сигнала и параметры предпосылок

при прямом распространении сигнала и параметры предпосылок

{ ai, bi, ci } при обратном распространении сигнала. При прямом распространении сеть передает входные сигналы в прямом направлении до слоя 4, в котором параметры заключений идентифицируются с помощью метода наименьших квадратов или путем псевдоинверсии матрицы. При обратном распространении сигнал ошибки передается в обратном направлении, и параметры предпосылок обновляются с помощью метода обратного распространения ошибки.

В связи с тем, что обновления параметров предпосылок и заключений происходят раздельно, в гибридных обучающих алгоритмах можно ускорить процесс вычислений путем использования различных вариантов

Рис. 2

градиентных методов или других методах оптимизации для настройки параметров предпосылок.

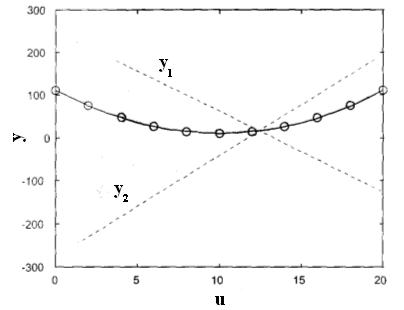

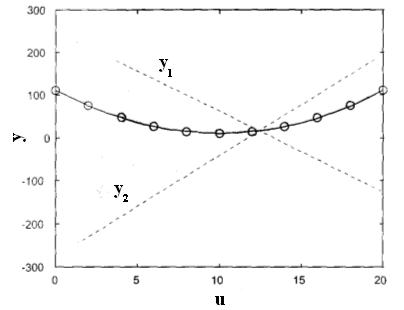

Пример (ANFIS). Посмотрим, как сеть может аппроксимировать нелинейную функцию. Рис. 2 показывает изображение множества данных и результирующую интерполирующую кривую. Одиннадцать точек данных (кружки на рисунке) были предъявлены сети ANFIS. В начале были

Рис. 2

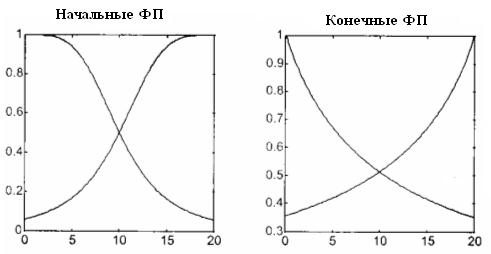

выбраны параметры двух гауссовских функций принадлежности (рис. 3, слева). Они занимали весь универсум входа с 50 процентным перекрытием между собой. Другим выбором начального шага проектирования был выбор числа правил, т. е. двух правил. В результате обучения эти правила приняли следующий вид,

Если u есть A1 то y1 = -18,75 u + 249,1, (10)

Если u есть A2 то y2 = 23,55 u – 276,7. (11)

Правой стороне правил соответствуют две прямые линии, также нарисованные на рис. 2, одна из которых имеет положительный, а другая отрицательный наклон. Интерполирующая кривая является результатом нелинейной комбинации этих двух прямых. Вес значений прямых линий в каждой точке интерполяционной кривой определяется видом функций принадлежности входа (рис. 3, справа), который они приняли после обучения.

Рис. 3

Одиннадцать точек данных были предъявлены сети 100 раз и каждый раз алгоритм обучения ANFIS обновлял параметры предпосылок, что определило форму и положение двух функций принадлежности, и параметры заключений, что в свою очередь определило наклон и постоянные двух прямых линий, описываемых уравнениями в правой части правил. Начальные значения коэффициентов для этих уравнений были взяты равными нулю.

|

|

|

|

Дата добавления: 2014-01-07; Просмотров: 1216; Нарушение авторских прав?; Мы поможем в написании вашей работы!