КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Количество информации

|

|

|

|

Может вызвать замешательство вопрос, - в каком из двух сообщений содержится больше информации, например: «Выпал орел» (при бросании монеты), или «Выпала тройка» (при бросании игрального кубика). На этот вопрос дает ответ теория информации. Теория информации позволяет дать количественную оценку информации. Это делает возможным сравнить информативность передаваемых сообщений о том или ином состоянии системы (источнике сообщений).

Передача информации возможна, если система (источник сообщений) находится в нескольких состояниях (случайных). Рассмотрим простейший случай, когда число возможных состояний системы n и все возможные состояния равновероятны. В этом случае для количественной оценки информации, содержащейся в сообщении о состоянии системы, используется формула, предложенная в 1928 году американским инженером Хартли [24].

I(Xi) = Log k [1/р(Xi)] = Log k n, где:

I(Xi} – количество информации в сообщении Xi;

k – основание логарифма;

n – число возможных состояний системы;

р(Xi) = 1/n – вероятность появления равновероятного сообщения Xi.

В теории информации используются двоичные логарифмы, т.е. k = 2. В этом случае, согласно формуле Хартли, единица количества информации будет содержаться в сообщении о состоянии системы, находящейся в одной из двух возможных равновероятных состояниях. В этом случае р(Xi) = ½,

I(Xi) = Log 2 = 1.

Эта единица получила название бит и используется для оценки количества информации. Если подкинуть монету и сообщить: «Выпал орел», то это сообщение будет содержать 1 бит информации. Вероятность выпадения орла и решки одинакова и равна ½.

Если подкинуть игральный кубик и сообщить, что выпала, например, «тройка», то в этом сообщении будет содержаться следующее количество информации:

р(Xi) = 1/6, I(Xi) = Log 6 =2,585 бит.

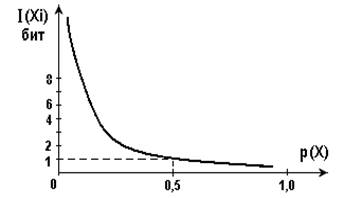

Вышеприведенная формула показывает, что чем меньше вероятность появления сообщения, тем большее количество информации оно содержит. На рис. 1.1 приведен примерный вид зависимости количества информации содержащегося в сообщении от вероятности появления этого сообщения.

|

Рис.1.1. Зависимость количества информации от вероятности появлении сообщения.

При вероятности появления сообщения равном единице, количество информации равно нулю. Таким образом, достоверное сообщение не несёт информации.

|

|

|

|

|

Дата добавления: 2014-10-15; Просмотров: 499; Нарушение авторских прав?; Мы поможем в написании вашей работы!