КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Первая итерация

|

|

|

|

Задание 1. Проектирование однослойной искусственной нейронной сети. Общие сведения.

6.2.1.Простой персептрон. Обучение простого персептрона.

НЭ, описываемый функцией

(11)

(11)

где Н(•) - единичная ступенчатая функция Хевисайда, называется простым персептроном.

В качестве функции преобразования персептрона может использоваться также знаковая функция sgn(•). В этом случае входные и выходные сигналы персептрона будут биполярными.

Задача обучения персептрона заключается в поиске такого вектора ве-сов WT= (w1,w2,...,wm) и порогового значения θ, при которых будет обеспе-чиваться совпадение желаемой  и действительной реакции персептрона

и действительной реакции персептрона  на заданный входной вектор

на заданный входной вектор  . Если

. Если

, (12)

, (12)

то выходной сигнал НЭ в силу использования в качестве функции преобразо-вания функции Хевисайда будет равен +1. Это означает, что входной вектор  принадлежит классу, на который настроен НЭ. В ином случае входной вектор не принадлежит этому классу. При этом сетевая функция НЭ

принадлежит классу, на который настроен НЭ. В ином случае входной вектор не принадлежит этому классу. При этом сетевая функция НЭ

играет роль дискриминантной функций, позволяющей установить принад-лежность вектора  определенному классу.

определенному классу.

Идея обучения персептрона состоит в следующем. На вход персептро-на подаются последовательно входные векторы  . Одновременно с этим выходная реакция персептрона

. Одновременно с этим выходная реакция персептрона  сравнивается с желаемой реакцией

сравнивается с желаемой реакцией  . Если указанные реакции совпадают, то никаких действий не предпри-нимают. Если

. Если указанные реакции совпадают, то никаких действий не предпри-нимают. Если  ≠

≠  , то вектор весов персептрона

, то вектор весов персептрона  изменяется на величину

изменяется на величину  . Адаптация весов выполняется с помощью правила

. Адаптация весов выполняется с помощью правила

(13)

(13)

где η - коэффициент обучения, η > 0. Если обозначить ошибку обуче-ния через  , т.е.

, т.е.  =

=  -

-  , то правило обучения можно перепи-сать в виде

, то правило обучения можно перепи-сать в виде

(14)

(14)

Таким образом, если  =0, то вектор весов не меняется. Если

=0, то вектор весов не меняется. Если  >0, то вектор весов

>0, то вектор весов  меняется в направлении вектора

меняется в направлении вектора  .

.

Для простого персептрона в силу того, что в качестве функции преоб-разования используется функция Хевисайда, значение  может прини-мать только значения +1 (если на входе нейрона присутствует сигнал, на который “настроен” нейрон) или 0 (если сигнал на входе не соответствует сигналу настройки). Очевидно, что и желаемое значение реакции нейрона

может прини-мать только значения +1 (если на входе нейрона присутствует сигнал, на который “настроен” нейрон) или 0 (если сигнал на входе не соответствует сигналу настройки). Очевидно, что и желаемое значение реакции нейрона  будет равно +1, если на входе нейрона присутствует сигнал, на который “настроен” нейрон, и 0 в противном случае. Значение же выходной реакции нейрона будет зависеть от значения и знака аргумента функции преобразо-вания (функции Хевисайда), то есть от значения величины сетевой функции

будет равно +1, если на входе нейрона присутствует сигнал, на который “настроен” нейрон, и 0 в противном случае. Значение же выходной реакции нейрона будет зависеть от значения и знака аргумента функции преобразо-вания (функции Хевисайда), то есть от значения величины сетевой функции  . В соответствии с этим реакция нейрона на входное воздействие будет полностью определяться значением сетевой функ-цией. Поэтому в качестве желаемой реакции можно принять желаемое зна-чение сетевой функции, которое при входном сигнале, на который “настро-ен” нейрон на входной сигнал будет больше или равно 0, то есть

. В соответствии с этим реакция нейрона на входное воздействие будет полностью определяться значением сетевой функ-цией. Поэтому в качестве желаемой реакции можно принять желаемое зна-чение сетевой функции, которое при входном сигнале, на который “настро-ен” нейрон на входной сигнал будет больше или равно 0, то есть

. (15)

. (15)

Если добавить к обеим частям неравенства θ, выражение (15) преобра-зуется к виду

. (16)

. (16)

Полученное выражение показывает, что при данном подходе к опреде-лению значения желаемой реакции её значение должно быть больше θ, то есть  .

.

С учетом этого адаптация весов выполняется с помощью правила

(17)

(17)

где  - вектор изменения весов, Х(μ) – μ -тый вектор входного сигнала.

- вектор изменения весов, Х(μ) – μ -тый вектор входного сигнала.

Если обозначить  , то правило обучения можно переписать в виде

, то правило обучения можно переписать в виде

(18)

(18)

6.2.2. Однослойная ИНС. Обучение искусственной нейронной сети

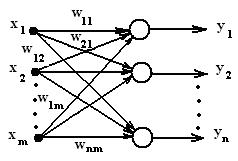

Распространим правило обучения персептрона на однослойную ИНС с прямыми связями и функцией Хевисайда в качестве функции преобразова-ния. Использование такой сети целесообразно для решения задачи распозна-вания n различных входных векторов. Пусть входной вектор сигнала имеет размерность m, а размерность выходного вектора при данной постановке задачи соответствует числу распознаваемых сигналов – n (рис. 6).

Рис. 6

При этом каждый i-тый нейрон сети соответствует модели, представ-ленной на рис.1.

Так как на вход нейронной сети может поступать любой из распозна-ваемых векторных сигналов, а также и сигналы, не подлежащие распознава-нию, то для любого нейрона необходимо обеспечить такой выбор вектора весов, при котором бы на его выходе появлялся единичный сигнал при появ-лении на его входе сигнала, на который он настроен (“полезный” для данного нейрона сигнал), и нулевой сигнал при появлении на его входе сигнала не соответствующего сигналу настройки (“мешающий” для данного нейрона сигнал). Это приводит к тому, что желаемые реакции каждого из нейронов сети должны быть разными в зависимости от входного сигнала.

В связи с этим задача обучения однослойной сети заключается в поиске таких векторов весов Wi= (wi1,wi2,...,wim) и порогового значения θi, при ко-торых будет обеспечиваться совпадение желаемой  и действительной реакции персептрона

и действительной реакции персептрона  на соответствующий входной вектор

на соответствующий входной вектор  ,то есть при наличии на входе сети сигнала, для которого реакция i-того нейро-на должна быть единичной, необходимо выполнение условия

,то есть при наличии на входе сети сигнала, для которого реакция i-того нейро-на должна быть единичной, необходимо выполнение условия

t´iжел пол (μ) =netiжел пол(μ)  , (19)

, (19)

в противном случае

t´iжел меш (μ) =netiжел меш(μ)  , (20)

, (20)

или по аналогии с предыдущим в первом случае должно выполняться соотношение

t´´iжел пол (μ) =net´iжел пол(μ)  , (21)

, (21)

а во втором -

t´´iжел меш (μ) =net´iжел меш(μ)  , (22)

, (22)

С учетом этого и выражения (17) пошаговая адаптация весов каждого нейрона выполняется с помощью правила

(23)

(23)

где  - ошибка обучения i-того нейрона, (24)

- ошибка обучения i-того нейрона, (24)

t´´i (μ)= t´´iжел пол (μ) при наличии на входе i-того нейрона полез-ного сигнала и

t´´i (μ)= t´´iжел меш (μ) при поступлении на вход i-того нейрона ме-шающего сигнала,

net´i(μ)=  при наличии на входе i-того нейрона полезного сигнала и

при наличии на входе i-того нейрона полезного сигнала и

net´i(μ)=  при поступлении на вход i-того ней-рона мешающего сигнала,

при поступлении на вход i-того ней-рона мешающего сигнала,

- текущие значения компонентов i-того весового вектора, по-лученные на предыдущем шаге

- текущие значения компонентов i-того весового вектора, по-лученные на предыдущем шаге

6.2.3. Проектирование однослойной искусственной нейронной сети

Ход проектирования однослойной искусственной нейронной сети про-изводится в соответствии со следующими этапами:

1. Проводится анализ задания на проектирование. Выполняется коди-рование (при необходимости) входной информации. Определяется размер-ность входного вектора и необходимое для решения задачи распознавания число нейронов.

2. Разрабатывается структурная схема нейронной сети. Осуществляется закрепление каждого из нейронов за распознаваемым образом.

3. Выбирается правило расчета весовых коэффициентов.

4. Выбирается некоторый i-тый нейрон и образ (сигнал), для распозна-вания которого предназначается этот нейронный элемент. Определяются па-раметры, необходимые для расчета вектора весовых коэффициентов:

- коэффициент обучения выбранного нейрона. При этом необходи-мо учитывать, что большое значение коэффициента обучения может привес-ти к постоянной неустойчивости процесса обучения, а малые значения при-водят к медленной сходимости решения. Поэтому в качестве h обычно вы-бирается число меньше 1, но не очень маленькое, например, 0,6, и оно может постепенно уменьшаться в процессе обучения.

- пороговое значение θi. Для определенности рекомендуется выби-рать значение, равное числу единиц в сигнале, распознаваемом этим нейро-ном.

- величины t´´iжел пол (μ) и t´´iжел меш (μ) как θi + ∆ в первом случае и θi -∆ во втором случае. Величину ∆ рекомендуется выбирать мень-ше величины θi, равной, например, 1.

- так как процедура является итерационной и обеспечивает посте-пенное пошаговое приближение к желаемому результату (определению век-тора весовых коэффициентов) для сокращения времени обучения задаются максимально допустимые значения ошибок обучения δmax пол и δmax меш, которые должны быть значительно меньше величины ∆.

5. Осуществляют расчет вектора весовых коэффициентов выбранного нейронного элемента.

5.1. Задают начальное значение вектора весовых коэффициентов (ком-понент вектора) выбранного нейрона. Как правило на первом шаге значени-ям компонент весового вектора присваивают небольшие случайные значения в пределах от 0 до 1. (Так как в процессе обучения начальные значения кор-ректируются, то эти начальные значения могут быть выбраны одинаковыми для всех нейронов.)

5.2. На вход сети подается сигнал, характеризующий образ, для распоз-навания которого служит выбранный нейронный элемент.

5.3. С учетом заданного начального значения весового вектора для этого сигнала определяется сетевая функция

net´i(μ)=  ,

,

где в качестве текущих значений составляющих весового вектора

выбираются их начальные значения.

5.4. Определяется ошибка обучения в соответствии с (24).

5.5. Полученное значение ошибки обучения сравнивается с максималь-но допустимой ошибкой δmax пол. Если  δmax пол, то коррекция на-чальных значений составляющих вектора весовых коэффициентов не про-изводится и текущему значению вектора весовых коэффициентов присваи-вается начальное значение, то есть

δmax пол, то коррекция на-чальных значений составляющих вектора весовых коэффициентов не про-изводится и текущему значению вектора весовых коэффициентов присваи-вается начальное значение, то есть  . Если

. Если  δmax пол, то производится первая коррекция весового вектора в соответствии с выра-жением

δmax пол, то производится первая коррекция весового вектора в соответствии с выра-жением

,

,

где  - значение вектора весовых коэффициентов после первой коррек-ции,

- значение вектора весовых коэффициентов после первой коррек-ции,

- начальное значение вектора весовых коэффициентов,

- начальное значение вектора весовых коэффициентов,

определяется в соответствиис выражением(23).

определяется в соответствиис выражением(23).

5.6. На вход сети подается сигнал, характеризующий второй (меша-ющий) образ, на который реакция данного нейрона должна быть нулевой.

5.7. С учетом скорректированного значения весового вектора для этого сигнала определяется сетевая функция

net´i(μ)=  ,

,

где в качестве текущих значений составляющих весового вектора

выбираются их скорректированные значения.

5.8. Определяется ошибка обучения в соответствии с (24).

5.9. Полученное значение ошибки обучения сравнивается с макси-мально допустимой ошибкой δmax меш. Если  δmax меш, то кор-рекция значений составляющих вектора весовых коэффициентов

δmax меш, то кор-рекция значений составляющих вектора весовых коэффициентов  не производится и текущему значению вектора весовых коэффициентов при-сваивается значение, полученное на предыдущем шаге, то есть

не производится и текущему значению вектора весовых коэффициентов при-сваивается значение, полученное на предыдущем шаге, то есть  . Если

. Если  δmax меш, то производится вторая коррекция коррекция весового вектора в соответствии с выражением

δmax меш, то производится вторая коррекция коррекция весового вектора в соответствии с выражением

,

,

где  - значение вектора весовых коэффициентов после второй коррек-ции,

- значение вектора весовых коэффициентов после второй коррек-ции,

- значение вектора весовых коэффициентов после первой коррек-ции.

- значение вектора весовых коэффициентов после первой коррек-ции.

определяется в соответствиис выражением(23).

определяется в соответствиис выражением(23).

5.10. Процедуры 5.6 – 5.9 повторяются для всех мешающих для дан-ного нейрона сигналов.

5.11. Если для всех шагов (как при входном полезном сигнале, так и при входных мешающих сигналах) величина ошибок меньше предельно допус-тимых (то есть конечное значение весового вектора соответствует начально-му значению), то процесс обучения нейрона заканчивается. Если хотя бы на одном шаге производилась коррекция вектора весовых коэффициентов, то осуществляется переход ко второй итерации.

|

|

|

|

|

Дата добавления: 2014-12-16; Просмотров: 577; Нарушение авторских прав?; Мы поможем в написании вашей работы!