КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Лекция 26

|

|

|

|

В общем, коррекция (обновление) весового коэффициента  , связывающего вход p –го нейрона данного слоя с выходом q – го нейрона предшествующего слоя, определяется как

, связывающего вход p –го нейрона данного слоя с выходом q – го нейрона предшествующего слоя, определяется как

. (18)

. (18)

Здесь  - параметр скорости обучения,

- параметр скорости обучения,  - называется локальным градиентом [сравните с

- называется локальным градиентом [сравните с  (8),

(8),  (16) и

(16) и  (17а)] и

(17а)] и  - входной сигнал q –го нейрона.

- входной сигнал q –го нейрона.

Локальный градиент вычисляется рекуррентно для каждого нейрона и его выражение зависит от того, где расположен нейрон в выходном или скрытом слое:

1. Если q – й нейрон принадлежит выходному слою, то согласно (8а)

. (19)

. (19)

Оба сомножителя в произведении относятся к q –му нейрону.

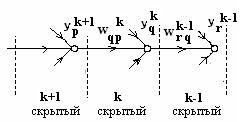

2. Если q – й нейрон расположен в k –ом скрытом слое (рис. 8), то согласно  (17а) при замене r на q, 2 на k, 1 на k - 1 и i на r,

(17а) при замене r на q, 2 на k, 1 на k - 1 и i на r,

получаем

, (20)

, (20)

где H – число скрытых слоев в нейронной сети, mk-1 -число нейронов (k - 1)-го скрытого слоя.

Рис. 8

Как видим,  представляет собой взвешенную сумму локальных градиентов

представляет собой взвешенную сумму локальных градиентов  нейронов, расположенных в (k - 1)-ом слое, непосредственно предшествующем k -омускрытому слою (считая, справа налево), причем

нейронов, расположенных в (k - 1)-ом слое, непосредственно предшествующем k -омускрытому слою (считая, справа налево), причем  и вычисляется по формуле (19), а

и вычисляется по формуле (19), а  , m0=m. Так при k = 1

, m0=m. Так при k = 1  что совпадает с (16а) при замене r на j и q на i.

что совпадает с (16а) при замене r на j и q на i.

Весовые коэффициенты связей, питающих выходной слой, обновляются за счет использования дельта-правила (18), в котором локальный градиент  определяется по выражению (19). Вычислив

определяется по выражению (19). Вычислив  для всех нейронов выходного слоя, мы затем используем (20), чтобы найти локальные градиенты

для всех нейронов выходного слоя, мы затем используем (20), чтобы найти локальные градиенты  для всех нейронов следующего слоя и изменить все весовые коэффициенты связей, питающих этот слой. Чтобы можно было вычислить

для всех нейронов следующего слоя и изменить все весовые коэффициенты связей, питающих этот слой. Чтобы можно было вычислить  для каждого нейрона, активационная функция

для каждого нейрона, активационная функция  всех нейронов должна быть дифференцируемой.

всех нейронов должна быть дифференцируемой.

Алгоритм. Алгоритм обратного распространения включает пять шагов.

а) Инициализация весовых коэффициентов. Установите все весовые коэффициенты равными небольшим случайным числам.

б) Предъявление входов и соответствующих им желаемых выходов (обучающие пары). Подаем на нейронную сеть вектор входа u и соответствующий желаемый вектор выхода d. Вход может быть новым в каждой новой попытке обучения или образцы из обучающего множества могут подаваться на сеть циклически до тех пор, пока весовые коэффициенты не стабилизируются, т.е. перестанут изменяться.

в) Вычисление действительных значений выхода. Вычисляем вектор выхода последовательно используя выражение  , где f есть вектор активационных функций.

, где f есть вектор активационных функций.

г) Настройка весовых коэффициентов. Начинаем настройку с весов выходного слоя и затем идем назад к последнему скрытому слою (считая справа налево). Весовые коэффициенты настраиваем с помощью

. (21)

. (21)

В этом уравнении  есть весовой коэффициент соединения, связывающего нейрон p скрытого слоя с нейроном q следующего слоя,

есть весовой коэффициент соединения, связывающего нейрон p скрытого слоя с нейроном q следующего слоя,  - выход нейрона p (или внешний вход для нейрона q),

- выход нейрона p (или внешний вход для нейрона q),  есть параметр скорости обучения и

есть параметр скорости обучения и  - градиент. Если нейрон q является нейроном выходного слоя, то

- градиент. Если нейрон q является нейроном выходного слоя, то  вычисляется с помощью (19)

вычисляется с помощью (19)  и если нейрон q является нейроном скрытого слоя, то

и если нейрон q является нейроном скрытого слоя, то  определяется с помощью (20)

определяется с помощью (20)  . Ускорение сходимости можно иногда обеспечить, если добавить значение момента.

. Ускорение сходимости можно иногда обеспечить, если добавить значение момента.

Замечание. Для пакетного режима обработки дельта-правило (6)  модифицируется

модифицируется

где  вычисляется в режиме онлайн и затем накапливается в процессе представления обучающих данных для

вычисляется в режиме онлайн и затем накапливается в процессе представления обучающих данных для  , как составная часть обратных вычислений. Как видим, весовые коэффициенты обновляются после представления всех обучающих данных. Алгоритм онлайн проще для реализации и требует меньше памяти, чем алгоритм офлайн. Однако алгоритм онлайн обеспечивает более точную оценку вектора градиента и более простую сходимость к локальному минимуму.

, как составная часть обратных вычислений. Как видим, весовые коэффициенты обновляются после представления всех обучающих данных. Алгоритм онлайн проще для реализации и требует меньше памяти, чем алгоритм офлайн. Однако алгоритм онлайн обеспечивает более точную оценку вектора градиента и более простую сходимость к локальному минимуму.

Пример (локальный градиент). Логистическая (сигмоидная) функция  дифференцируема, и ее производная имеет вид

дифференцируема, и ее производная имеет вид  . Мы можем исключить экспоненту и записать производную как

. Мы можем исключить экспоненту и записать производную как

. (22)

. (22)

Для нейрона j в выходном слое мы можем выразить локальный градиент как

. (23)

. (23)

Для нейрона i скрытого слоялокальный градиент равен

. (24)

. (24)

Пример (обратное распространение). Чтобыближе познакомиться с методом обратного распространения ошибки, рассмотрим простой пример с обучающим комплектом данных

|

|

|

|

|

Дата добавления: 2014-01-07; Просмотров: 486; Нарушение авторских прав?; Мы поможем в написании вашей работы!