КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Метод зворотного поширення похибки

|

|

|

|

(Error Back Propagation)

Метод зворотного поширення похибки вперше був сформульований

Вербосом 1974 року. Але визнаний він був значно пізніше, 1986 року,

коли його «перевідкрив» Румельхарт, Хінтон і Вільямс. За своєю суттю –

це метод градієнтного спуску, котрий застосовують для настроювання

вагових коефіцієнтів так, щоб мінімізувати функцію похибки (4.1).

Мінімізація за методом градієнтного спуску означає підстрою-

вання вагових коефіцієнтів

|

|

|

де wij – ваговий коефіцієнт синаптичного зв’язку, що з’єднує i -й ней-

рон шару n –1 з j -м нейроном шару n, η – коефіцієнт швидкості нав-

чання, 0< η <1. Користуючись правилами диференціального числен-

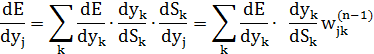

ня, можна записати:

| |||||

|

| ||||

|

|

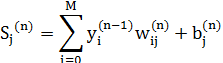

де yj – вихід j-го нейрона, а sj – зважена сума його вхідних сигналів, тобто аргумент його нелінійної активаційної функції:

Оскільки множник dy j  ds j є похідною цієї функції за її аргументом, то з цього випливає, що похідна активаційної функції повинна бути визначеною на всій осі абсцис. У зв’язку з цим активаційні функції з розривами першого і другого родів не підходять для нейронних мереж, що навчаються методом зворотного поширення похибки.

ds j є похідною цієї функції за її аргументом, то з цього випливає, що похідна активаційної функції повинна бути визначеною на всій осі абсцис. У зв’язку з цим активаційні функції з розривами першого і другого родів не підходять для нейронних мереж, що навчаються методом зворотного поширення похибки.

Наприклад, у випадку гіперболічного тангенса маємо:

Третій множник  дорівнює виходу i-го нейрона з попереднього шару,

дорівнює виходу i-го нейрона з попереднього шару,  . Щодо першого множника в (4.3), то його легко розкласти так:

. Щодо першого множника в (4.3), то його легко розкласти так:

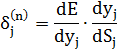

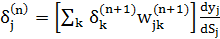

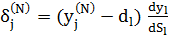

Тут додавання за k виконують серед нейронів шару n+1. Вводячи нову змінну

Отримуємо рекурсивну формулу для розрахунків величини  шару n за величинами

шару n за величинами  наступного шару n+1:

наступного шару n+1:

(4.4)

(4.4)

Для останнього ж, вихідного шару маємо:

(4.5)

(4.5)

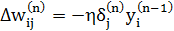

Тепер ми можемо записати (4.2) в розгорнутому вигляді:

(4.6)

(4.6)

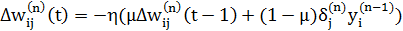

Інколи для надання процесу корекції ваг деякої інерційності, що згладжує різкі стрибки під час переміщення поверхнею цільової функції, вираз (4.6) доповнюється значенням зміни ваги на попередній ітерації:

, (4.7)

, (4.7)

де  - коефіцієнт інерційності, t- номер поточної ітерації.

- коефіцієнт інерційності, t- номер поточної ітерації.

Отже, повний алгоритм навчання ШНМ за допомогою процедури зворотного поширення похибки має такий вигляд:

Крок 1. Ініціалізація ваги і зміщення, які задають випадково.

Наприклад, в діапазоні від –1 до 1.

Крок 2. Розрахування виходу мережі і похибки за вектором входу і відповідним йому вектором бажаного виходу із еталонних даних.

Крок 3. Розрахування δ( N ) для вихідного шару за формулою (4.5).

Крок 4. Розрахування зміни ваг ∆w( N ) для вихідного шару за формулою (4.6) або (4.7).

Крок 5. Розрахування за формулами (4.4) і (4.6), або (4.4) і (4.7) відповідно δ( n) і ∆w( n) для всіх інших шарів.

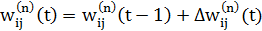

Крок 6. Коригування всіх ваг у ШНМ:

(4.8)

(4.8)

Крок 7. Перехід на крок 2, якщо похибка мережі суттєва, а якщо ні – то закінчення навчання.

4.4. Навчання нейронних мереж за допомогою генетичних алгоритмів

Оскільки навчання ШНМ – це пошук такого стану параметрів мережі (синаптичних ваг і порогових зміщень), який мінімізує функцію похибки, котру можна задати у вигляді (4.1). Одним із найбільш ефективних методів глобальної оптимізації є генетичні алгоритми (ГА). Під час використання ГА для навчання ШНМ параметрами оптимізації є синаптичні ваги і порогові зміщення. Функція пристосованості буде обернено пропорційною до функції похибки (4.1).

|

|

|

|

|

Дата добавления: 2014-11-16; Просмотров: 939; Нарушение авторских прав?; Мы поможем в написании вашей работы!