- Р Р‡.МессенРТвЂВВВВВВВВжер

- ВКонтакте

- РћРТвЂВВВВВВВВнокласснРСвЂВВВВВВВВРєРСвЂВВВВВВВВ

- РњРѕР№ Р В Р’В Р РЋРЎв„ўР В Р’В Р РЋРІР‚ВВВВВВВВРЎР‚

- LiveJournal

КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Энтропия источника дискретных сообщений

|

|

|

|

Человечество в прошлом не испытывало потребностей в количественном измерении информации. Такая потребность возникла в связи с развитием средств коммуникаций, измерительной техники, компьютерных систем.

Первую количественную метрику предложил Хартли в 1928 году и назвал её информационной емкостью.

Рассмотрим некоторую ячейку из n реле. Считая, что каждое реле может хранить два состояния m = 2, вся ячейка может содержать N = 2 n состояний. Хартли ввел двоичную логарифмическую меру, позволяющую измерять информацию в двоичных единицах – битах. Один бит – это количество информации, которое может храниться в элементарной ячейке на два состояния:  . В ячейке на

. В ячейке на  состояний хранится

состояний хранится  . Основание логарифма определяет размерность единиц измерения информации. Поскольку используют двоичные единицы – биты, основание логарифма опускают. Двоичная единица информации «бит» произошла от «сжатия» английских слов binary digit – двоичная единица.

. Основание логарифма определяет размерность единиц измерения информации. Поскольку используют двоичные единицы – биты, основание логарифма опускают. Двоичная единица информации «бит» произошла от «сжатия» английских слов binary digit – двоичная единица.

Такая мера является аддитивной, она позволяет осуществлять сложение информации в разных ячейках при объединении их в одну.

Мера Хартли (структурная метрика информации) не отражала вероятностного характера информации и не могла быть использована для оценки информационных свойств источников сообщений. В 1948 году Шенноном была предложена статистическая, т.е. вероятностная мера.

Пусть дискретный источник выдает сообщение а, принадлежащее некоторому конечному ансамблю А ( ). Определим количество информации, содержащееся в этом сообщении, используя три исходных естественных (очевидных) требования:

). Определим количество информации, содержащееся в этом сообщении, используя три исходных естественных (очевидных) требования:

1) количество информации должно быть аддитивной величиной, т. е. в двух независимых сообщениях количество информации определяется как сумма количеств информации в каждом из них;

2) количество информации в сообщении о достоверном событии равно 0;

3) количество информации не должно зависеть от качественного содержания сообщения (степени важности, возможных последствий его передачи, эмоциональной окраски и т. п.).

В общем случае сообщение а из ансамбля А характеризуется вероятностью  , что источник формирует или посылает это сообщение, т. е. количество информации I (a), содержащейся в сообщении а, должно быть функцией от вероятности

, что источник формирует или посылает это сообщение, т. е. количество информации I (a), содержащейся в сообщении а, должно быть функцией от вероятности  .

.

Воспользуемся далее требованием 1) (требованием аддитивности). Пусть а 1 и а 2 – два независимых сообщения. Вероятность  того, что источник выдаст одно за другим эти два сообщения

того, что источник выдаст одно за другим эти два сообщения

,

,

где  – вероятности формирования сообщения а 1 и а 2 соответственно.

– вероятности формирования сообщения а 1 и а 2 соответственно.

Общее количество информации I (a 1, а 2), содержащейся в этих двух сообщениях, согласно условию аддитивности определяется как сумма количеств информации в каждом из них:

.

.

Таким образом, надо найти функцию от вероятности  такую, чтобы при перемножении двух аргументов значения функции складывались. Этому условию удовлетворяет только логарифмическая функция

такую, чтобы при перемножении двух аргументов значения функции складывались. Этому условию удовлетворяет только логарифмическая функция

,

,

где k – произвольный коэффициент.

Логарифм, вообще говоря, может быть взят по любому основанию. Эта формула может быть использована для определения количества информации, содержащейся в сообщении аi. Эта формула удовлетворяет и требованию 2): в случае достоверного события вероятность сообщения  = 1. Тогда количество информации согласно полученной формуле:

= 1. Тогда количество информации согласно полученной формуле:

.

.

Поскольку  < 1, и следовательно, log

< 1, и следовательно, log  ≤ 0, то, чтобы измерять количество информации неотрицательными числами, выбираем значение коэффициента k = –1:

≤ 0, то, чтобы измерять количество информации неотрицательными числами, выбираем значение коэффициента k = –1:

.

.

Основание логарифма чаще всего в формуле для определения количества информации выбирают равным двум. Получаемая при этом единица информации носит название двоичная единица, или бит.

Такая единица наиболее удобна потому, что в современной вычислительной технике, технике связи широко используются двоичные коды, двоичные дискретные устройства.

Пусть дискретный источник сообщений вырабатывает полный ансамбль сообщений  , где

, где  – вероятность

– вероятность  -го сообщения. Этот источник может быть охарактеризован средним количеством информации, приходящимся на одно сообщение:

-го сообщения. Этот источник может быть охарактеризован средним количеством информации, приходящимся на одно сообщение:

.

.

Эту величину  Шеннон назвал энтропией источника. Понятие энтропии (от греческого «эн-тропе» – обращение) существовало и до Шеннона и распространилось на ряд областей знания. В термодинамике энтропия означает вероятность теплового состояния вещества, в математике – степень неопределенности ситуации или задачи, в информатике она характеризует способность источника отдавать информацию. Количество информации, которое переносится одним сообщением источника

Шеннон назвал энтропией источника. Понятие энтропии (от греческого «эн-тропе» – обращение) существовало и до Шеннона и распространилось на ряд областей знания. В термодинамике энтропия означает вероятность теплового состояния вещества, в математике – степень неопределенности ситуации или задачи, в информатике она характеризует способность источника отдавать информацию. Количество информации, которое переносится одним сообщением источника  . Эта мера вытекает из меры Хартли:

. Эта мера вытекает из меры Хартли:  и является ее обобщением на случай неравновероятности сообщений. Видно, что чем меньше вероятность сообщения, тем большее количество информации оно несет. Мера Шеннона также аддитивна.

и является ее обобщением на случай неравновероятности сообщений. Видно, что чем меньше вероятность сообщения, тем большее количество информации оно несет. Мера Шеннона также аддитивна.

И количество информации I в сообщении и энтропия источника H измеряются в одних единицах – в битах, но эти величины различны. Энтропия H источника определяет способность источника производить информацию; при наличии достаточной статистики она может быть вычислена априори, до получения сообщений. Получение информации I снимает часть неопределенности источника, уменьшает его энтропию. Это уменьшение энтропии происходит после (апостериори) получения сообщения, т.е. I определяется апостериорно. Таким образом, количество информации может рассматриваться как противоположность энтропии, в этом проявляется диалектический закон единства и борьбы противоположностей.

Энтропия источника дискретных сообщений обладает следующими свойствами:

1. Энтропия положительна.

2. Энтропия детерминированных сообщений равна нулю. Если одно из сообщений источника достоверно, т.е. его вероятность равна 1, то вероятности других сообщений равны нулю.

3. Энтропия максимальна, если сообщения источника равновероятны.

.

.

4. В случае равновероятных сообщений энтропия возрастает с увеличением числа сообщений.

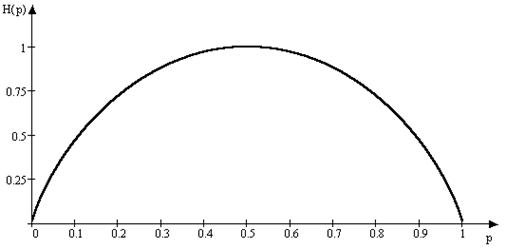

5. Энтропия источника бинарных (двоичных) сообщений изменяется от нуля до единицы в зависимости от вероятности сообщений и имеет максимум при  . В этом случае мера Шеннона совпадает с мерой Хартли. Источник с энтропией в 1 бит полностью согласован с каналом, например, реле, имеющим информационную емкость в 1 бит. При неравновероятности сообщений канал будет недогружен. Зависимость энтропии от вероятности для бинарного источника иногда называют функцией Шеннона (рис. 40). При большом числе сообщений источника и при равновероятности сообщений они могут быть переданы с помощью равномерного двоичного кода. Так, восемь сообщений кодируются: 000, 001, 010, 011, 100, 101, 110, 111. Энтропия источника равна трем:

. В этом случае мера Шеннона совпадает с мерой Хартли. Источник с энтропией в 1 бит полностью согласован с каналом, например, реле, имеющим информационную емкость в 1 бит. При неравновероятности сообщений канал будет недогружен. Зависимость энтропии от вероятности для бинарного источника иногда называют функцией Шеннона (рис. 40). При большом числе сообщений источника и при равновероятности сообщений они могут быть переданы с помощью равномерного двоичного кода. Так, восемь сообщений кодируются: 000, 001, 010, 011, 100, 101, 110, 111. Энтропия источника равна трем:  это совпадает со средним числом символов на сообщение. Иногда используется понятие удельной энтропии, это – энтропия, приходящаяся на один символ. Данный источник имеет энтропию 3 бита на сообщение, можно также сказать, что его энтропия 1 бит/символ. Такая оценка удобна при сравнении различных источников.

это совпадает со средним числом символов на сообщение. Иногда используется понятие удельной энтропии, это – энтропия, приходящаяся на один символ. Данный источник имеет энтропию 3 бита на сообщение, можно также сказать, что его энтропия 1 бит/символ. Такая оценка удобна при сравнении различных источников.

Рис 40

Рассмотрим, как можно использовать введенные понятия при вскрытии неопределенности источника.

Пример 1. Пусть, надо отгадать задуманное число от 1 до 32, задавая источнику двоичные вопросы. Так как задуманное число с равной вероятностью может быть любым, энтропия источника Н = log 32 = 5 бит/число. Задаем первый вопрос: Число в нижней половине? Ответ: да. Количество полученной от источника информации I = 1 бит. Энтропия источника уменьшилась и стала Н = 4 бит/число. Задавая подобный вопрос еще раз и получая любой ответ, мы сужаем диапазон поиска вдвое и уменьшаем неопределенность источника на один бит. Таких вопросов и ответов будет ровно пять, после чего энтропия источника будет равна нулю.

Пример 2. Предположим, среди 25 монет одна фальшивая, более легкая. Какое минимальное число взвешиваний на рычажных весах необходимо сделать для нахождения фальшивой монеты?

Прежде всего определяем энтропию источника. Так как весы могут быть в трех состояниях, каждое взвешивание уменьшает энтропию источника на одну троичную единицу информации. Поэтому монеты следует разделить на три примерно равные кучки: 8, 8 и 9 монет. Положив на чашки весов одинаковое число монет 8 и 8, определяем, есть ли среди них фальшивая и, если есть, то в какой чашке. Предположим, что первая кучка легче второй. Значит, монета здесь. Эту кучку делим на три части 3, 3 и 2. Взвешиваем одинаковые части. Допустим, они равны. Значит, искомая монета находится среди двух оставшихся. При третьем взвешивании монета найдена.

Число  характеризует число кодовых признаков, используемых при передаче сообщений. Это число определяет алфавит источника. При

характеризует число кодовых признаков, используемых при передаче сообщений. Это число определяет алфавит источника. При  удельная энтропия источника возрастает. В принципе, такой источник более эффективен, он позволяет передавать больше информации в единицу времени. Так, если алфавит источника равен 32 буквам, то энтропия источника – 5 бит/букву; если в китайском языке используется около 2000 иероглифов, то энтропия такого источника – 11 бит/иероглиф, т.е. 11 бит/символ. Ясно, что использование большого алфавита приводит к техническим сложностям, отсюда, наибольшее распространение в технике получил двоичный алфавит с буквами или символами 0 и 1. Источник, работающий на таком алфавите, не может иметь энтропию больше 1 бит/символ.

удельная энтропия источника возрастает. В принципе, такой источник более эффективен, он позволяет передавать больше информации в единицу времени. Так, если алфавит источника равен 32 буквам, то энтропия источника – 5 бит/букву; если в китайском языке используется около 2000 иероглифов, то энтропия такого источника – 11 бит/иероглиф, т.е. 11 бит/символ. Ясно, что использование большого алфавита приводит к техническим сложностям, отсюда, наибольшее распространение в технике получил двоичный алфавит с буквами или символами 0 и 1. Источник, работающий на таком алфавите, не может иметь энтропию больше 1 бит/символ.

Количество и качество информации помимо статистической теории могут характеризоваться также терминами структурной теории, рассматривающей строение массивов информации, а также семантической теории, учитывающей целесообразность, полезность и ценность информации.

|

|

|

Дата добавления: 2014-11-16; Просмотров: 4616; Нарушение авторских прав?; Мы поможем в написании вашей работы!