КАТЕГОРИИ:

Архитектура-(3434)Астрономия-(809)Биология-(7483)Биотехнологии-(1457)Военное дело-(14632)Высокие технологии-(1363)География-(913)Геология-(1438)Государство-(451)Демография-(1065)Дом-(47672)Журналистика и СМИ-(912)Изобретательство-(14524)Иностранные языки-(4268)Информатика-(17799)Искусство-(1338)История-(13644)Компьютеры-(11121)Косметика-(55)Кулинария-(373)Культура-(8427)Лингвистика-(374)Литература-(1642)Маркетинг-(23702)Математика-(16968)Машиностроение-(1700)Медицина-(12668)Менеджмент-(24684)Механика-(15423)Науковедение-(506)Образование-(11852)Охрана труда-(3308)Педагогика-(5571)Полиграфия-(1312)Политика-(7869)Право-(5454)Приборостроение-(1369)Программирование-(2801)Производство-(97182)Промышленность-(8706)Психология-(18388)Религия-(3217)Связь-(10668)Сельское хозяйство-(299)Социология-(6455)Спорт-(42831)Строительство-(4793)Торговля-(5050)Транспорт-(2929)Туризм-(1568)Физика-(3942)Философия-(17015)Финансы-(26596)Химия-(22929)Экология-(12095)Экономика-(9961)Электроника-(8441)Электротехника-(4623)Энергетика-(12629)Юриспруденция-(1492)Ядерная техника-(1748)

Пример 2.1

|

|

|

|

N,

(0 =

(2-88)

где Я - так называемый коэффициент забывания (forgetting factor), значение которого выбирается из интервала [0,1]. Обратим внимание на то, что степень влияния членов выражения (2.88) на его значение возрастает с увеличением номера члена. В ходе дальнейших рассуждений будем использовать обозначения, введенные в п. 2.5, с учетом особенностей, показанных на рис. 2.13, т.е.

(2.89)

а также

(2.90)

где /"-обратимая функция, t- 1,..., п, /'= 1,..., Nk, k- 1,..., L.

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

2.6. Применение рекуррентного метода наименьших квадратов

| |||

|

|

Выражение (2.93) задает способ последовательного определения погрешностей в каждом слое, начиная с последнего. При дальнейших преобразованиях получаем последовательность равенств вида

t=

у

|

| где |

| При использовании аппроксимации |

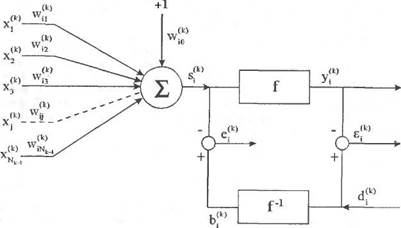

Рис. 2.13. Структура нейрона, применяемого для реализации алгоритма RLS.

Если рассчитать градиент меры погрешности и приравнять его к нулю, то получим уравнение

vi \П> f=1 j-

vi \П> f=1 j-

(2.91)

При использовании зависимостей (2.68) и (2.69) уравнение (2.91) принимает вид

' (0 =

=£/-;

1"'-0-(292)

где

(2-93)

| получаем нормальное уравнение л |

| векторная форма которого имеет вид |

(2.95) = 0, (2.96)

| где |

| t=-\ л |

(2.97) (2.98) (2.99)

Уравнение (2.97) можно решить рекуррентным способом, без инвертирования матрицы R(k\n). Это требует использования алгоритма RLS (например, [19]), согласно которому адаптивная коррекция всех весов w№ производится согласно правилам

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

2.6. Применение рекуррентного метода наименьших квадратов

| |||

| |||

|

| (2.101) (2.102) (2.103) |

СО/

Pi + f'2{s]k)(n))x^ (n)PJk\n-P}k\n) = X-\l-f'(s'i

Pi + f'2{s]k)(n))x^ (n)PJk\n-P}k\n) = X-\l-f'(s'i

где/=1....... Nk, /с=1,...,L.

где/=1....... Nk, /с=1,...,L.

Начальные значения в алгоритме RLS, как правило, устанавливаются следующим образом:

Р(к'(0) = 51, д»0, (2.104)

иЛк)(0) = 0. (2.105)

Начальные значения весов w№(0) нейронной сети могут также выбираться случайным способом из заранее установленного диапазона.

Сравним функционирование алгоритма обратного распространения ошибки (2.86), модифицированного алгоритма (2.87) и алгоритма RLS (2.103). Для этого двухслойную нейронную сеть с сигмоидальными функциями будем использовать для имитации логической системы XOR и декодера 4-2-4. Процесс имитации должен длиться достаточно долго для того, чтобы значение погрешности Q(n) стало меньше заданного порога у, т.е.

| (2.106) |

Q(n) =

где NL = 1 в случае логической системы XOR и NL = 4 в случае декодера 4-2-4. На рисунках, иллюстрирующих результаты моделирования, под эпохой (ер) понимается количество итераций, равное числу различных пар векторов входных и эталонных сигналов (один цикл предъявления обучающей выборки). В обоих примерах каждая эпоха состоит из четырех итераций обучающего алгоритма.

а) Логическая система XOR. Нейронная сеть имеет 2 входа, 2 ней

рона в скрытом слое и 1 выход. Заданный порог /равен 0.02. В отдель

ные эпохи выделены следующие пары векторов входных и эталонных

сигналов:

(0,0; 0), (0,1; 1), (1,0; 1), (1,1; 0). Результаты моделирования представлены на рис. 2.14.

б) Декодер 4-2-4. Нейронная сеть имеет 4 входа, 2 нейрона

в скрытом слое и 4 нейрона в выходном слое. Заданный порог у ра

вен 0,02. В отдельные эпохи выделены следующие пары векторов

входных и эталонных сигналов:

б)

| 120 160 200 |

в)

Рис. 2.14. Результаты моделирования логической системы XOR: а) алгоритм обратного распространения ошибки; б) модифицированный алгоритм обратного распространения ошибки (с учетом момента); в) алгоритм RLS.

| юния |

Глава 2. Многослойные нейронные сети и алгоритмы их oбy^

Список литературы

----- 0.9

----- 0.9

|

|

|

|

|

Дата добавления: 2015-06-04; Просмотров: 394; Нарушение авторских прав?; Мы поможем в написании вашей работы!